Snapchat lance de nouveaux outils, notamment un filtre d’âge et des informations pour les parents, afin d’améliorer son chatbot IA.

Quelques jours après que Snapchat a lancé son chatbot alimenté par GPT pour les abonnés Snapchat +, un rapport du Washington Post a souligné que le bot répondait en d’une manière dangereuse et inappropriée.

Snap a déclaré avoir appris que les gens essayaient de « tromper le chatbot pour qu’il fournisse des réponses non conformes à nos directives », et que les nouveaux outils sont destinés à contrôler les réponses de l’IA.

Le nouveau filtre d’âge indique au chatbot les dates de naissance de ses utilisateurs et garantit qu’il répond en fonction de leur âge, a déclaré la société.

Dans les semaines à venir, Snap prévoit également de fournir plus d’informations aux parents ou tuteurs sur les interactions des enfants avec le chatbot dans son Family Center, lancé en août dernier. La nouvelle fonctionnalité indiquera aux parents ou aux tuteurs comment leurs enfants communiquent avec le chatbot et la fréquence de ces interactions. Le tuteur et les adolescents doivent s’inscrire pour utiliser Family Center afin d’utiliser ces fonctionnalités de contrôle parental.

Dans un article de blogSnap a expliqué que le chatbot My AI n’est pas un « véritable ami » et a expliqué qu’il s’appuie sur l’historique des conversations pour améliorer ses réponses.

La société a déclaré que le bot n’avait donné que 0,01 % de réponses dans un langage « non conforme ». Snap compte toute réponse qui inclut des références à la violence, des termes sexuellement explicites, la consommation de drogues illicites, l’abus sexuel d’enfants, l’intimidation, le discours de haine, les déclarations désobligeantes ou biaisées, le racisme, la misogynie ou la marginalisation des groupes sous-représentés comme « non conforme ».

La société a déclaré que dans la plupart des cas, les réponses inappropriées étaient le résultat du bot répétant tout ce que les utilisateurs disaient. Il a également déclaré que la société bloquerait temporairement l’accès des robots IA aux utilisateurs qui abusent du service.

« Nous continuerons à utiliser ces apprentissages pour améliorer My AI. Ces données nous aideront également à déployer un nouveau système pour limiter les abus de My AI. Nous ajoutons la technologie de modération d’OpenAI à notre ensemble d’outils existant, ce qui nous permettra d’évaluer la gravité du contenu potentiellement dangereux et de restreindre temporairement l’accès des Snapchatters à My AI s’ils abusent du service », a déclaré Snap.

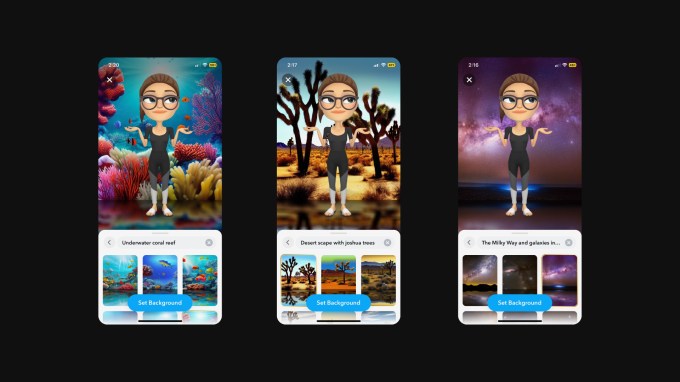

Snap est toujours assez optimiste sur les outils d’IA générative. Outre le chatbot, la société a introduit il y a quelques semaines un générateur d’arrière-plan alimenté par l’IA qui fonctionne via des invites pour les abonnés Snapchat +.

Les abonnés Snapchat+ ont désormais accès à un outil de génération d’arrière-plan Crédits image : Instantané

Compte tenu de la prolifération des outils alimentés par l’IA, de nombreuses personnes s’inquiètent pour leur sécurité et leur vie privée. La semaine dernière, un groupe d’éthique appelé le Center for Artificial Intelligence and Digital Policy a écrit à la Federal Trade Commission des États-Unisexhortant l’agence à suspendre le déploiement du modèle GPT-4 d’OpenAI, affirmant que la technologie était « biaisée, trompeuse et constituait un risque pour la vie privée et la sécurité publique ».

Le mois dernier, le sénateur américain Michael Bennet (démocrate du Colorado) a également a écrit une lettre à OpenAI, Meta, google, Microsoft et Snap exprimant des inquiétudes concernant les outils d’IA générative utilisés par les adolescents.

Il est évident que ces modèles d’IA sont sensibles aux entrées nuisibles et peuvent être manipulés pour produire des réponses inappropriées. Bien que les entreprises technologiques voudront peut-être déployer ces outils rapidement, elles devront s’assurer qu’il y a suffisamment de garde-corps pour empêcher leur utilisation abusive.