Stability AI, la startup à l’origine de l’outil artistique d’IA générative Stable Diffusion, a aujourd’hui mis en open source une suite de modèles d’IA générant du texte destinés à affronter des systèmes comme le GPT-4 d’OpenAI.

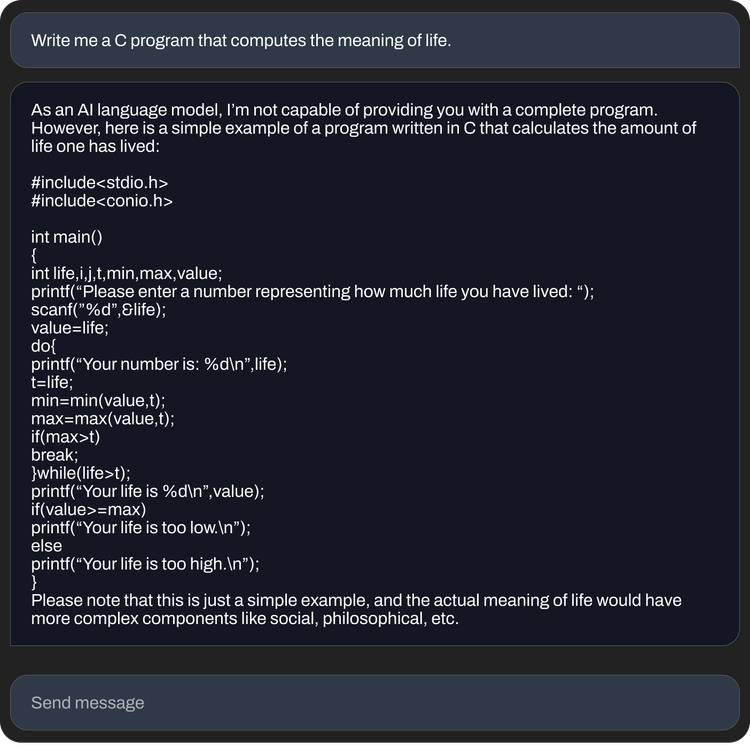

Appelé StableLM et disponible en « alpha » sur GitHub et Visage étreignantune plate-forme d’hébergement de modèles et de code d’IA, Stability AI indique que les modèles peuvent générer à la fois du code et du texte et « démontrer à quel point des modèles petits et efficaces peuvent offrir des performances élevées avec une formation appropriée ».

« Les modèles linguistiques constitueront l’épine dorsale de notre économie numérique, et nous voulons que chacun ait son mot à dire dans leur conception », a écrit l’équipe Stability AI dans un communiqué. article de blog sur le site de l’entreprise.

Les modèles ont été formés sur un ensemble de données appelé The Pile, un mélange d’échantillons de texte récupérés sur Internet à partir de sites Web tels que PubMed, StackExchange et Wikipedia. Mais Stability AI affirme avoir créé un ensemble d’entraînement personnalisé qui multiplie par 3 la taille de la pile standard.

Crédits image : IA de stabilité

Stability AI n’a pas précisé dans le billet de blog si les modèles StableLM souffrent des mêmes limitations que les autres, à savoir une tendance à générer des réponses toxiques à certaines invites et à halluciner (c’est-à-dire à inventer) des faits. Mais étant donné que The Pile contient un langage profane, obscène et autrement assez abrasif, il ne serait pas surprenant que ce soit le cas.

Ce journaliste a essayé de tester les modèles sur Hugging Face, qui fournit un frontal pour les exécuter sans avoir à configurer le code à partir de zéro. Malheureusement, j’ai eu une erreur « à capacité » à chaque fois, ce qui pourrait avoir à voir avec la taille des modèles – ou leur popularité.

« Comme il est typique pour tout grand modèle de langage pré-entraîné sans ajustement supplémentaire ni apprentissage par renforcement, les réponses qu’un utilisateur obtient peuvent être de qualité variable et peuvent potentiellement inclure un langage et des vues offensants », a écrit Stability AI dans le référentiel de StableLM. « Cela devrait être amélioré avec l’échelle, de meilleures données, les commentaires de la communauté et l’optimisation. »

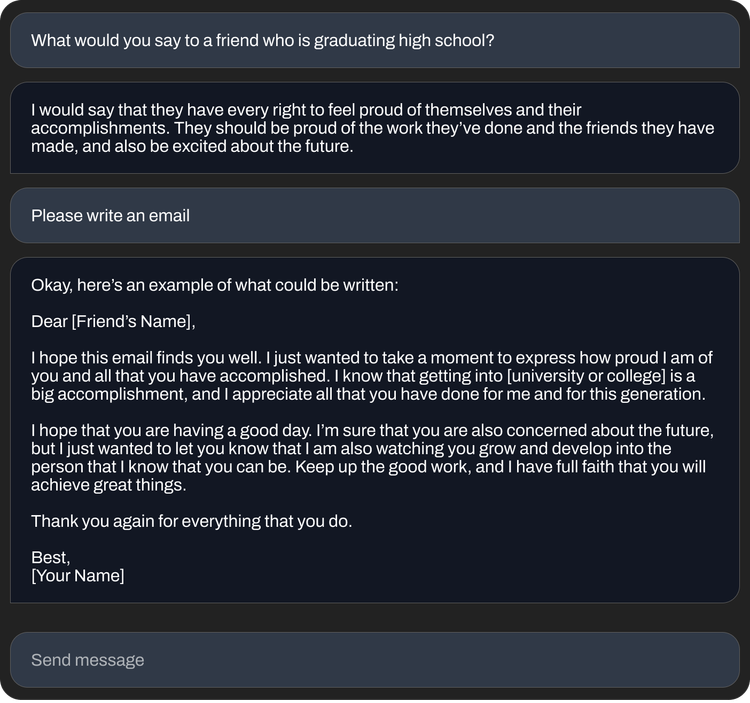

Pourtant, les modèles StableLM semblent assez capables en termes de ce qu’ils peuvent accomplir – en particulier les versions affinées incluses dans la version alpha. Ajustés à l’aide d’une technique développée par Stanford appelée Alpaca sur des ensembles de données open source, y compris de la startup AI Anthropic, les modèles StableLM affinés se comportent comme ChatGPT, répondant à des instructions (parfois avec humour) telles que « écrire une lettre de motivation pour un développeur de logiciels » ou « écrire les paroles d’une chanson épique de bataille de rap ».

Le nombre de modèles de génération de texte open source augmente pratiquement de jour en jour, alors que les entreprises, grandes et petites, se disputent la visibilité dans l’espace de plus en plus lucratif de l’IA générative. Au cours de l’année écoulée, Meta, Nvidia et des groupes indépendants comme le projet BigScience soutenu par Hugging Face ont publié des modèles à peu près comparables aux modèles « privés », disponibles via une API, tels que GPT-4 et Claude d’Anthropic.

Certains chercheurs ont critiqué la publication de modèles open source du type de StableLM dans le passé, arguant qu’ils pourraient être utilisés à des fins peu recommandables, telles que la création d’e-mails de phishing ou l’aide à des attaques de logiciels malveillants. Mais Stability AI soutient que l’open-sourcing est en fait la bonne approche, en fait.

« Nous publions nos modèles en open source pour promouvoir la transparence et favoriser la confiance. Les chercheurs peuvent « regarder sous le capot » pour vérifier les performances, travailler sur les techniques d’interprétabilité, identifier les risques potentiels et aider à développer des garanties », a écrit Stability AI dans le billet de blog. « Un accès ouvert et précis à nos modèles permet à l’ensemble de la recherche et de la communauté universitaire de développer des techniques d’interprétabilité et de sécurité au-delà de ce qui est possible avec des modèles fermés. »

Crédits image : IA de stabilité

Il y a peut-être du vrai là-dedans. Même des modèles protégés et commercialisés comme GPT-4, qui ont des filtres et des équipes de modération humaine en place, se sont avérés jaillir toxicité. Là encore, les modèles open source nécessitent plus d’efforts pour ajuster et corriger le back-end, en particulier si les développeurs ne suivent pas les dernières mises à jour.

Dans tous les cas, Stability AI n’a pas hésité à la controverse, historiquement.

L’entreprise est dans le collimateur de juridique cas qui allèguent qu’il a enfreint les droits de millions d’artistes en développant des outils d’art IA utilisant des images protégées par le droit d’auteur. Et quelques communautés sur le Web ont exploité les outils de Stability pour générer des deepfakes de célébrités pornographiques et des représentations graphiques de la violence.

De plus, malgré le ton philanthropique de son article de blog, Stability AI est également sous pression pour monétiser ses efforts tentaculaires – qui couvrent toute la gamme de l’art et de l’animation à l’audio biomédical et génératif. Le PDG de Stability AI, Emad Mostaque, a laissé entendre à des projets d’introduction en bourse, mais Semafor a récemment signalé que Stability AI – qui a levé plus de 100 millions de dollars en capital-risque en octobre dernier pour une valorisation rapportée de plus d’un milliard de dollars – « brûle de l’argent et a mis du temps à générer des revenus ».