Prospective : Ils sont d’abord venus pour notre art, puis ils sont venus pour nos textes et nos essais tronqués. Maintenant, ils viennent pour la musique, avec un « nouvel » algorithme d’apprentissage automatique qui adapte la génération d’images pour créer, interpoler et boucler de nouveaux clips et genres musicaux.

Seth Forsgren et Hayk Martiros ont adapté l’algorithme de diffusion stable (SD) à la musique, créant ainsi un nouveau type de « machine à musique » étrange. diffusion fonctionne sur le même principe que SD, transformant une invite de texte en nouveau contenu généré par l’IA. La principale différence est que l’algorithme a été spécialement formé avec des sonogrammes, qui peuvent représenter la musique et l’audio sous forme visuelle.

Comme expliqué sur le Site internet de Riffusion, un sonagramme (ou un spectrogramme pour les fréquences audio) est un moyen visuel de représenter le contenu fréquentiel d’un clip audio. L’axe X représente le temps, tandis que l’axe Y représente la fréquence. La couleur de chaque pixel donne l’amplitude de l’audio à la fréquence et à l’heure données par sa ligne et sa colonne.

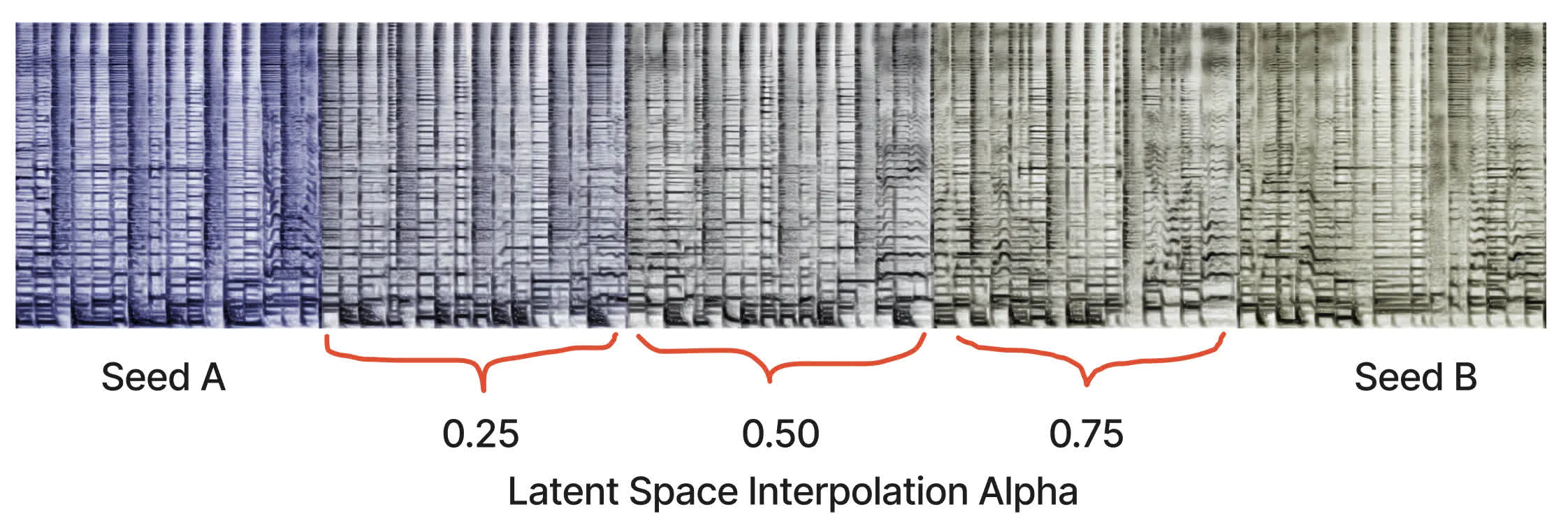

Riffusion adapte la v1.5 de l’algorithme visuel Stable Diffusion « sans aucune modification », juste quelques réglages fins pour mieux traiter les images de sonogrammes/spectogrammes audio couplés avec du texte. Le traitement audio se produit en aval du modèle, tandis que l’algorithme peut également générer des variations infinies d’une invite en faisant varier la graine.

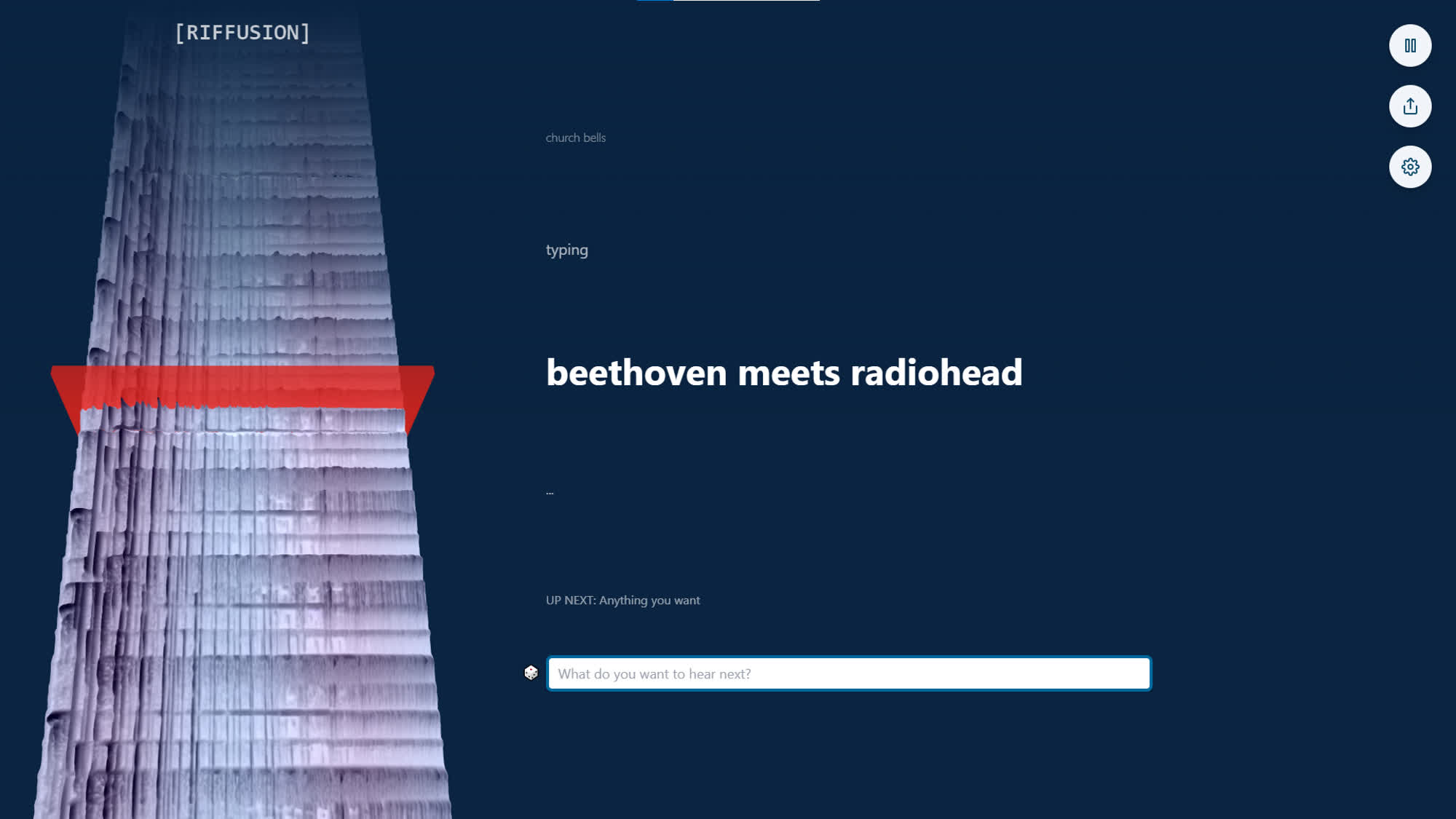

Après avoir généré un nouveau sonagramme, Riffusion transforme l’image en son avec Torchaudio. L’IA a été formée avec des spectrogrammes représentant des sons, des chansons ou des genres, de sorte qu’elle peut générer de nouveaux clips sonores basés sur toutes sortes d’invites textuelles. Quelque chose comme « Beethoven rencontre Radiohead », par exemple, qui est un bel exemple de la façon dont les algorithmes d’apprentissage automatique d’un autre monde ou étranges peuvent se comporter.

Après avoir conçu la théorie, Forsgren et Martiros ont tout rassemblé dans une application Web interactive où les utilisateurs peuvent expérimenter l’IA. Riffusion prend des invites de texte et « génère à l’infini du contenu interpolé en temps réel, tout en visualisant la chronologie du spectrogramme en 3D ». L’audio passe en douceur d’un clip à l’autre ; s’il n’y a pas de nouvelle invite, l’application interpole entre différentes graines de la même invite.

Riffusion s’appuie sur de nombreux projets open source, à savoir Next.js, React, Typescript, three.js, Tailwind et Vercel. Le code de l’application a son propre référentiel Github ainsi que.

Loin d’être la première IA générant de l’audio, Riffusion est encore une autre progéniture de la renaissance du ML qui a déjà conduit au développement de Dance Diffusion, OpenAI’s Jukebox, Soundraw et d’autres. Ce ne sera pas le dernier non plus.