Dans le contexte: Les jeux d’aujourd’hui utilisent des textures très détaillées qui peuvent rapidement remplir le tampon d’image sur de nombreuses cartes graphiques, entraînant des saccades et des plantages de jeu dans les titres AAA récents pour de nombreux joueurs. Les fabricants de GPU étant avares de VRAM, même sur les modèles de milieu de gamme les plus récents, il incombe aux ingénieurs en logiciel de trouver un moyen de tirer davantage parti du matériel disponible aujourd’hui. Peut-être ironiquement, le développement le plus prometteur dans cette direction à ce jour vient de Nvidia – la compression de texture neurale pourrait réduire la configuration système requise pour les futurs titres AAA, du moins en ce qui concerne la VRAM et le stockage.

L’un des sujets les plus brûlants du moment est centré sur les jeux AAA modernes et leurs exigences système. Les spécifications minimales et recommandées ont augmenté, et comme nous l’avons vu avec des titres comme The Last of Us Part I, Forspoken, The Callisto Protocol et Hogwarts Legacy, les exécuter même à 1080p en utilisant le préréglage Ultra pose désormais des problèmes pour les graphiques cartes équipées de 8 Go de VRAM.

En regardant la dernière enquête Steam, nous constatons que 8 Go est la taille de VRAM la plus courante pour les PC dotés de solutions graphiques dédiées. Cela ne changera probablement pas avant un certain temps, d’autant plus que les mises à niveau des cartes graphiques sont encore coûteuses et que les fabricants de GPU ne semblent pas intéressés à offrir plus de 8 Go de mémoire graphique sur la plupart des modèles grand public.

Lisez aussi : Pourquoi les jeux PC modernes utilisent-ils autant de VRAM ?

La bonne nouvelle est que Nvidia travaille sur une solution qui pourrait réduire l’utilisation de la VRAM. Dans une recherche papier publié cette semaine, la société détaille un nouvel algorithme de compression de texture qui est censé être meilleur que les méthodes traditionnelles de compression de blocs (BC) ainsi que d’autres techniques de compression avancées telles que AVIF et JPEG-XL.

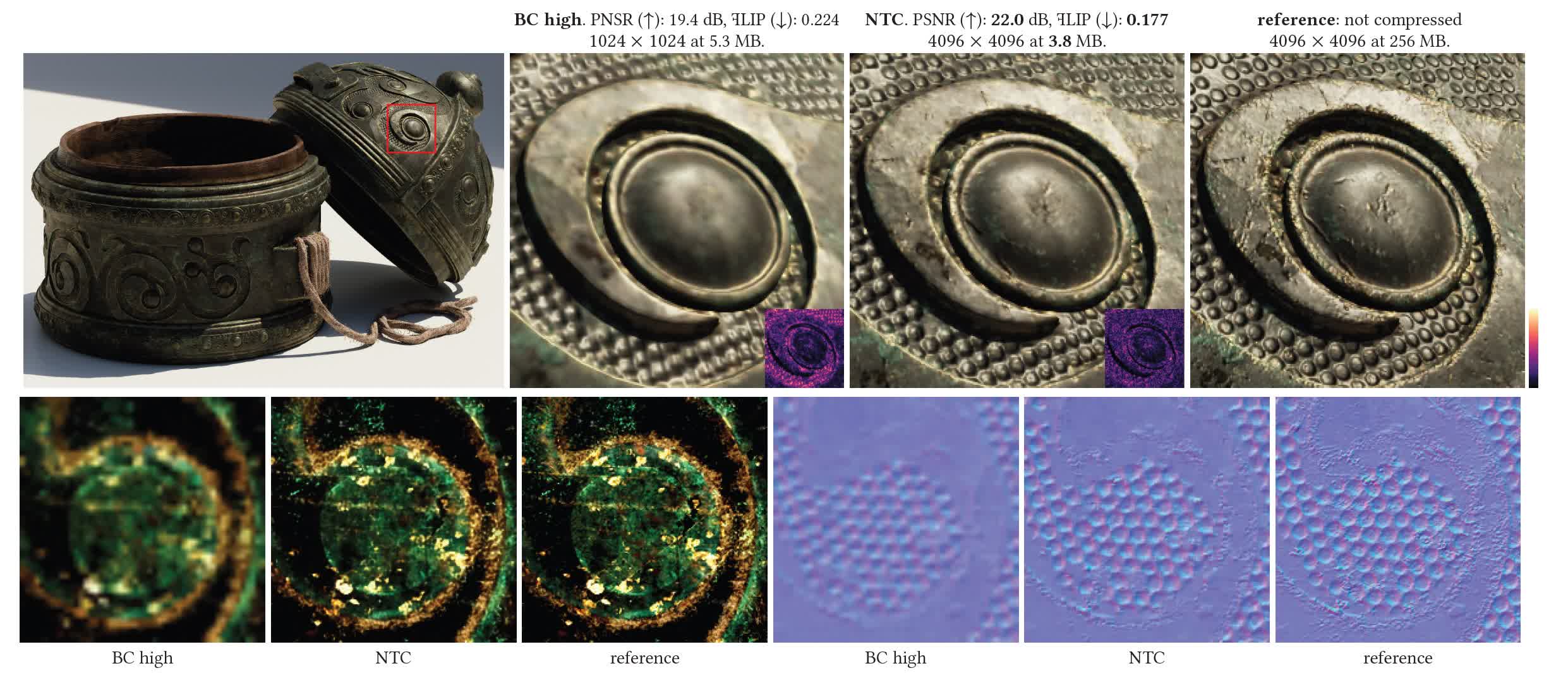

Le nouvel algorithme est simplement appelé compression de texture neuronale (NTC) et, comme son nom l’indique, il utilise un réseau neuronal conçu spécifiquement pour les textures matérielles. Pour rendre cela suffisamment rapide pour une utilisation pratique, les chercheurs de Nvidia ont construit plusieurs petits réseaux de neurones optimisés pour chaque matériau. Comme vous pouvez le voir sur l’image ci-dessus, les textures compressées avec NTC conservent beaucoup plus de détails tout en étant nettement plus petites que même ces mêmes textures compressées avec les techniques BC à un quart de la résolution d’origine.

Dans les jeux modernes, les propriétés visuelles d’un matériau sont stockées dans des cartes séparées qui décrivent comment il absorbe et réfléchit la lumière, et l’assortiment utilisé varie d’un moteur de jeu à l’autre. Chaque carte contient généralement des versions supplémentaires et réduites de la carte d’origine dans le même fichier. Ces soi-disant « mipmaps » sont utilisés pour optimiser l’utilisation de la mémoire graphique lorsque la pleine résolution de la texture n’est pas nécessaire, par exemple lorsqu’un objet particulier est éloigné de votre point de vue.

Lisez également : Comment fonctionne le rendu de jeu 3D : texturation

Les chercheurs expliquent que l’idée derrière leur approche est de compresser toutes ces cartes avec leur chaîne mipmap dans un seul fichier, puis de les faire décompresser en temps réel avec le même accès aléatoire que la compression de texture de bloc traditionnelle.

Compresser des dizaines de milliers de textures uniques pour un jeu prend également du temps, mais Nvidia affirme que le nouvel algorithme est censé être dix fois plus rapide que les implémentations typiques de PyTorch. Par exemple, une texture de matériau 4K à 9 canaux peut être compressée en une à 15 minutes à l’aide d’un Nvidia RTX 4090, selon le niveau de qualité que vous définissez. Les chercheurs notent que NTC prend en charge les textures avec des résolutions allant jusqu’à 8K (8 192 par 8 192) mais n’a pas proposé de chiffres de performance pour un tel scénario.

Un avantage évident est que les développeurs de jeux pourront utiliser NTC pour, espérons-le, réduire les besoins en stockage et en VRAM pour les futurs jeux, ou, à tout le moins, réduire le bégaiement en ajustant plus de textures dans le même tampon de trame et en réduisant ainsi le besoin de les échanger. entrer et sortir lorsque vous vous déplacez dans un environnement détaillé. Un autre avantage est que NTC s’appuie sur la multiplication matricielle, qui est rapide sur les GPU modernes et encore plus rapide lors de l’utilisation de Tensor Cores sur les GPU GeForce RTX.

Cependant, NTC a certaines limites qui peuvent limiter son attrait. Tout d’abord, comme pour toute compression avec perte, elle peut introduire une dégradation visuelle à des débits binaires faibles. Les chercheurs ont observé un léger flou, la suppression des détails fins, des bandes de couleur, des changements de couleur et des fuites entre les canaux de texture.

De plus, les artistes du jeu ne pourront pas optimiser les textures de la même manière qu’ils le font aujourd’hui, par exemple en réduisant la résolution de certaines cartes de texture pour des objets ou des PNJ moins importants. Nvidia indique que toutes les cartes doivent avoir la même taille avant la compression, ce qui compliquera forcément les flux de travail. Cela semble encore pire si l’on considère que les avantages du NTC ne s’appliquent pas à des distances de caméra plus grandes.

Les plus gros inconvénients de NTC sont peut-être liés au filtrage de texture. Comme nous l’avons vu avec des technologies telles que DLSS, il existe un potentiel de scintillement d’image et d’autres artefacts visuels lors de l’utilisation de textures compressées via NTC. Et tandis que les jeux peuvent utiliser le filtrage anisotrope pour améliorer l’apparence des textures à distance à un coût de performance minimal, la même chose n’est pas possible avec le NTC de Nvidia à ce stade.

Les geeks graphiques et les développeurs de jeux qui veulent se plonger profondément dans NTC peuvent trouver le papier ici – ça vaut vraiment la peine d’être lu. Nvidia présentera également le nouvel algorithme au SIGGRAPH 2023, qui débutera le 6 août.