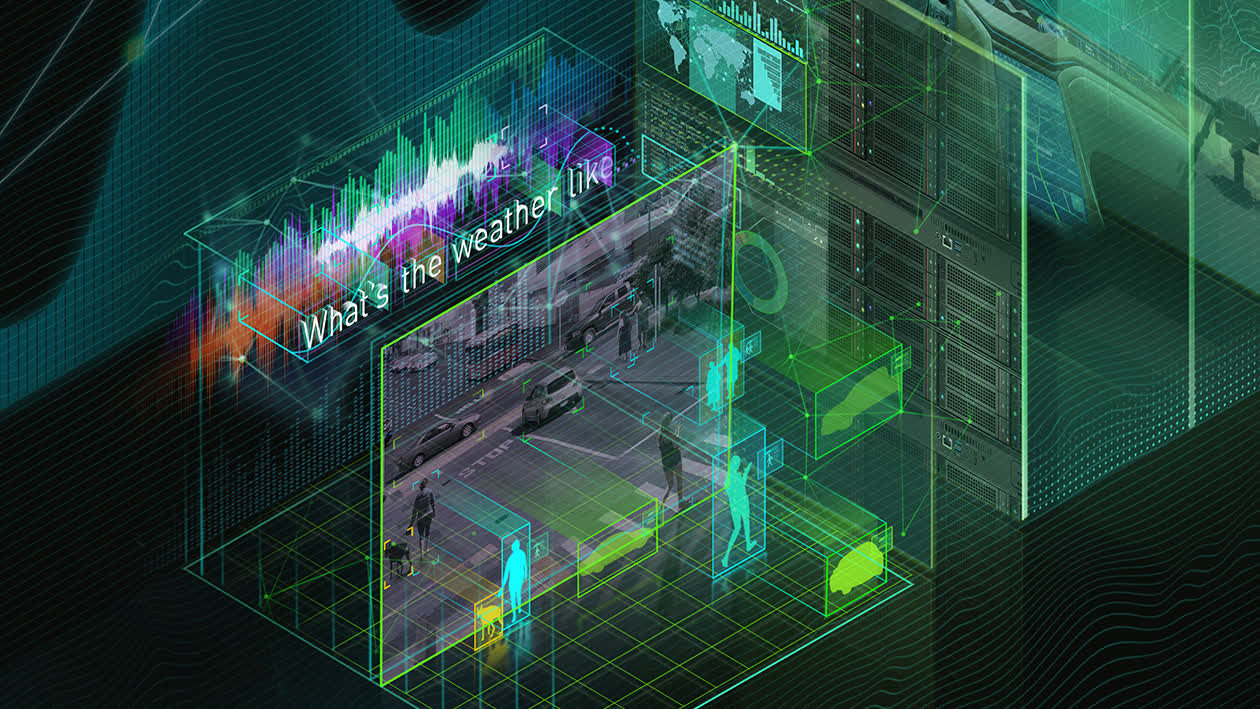

Les puces AI remplissent deux fonctions. Les constructeurs d’IA prennent d’abord un ensemble de données volumineux (ou vraiment massif) et exécutent des logiciels complexes pour rechercher des modèles dans ces données. Ces modèles sont exprimés sous forme de modèle, et nous avons donc des puces qui « entraînent » le système pour générer un modèle.

Ensuite, ce modèle est utilisé pour faire une prédiction à partir d’un nouvel élément de données, et le modèle déduit un résultat probable à partir de ces données. Ici, les puces d’inférence exécutent les nouvelles données par rapport au modèle qui a déjà été formé. Ces deux finalités sont très différentes.

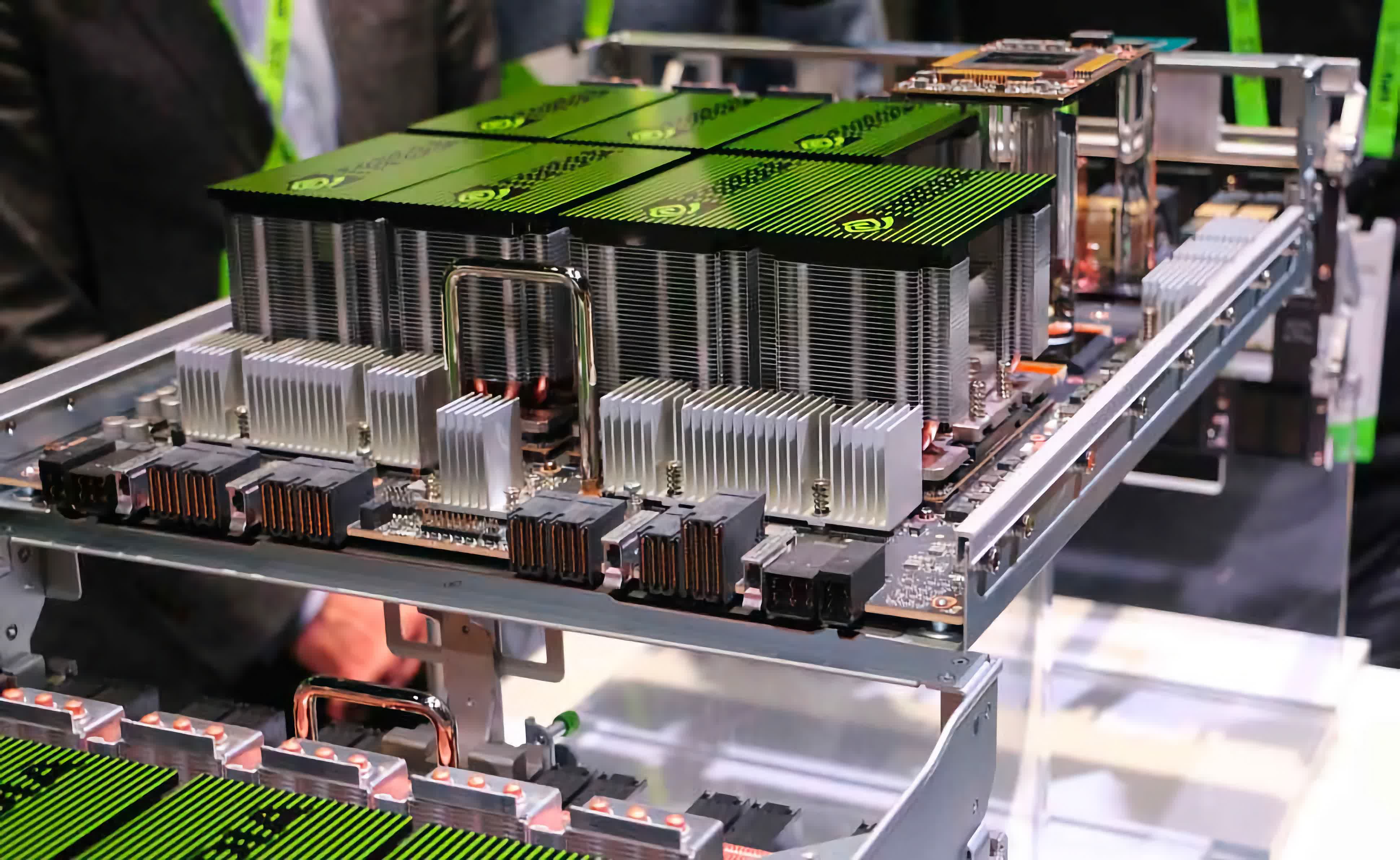

Les puces d’entraînement sont conçues pour fonctionner à fond, parfois pendant des semaines, jusqu’à ce que le modèle soit terminé. Les jetons d’entraînement ont donc tendance à être gros, « en fer lourd ».

Les puces d’inférence sont plus diverses, certaines d’entre elles sont utilisées dans les centres de données, d’autres sont utilisées à la « périphérie » dans des appareils comme les smartphones et les caméras vidéo. Ces puces ont tendance à être plus variées, conçues pour optimiser différents aspects comme l’efficacité énergétique à la périphérie. Et, bien sûr, il y a toutes sortes de variantes intermédiaires. Le fait est qu’il existe de grandes différences entre les « puces IA ».

Pour les concepteurs de puces, ce sont des produits très différents, mais comme pour tout ce qui concerne les semi-conducteurs, ce qui compte le plus, c’est le logiciel qui les exécute. Vue sous cet angle, la situation est beaucoup plus simple, mais aussi d’une complexité vertigineuse.

Simple parce que les puces d’inférence n’ont généralement besoin que d’exécuter les modèles qui proviennent des puces d’apprentissage (oui, nous simplifions à outrance). C’est compliqué car les logiciels qui tournent sur les puces d’entraînement sont extrêmement variés. Et c’est crucial. Il existe des centaines, voire des milliers, de frameworks actuellement utilisés pour les modèles de formation. Il existe des bibliothèques open source incroyablement bonnes, mais de nombreuses grandes sociétés d’IA / hyperscalers créent également les leurs.

Parce que le domaine des frameworks logiciels de formation est si fragmenté, il est effectivement impossible de construire une puce optimisée pour eux. Comme nous l’avons souligné dans le passé, de petits changements dans le logiciel peuvent effectivement neutraliser les gains fournis par les puces à usage spécial. De plus, les personnes qui gèrent le logiciel de formation souhaitent que ce logiciel soit hautement optimisé pour le silicium sur lequel il s’exécute. Les programmeurs exécutant ce logiciel ne veulent probablement pas s’amuser avec les subtilités de chaque puce, leur vie est déjà assez difficile pour construire ces systèmes de formation. Ils ne veulent pas avoir à apprendre le code de bas niveau pour une seule puce pour avoir à réapprendre les hacks et les raccourcis pour une nouvelle plus tard. Même si cette nouvelle puce offre « 20 % » de meilleures performances, les tracas liés à la réoptimisation du code et à l’apprentissage de la nouvelle puce rendent cet avantage inutile.

Ce qui nous amène à CUDA – le cadre de programmation de puces de bas niveau de Nvidia. À ce stade, tout ingénieur logiciel travaillant sur des systèmes de formation en sait probablement assez sur l’utilisation de CUDA. CUDA n’est pas parfait, ni élégant, ni particulièrement facile, mais il est familier. Sur de tels caprices sont bâties de vastes fortunes. Parce que l’environnement logiciel pour la formation est déjà si diversifié et évolue rapidement, la solution par défaut pour les puces de formation est les GPU Nvidia.

Le marché de toutes ces puces IA représente actuellement quelques milliards de dollars et devrait croître de 30 % ou 40 % par an dans un avenir prévisible. Une étude de McKinsey (peut-être pas la source la plus autorisée ici) évalue le marché des puces IA des centres de données entre 13 et 15 milliards de dollars d’ici 2025 – en comparaison, le marché total des processeurs est d’environ 75 milliards de dollars actuellement.

Sur ce marché de l’IA de 15 milliards de dollars, il se décompose en environ les deux tiers en inférence et un tiers en formation. Il s’agit donc d’un marché important. Un hic dans tout cela est que les puces d’entraînement coûtent environ 1 000 $ ou même 10 000 $, tandis que les puces d’inférence coûtent plus de 100 $, ce qui signifie que le nombre total de puces d’entraînement ne représente qu’une infime partie du total, environ 10 à 20 % des unités.

À long terme, cela jouera un rôle important dans la façon dont le marché prendra forme. Nvidia va avoir beaucoup de marge de formation, qu’elle peut apporter pour concourir sur le marché de l’inférence, de la même manière qu’Intel utilisait autrefois des processeurs de PC pour remplir ses usines et des processeurs de centre de données pour générer une grande partie de ses bénéfices.

Pour être clair, Nvidia n’est pas le seul acteur sur ce marché. AMD fabrique également des GPU, mais n’a jamais développé d’alternative efficace (ou du moins largement adoptée) à CUDA. Ils détiennent une part assez faible du marché des GPU IA, et nous ne voyons pas cela changer de sitôt.

Lisez aussi : Pourquoi Amazon construit-il des processeurs ?

Il existe un certain nombre de startups qui ont essayé de créer des puces de formation, mais celles-ci se sont principalement empalées sur le problème logiciel ci-dessus. Et pour ce que ça vaut, AWS a également déployé sa propre puce de formation conçue en interne, intelligemment nommée Trainium. D’après ce que nous pouvons dire, cela a rencontré un succès modeste, AWS n’a ici aucun avantage clair autre que ses propres charges de travail internes (massives). Cependant, nous comprenons qu’ils avancent avec la prochaine génération de Trainium, ils doivent donc être satisfaits des résultats jusqu’à présent.

Certains des autres hyperscalers peuvent également construire leurs propres puces de formation, notamment Google, qui propose bientôt de nouvelles variantes de son TPU spécialement conçues pour la formation. Et c’est le marché. En termes simples, nous pensons que la plupart des personnes sur le marché de l’informatique de formation chercheront à créer leurs modèles sur les GPU Nvidia.