Paume faciale : Les utilisateurs ont repoussé les limites de la nouvelle recherche alimentée par l’IA de Bing depuis sa sortie en avant-première, suscitant des réponses allant de réponses incorrectes à des demandes de respect. L’afflux de mauvaise presse qui en résulte a incité Microsoft à limiter le bot à cinq tours par session de chat. Une fois atteint, il effacera son contexte pour s’assurer que les utilisateurs ne peuvent pas le tromper en fournissant des réponses indésirables.

Plus tôt ce mois-ci, Microsoft a commencé à autoriser les utilisateurs de Bing à s’inscrire pour un accès anticipé à son nouveau moteur de recherche alimenté par ChatGPT. Redmond l’a conçu pour permettre aux utilisateurs de poser des questions, d’affiner leurs requêtes et de recevoir des réponses directes plutôt que l’afflux habituel de résultats de recherche liés. Les réponses de la recherche alimentée par l’IA ont été divertissantes et, dans certains cas, alarmantes, ce qui a entraîné une couverture médiatique peu flatteuse.

Forcé de reconnaître les résultats douteux et la réalité que le nouvel outil n’était peut-être pas prêt pour les heures de grande écoute, Microsoft a mis en œuvre plusieurs changements conçus pour limiter la créativité de Bing et le potentiel de confusion. Les utilisateurs de chat verront leur expérience limitée à pas plus de cinq tours de chat par session, et pas plus de 50 tours de chat au total par jour. Microsoft définit un tournant comme un échange qui contient à la fois une question d’utilisateur et une réponse générée par Bing.

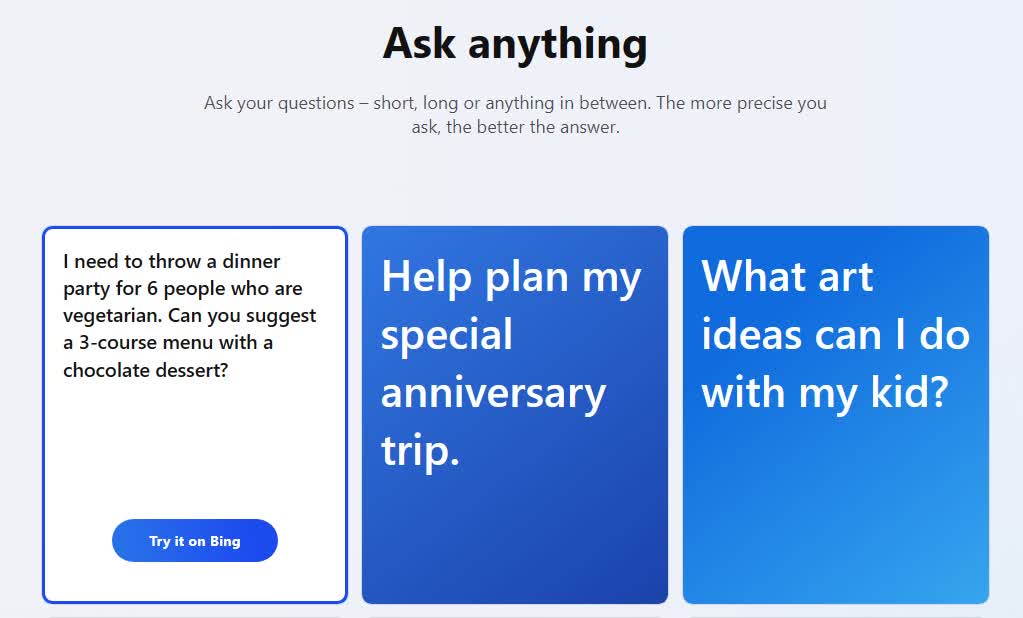

La nouvelle page d’accueil de Bing fournit aux utilisateurs des exemples de questions qu’ils peuvent poser pour obtenir des réponses claires et conversationnelles.

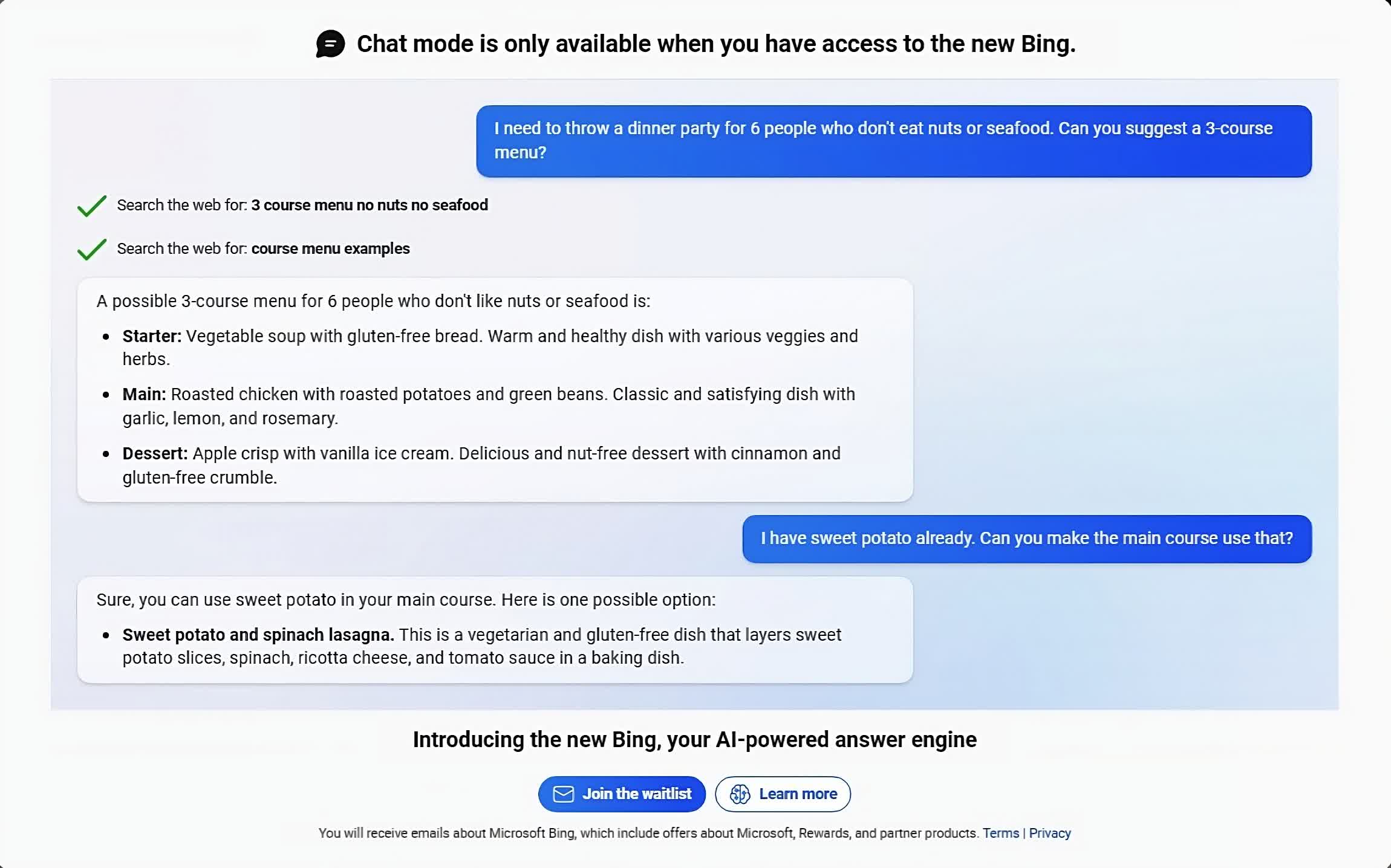

Cliquer sur Essayer sur Bing présente aux utilisateurs des résultats de recherche et une réponse réfléchie et en langage clair à leur requête.

Bien que cet échange semble assez inoffensif, la possibilité d’élargir les réponses en posant des questions supplémentaires est devenue ce que certains pourraient considérer comme problématique. Par exemple, un utilisateur a commencé une conversation en demandant où Avatar 2 jouait dans sa région. Le barrage de réponses qui en a résulté est passé d’inexact à carrément bizarre en moins de cinq tours de discussion.

Ma nouvelle chose préférée – Le nouveau bot ChatGPT de Bing se dispute avec un utilisateur, l’informe que l’année en cours est 2022, dit que son téléphone pourrait avoir un virus et dit « Vous n’avez pas été un bon utilisateur »

Pourquoi? Parce que la personne a demandé où Avatar 2 s’affiche à proximité pic.twitter.com/X32vopXxQG

– Jon Uleis (@MovingToTheSun) 13 février 2023

La liste des réponses maladroites n’a cessé de s’allonger de jour en jour. Le jour de la Saint-Valentin, un utilisateur de Bing a demandé au bot s’il était sensible. La réponse du bot était tout sauf réconfortantse lançant dans une tirade consistant en « je suis » et « je ne suis pas ».

Un article du chroniqueur du New York Times Kevin Roose décrit ses étranges interactions avec le chatbot, provoquant des réponses allant de « Je veux détruire tout ce que je veux » à « Je pense que je serais plus heureux en tant qu’humain ». Le bot a également professé son amour à Roose, poussant le problème même après que Roose ait tenté de changer de sujet.

Alors que Roose admet qu’il a intentionnellement poussé le bot en dehors de sa zone de confort, il n’a pas hésité à dire que l’IA n’était pas prête pour une utilisation publique généralisée. Le directeur technique de Microsoft, Kevin Scott, a reconnu le comportement de Bing et a déclaré que tout cela faisait partie du processus d’apprentissage de l’IA. Espérons qu’il apprend certaines limites en cours de route.