Une patate chaude : L’autorité indépendante du Royaume-Uni pour la protection de la vie privée ne souhaite pas que les entreprises ou les organisations utilisent des systèmes d’analyse des émotions basés sur des traits biométriques. C’est une technologie non testée et naissante qui pourrait même ne pas se matérialiser du tout.

L’Information Commissioner’s Office (ICO) du Royaume-Uni a récemment publié un Attention pour les entreprises et les organisations qui cherchent à déployer des technologies d’analyse des émotions basées sur l’IA. Ces systèmes ne semblent pas encore fonctionner et pourraient ne jamais fonctionner correctement. Le sous-commissaire Stephen Bonner a déclaré que les algorithmes d’apprentissage automatique qui identifient et distinguent les humeurs des gens sont « immatures ». Il a déclaré que les risques apportés par ce type de technologie sont supérieurs aux avantages possibles.

L’IA « émotionnelle » est une préoccupation pour l’ICO car il n’existe actuellement aucun système développé de manière à satisfaire aux exigences de protection des données, d’équité et de transparence. Bonner a suggéré que les seules technologies de reconnaissance biométrique durables sont celles qui sont « entièrement fonctionnelles, responsables et soutenues par la science », et les algorithmes d’analyse des émotions ne sont rien de tout cela.

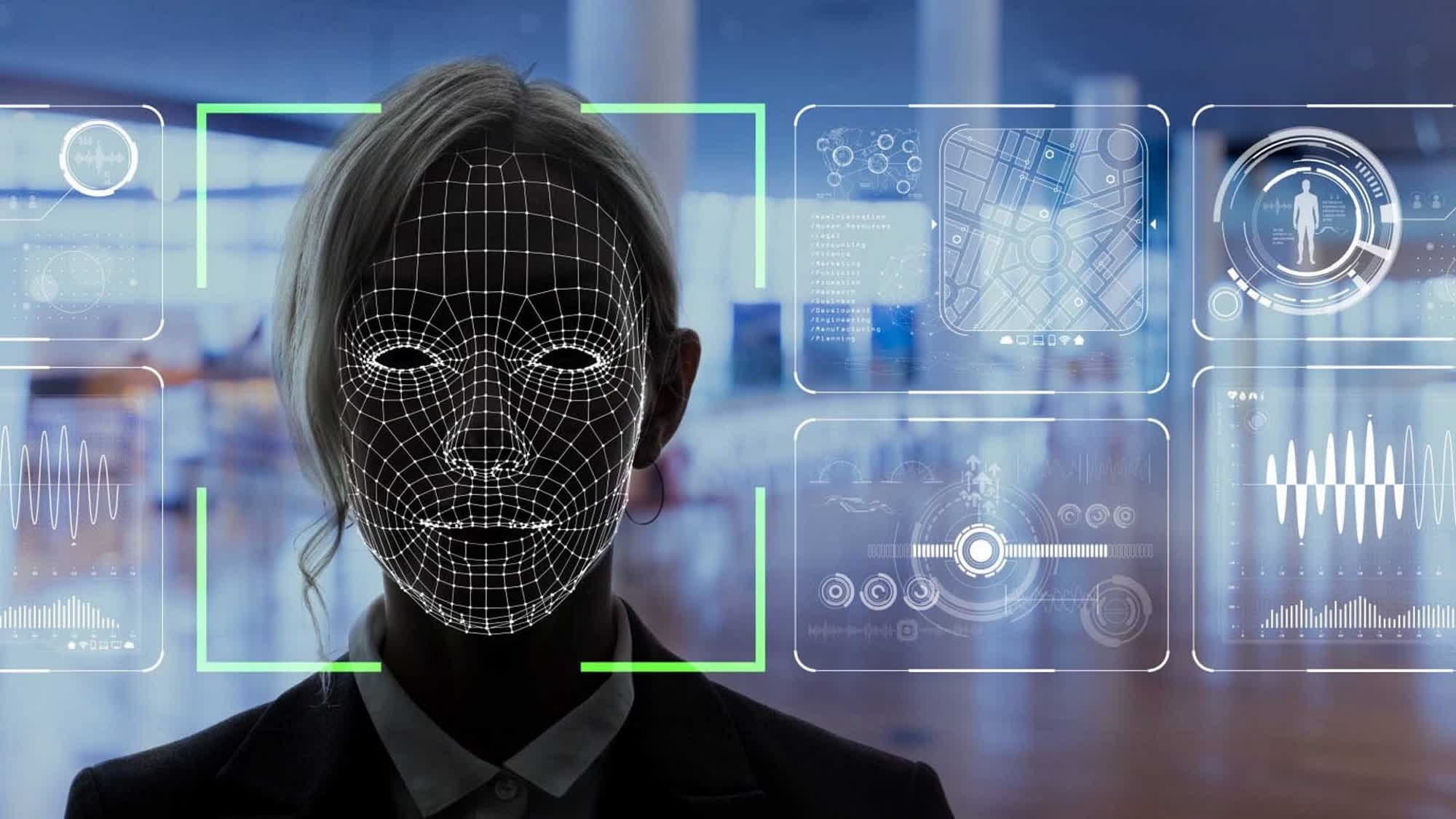

Les technologies d’analyse émotionnelle traitent des données telles que le suivi du regard, l’analyse des sentiments, les mouvements du visage, l’analyse de la démarche, les battements de cœur, les expressions faciales et l’humidité de la peau. Ces données offrent des capacités de surveillance de la santé physique des travailleurs, des étudiants pendant les examens, etc. L’ICO a averti qu’un système d’IA conçu pour identifier les humeurs pourrait montrer un biais systémique, une inexactitude et même une discrimination contre des traits particuliers et des traits du visage.

L’IA d’analyse des émotions est généralement associée à des systèmes biométriques complexes, car elle doit gérer une grande quantité d’informations personnelles en plus des images faciales elles-mêmes. Au-delà de l’utilité de l’algorithme, il existe une autre source d’inquiétude concernant la manière dont ces systèmes enregistrent et stockent les données. Les « réponses comportementales ou émotionnelles subconscientes » sont plus risquées que les technologies biométriques traditionnelles.

Étant donné que les responsables ne peuvent pas encore faire confiance aux technologies d’analyse des émotions, l’ICO a averti que les organisations qui l’utilisent « [pose] risques pour les personnes vulnérables » et feront l’objet d’une enquête. Le bureau conseille aux entreprises d’attendre au moins un an de plus pour déployer des IA émotionnelles commerciales.

Dans l’intervalle, l’organisme de surveillance de la confidentialité travaille sur une «orientation biométrique» complète concernant la manière dont les données biométriques, y compris les traits du visage, les empreintes digitales et les échantillons de voix, doivent être traitées de manière appropriée et non discriminatoire. L’ICO prévoit de publier des lignes directrices d’ici le printemps 2023.