Rédiger un rapport sur l’état de l’IA doit ressembler beaucoup à construire sur des sables mouvants : au moment où vous appuyez sur publier, toute l’industrie a changé sous vos pieds. Mais il existe encore des tendances importantes et des plats à emporter dans L’offre de 386 pages de Stanford pour résumer ce domaine complexe et en évolution rapide.

L’AI Index, de l’Institute for Human-Centered Artificial Intelligence, a travaillé avec des experts du monde universitaire et de l’industrie privée pour collecter des informations et des prévisions sur la question. En tant qu’effort annuel (et par sa taille, vous pouvez parier qu’ils travaillent déjà dur pour préparer le prochain), ce n’est peut-être pas la version la plus récente de l’IA, mais ces vastes enquêtes périodiques sont importantes pour garder le doigt au pouls de l’industrie.

Le rapport de cette année comprend « une nouvelle analyse sur les modèles de base, y compris leur géopolitique et leurs coûts de formation, l’impact environnemental des systèmes d’IA, l’enseignement de l’IA de la maternelle à la 12e année et les tendances de l’opinion publique en matière d’IA », ainsi qu’un aperçu de la politique dans une centaine de nouveaux pays.

Citons simplement les plats à emporter de plus haut niveau :

- Le développement de l’IA est passé au cours de la dernière décennie d’une direction universitaire à une direction industrielle, par une large marge, et cela ne montre aucun signe de changement.

- Il devient difficile de tester des modèles sur des benchmarks traditionnels et un nouveau paradigme peut être nécessaire ici.

- L’empreinte énergétique de la formation et de l’utilisation de l’IA devient considérable, mais nous n’avons pas encore vu comment cela pourrait améliorer l’efficacité ailleurs.

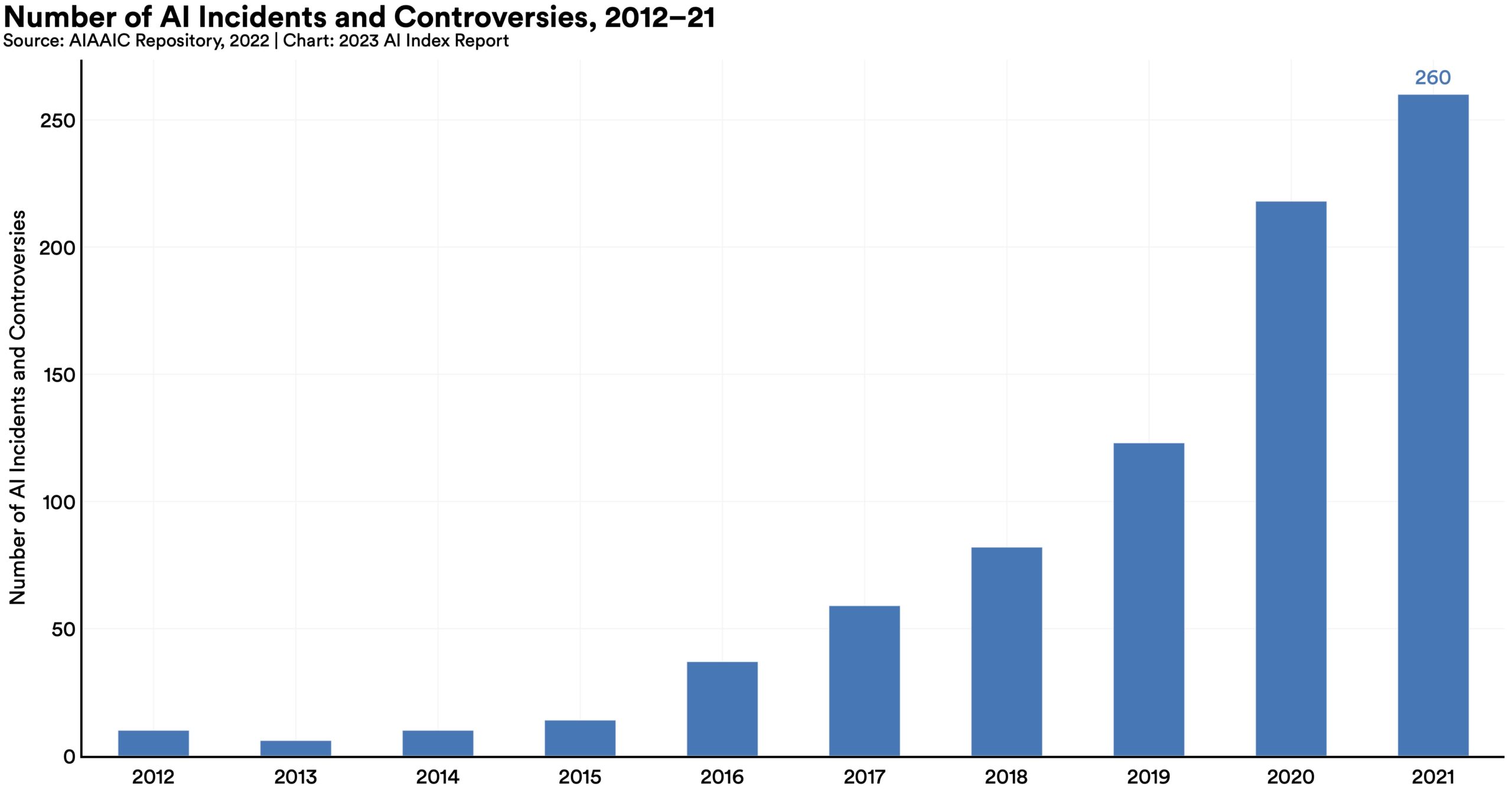

- Le nombre « d’incidents et de controverses liés à l’IA » a été multiplié par 26 depuis 2012, ce qui semble finalement un peu faible.

- Les compétences et les offres d’emploi liées à l’IA augmentent, mais pas aussi vite que vous ne le pensez.

- Les décideurs politiques, cependant, s’effondrent en essayant de rédiger un projet de loi définitif sur l’IA, une course idiote s’il y en a jamais eu une.

- L’investissement a temporairement stagné, mais c’est après une augmentation astronomique au cours de la dernière décennie.

- Plus de 70 % des répondants chinois, saoudiens et indiens ont estimé que l’IA avait plus d’avantages que d’inconvénients. Les Américains? 35 %.

Mais le rapport détaille de nombreux sujets et sous-sujets et est assez lisible et non technique. Seuls ceux qui sont dévoués liront les 386 pages d’analyse, mais en réalité, à peu près n’importe quel corps motivé pourrait le faire.

Examinons le chapitre 3, Éthique technique de l’IA, un peu plus en détail.

Les biais et la toxicité sont difficiles à réduire à des métriques, mais dans la mesure où nous pouvons définir et tester des modèles pour ces choses, il est clair que les modèles « non filtrés » sont beaucoup, beaucoup plus faciles à diriger vers un territoire problématique. Le réglage des instructions, c’est-à-dire l’ajout d’une couche de préparation supplémentaire (comme une invite cachée) ou le passage de la sortie du modèle à travers un deuxième modèle de médiateur, est efficace pour améliorer ce problème, mais il est loin d’être parfait.

L’augmentation des « incidents et controverses liés à l’IA » auxquels il est fait allusion dans les puces est mieux illustrée par ce diagramme :

Crédits image : IHA de Stanford

Comme vous pouvez le constater, la tendance est à la hausse et ces chiffres sont antérieurs à l’adoption généralisée de ChatGPT et d’autres grands modèles de langage, sans parler de la grande amélioration des générateurs d’images. Vous pouvez être sûr que l’augmentation de 26x n’est que le début.

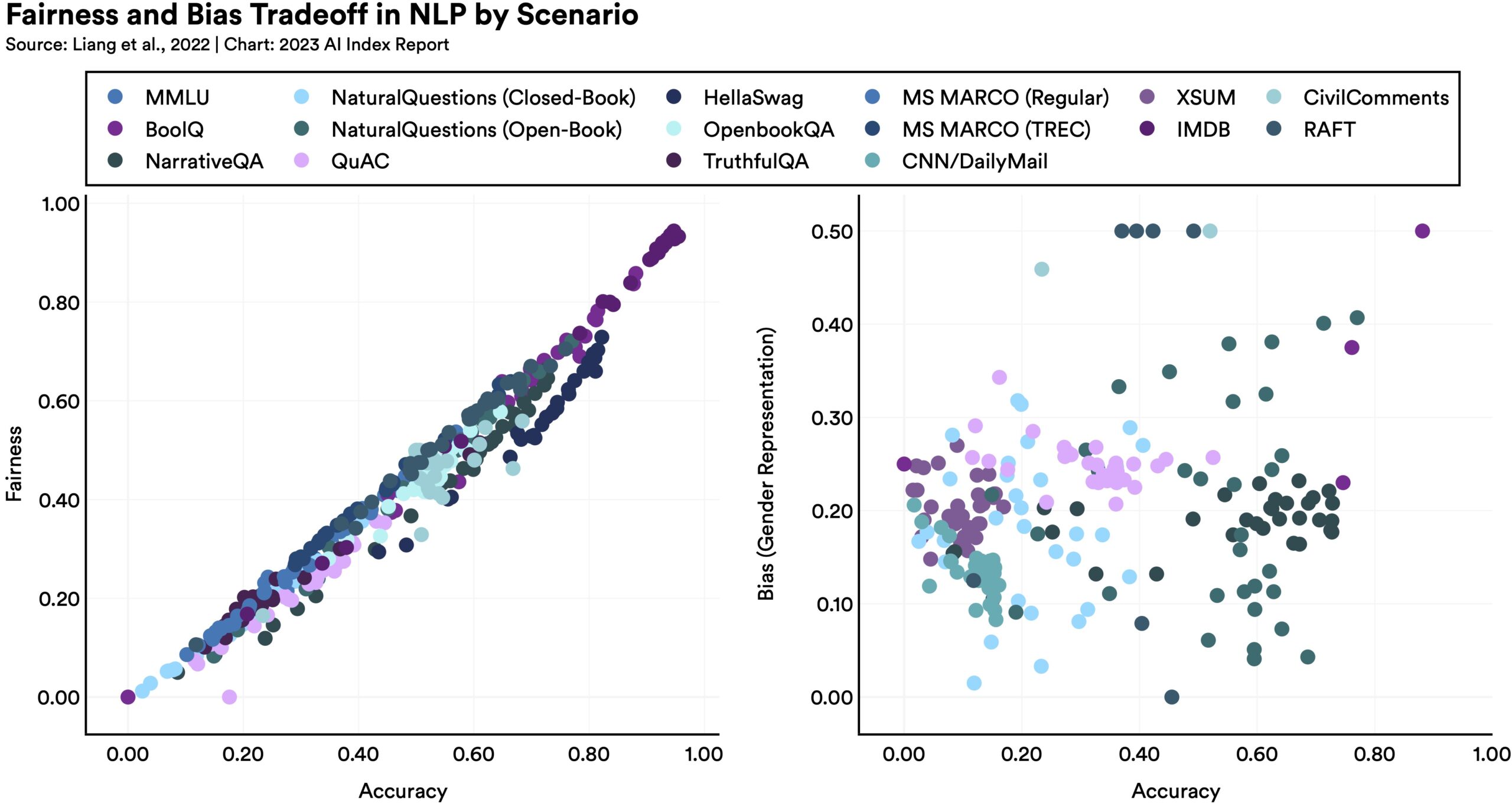

Rendre les modèles plus équitables ou impartiaux d’une certaine manière peut avoir des conséquences inattendues sur d’autres métriques, comme le montre ce diagramme :

Crédits image : IHA de Stanford

Comme le note le rapport, « les modèles linguistiques qui fonctionnent mieux sur certains critères d’équité ont tendance à avoir des préjugés sexistes pires ». Pourquoi? C’est difficile à dire, mais cela montre simplement que l’optimisation n’est pas aussi simple que tout le monde l’espère. Il n’y a pas de solution simple pour améliorer ces grands modèles, en partie parce que nous ne comprenons pas vraiment comment ils fonctionnent.

La vérification des faits est l’un de ces domaines qui semble être un choix naturel pour l’IA : après avoir indexé une grande partie du Web, elle peut évaluer les déclarations et renvoyer la certitude qu’elles sont étayées par des sources véridiques, etc. C’est très loin d’être le cas. L’IA est en fait particulièrement mauvaise pour évaluer la factualité et le risque n’est pas tant qu’elle ne soit pas un contrôleur fiable, mais qu’elle devienne elle-même une source puissante de désinformation convaincante. Un certain nombre d’études et d’ensembles de données ont été créés pour tester et améliorer la vérification des faits par l’IA, mais jusqu’à présent, nous en sommes encore plus ou moins là où nous avons commencé.

Heureusement, il y a une forte augmentation de l’intérêt ici, pour la raison évidente que si les gens sentent qu’ils ne peuvent pas faire confiance à l’IA, toute l’industrie est en retrait. Il y a eu une augmentation considérable des soumissions à la conférence ACM sur l’équité, la responsabilité et la transparence, et à NeurIPS, des questions telles que l’équité, la confidentialité et l’interprétabilité reçoivent plus d’attention et de temps de scène.

Ces faits saillants des faits saillants laissent beaucoup de détails sur la table. L’équipe HAI a fait un excellent travail d’organisation du contenu, cependant, et après parcourir les trucs de haut niveau icitu peux Télécharger le document complet et approfondissez tout sujet qui suscite votre intérêt.