Pisteune startup IA qui a contribué au développement du générateur d’images IA Stable Diffusion, a lancé son premier apple.com/app/apple-store/id1665024375″ target= »_blank » rel= »noopener »>application mobile hier pour donner aux utilisateurs l’accès à Gen-1, son modèle d’IA générative vidéo à vidéo. L’application n’est actuellement disponible que sur les appareils iOS.

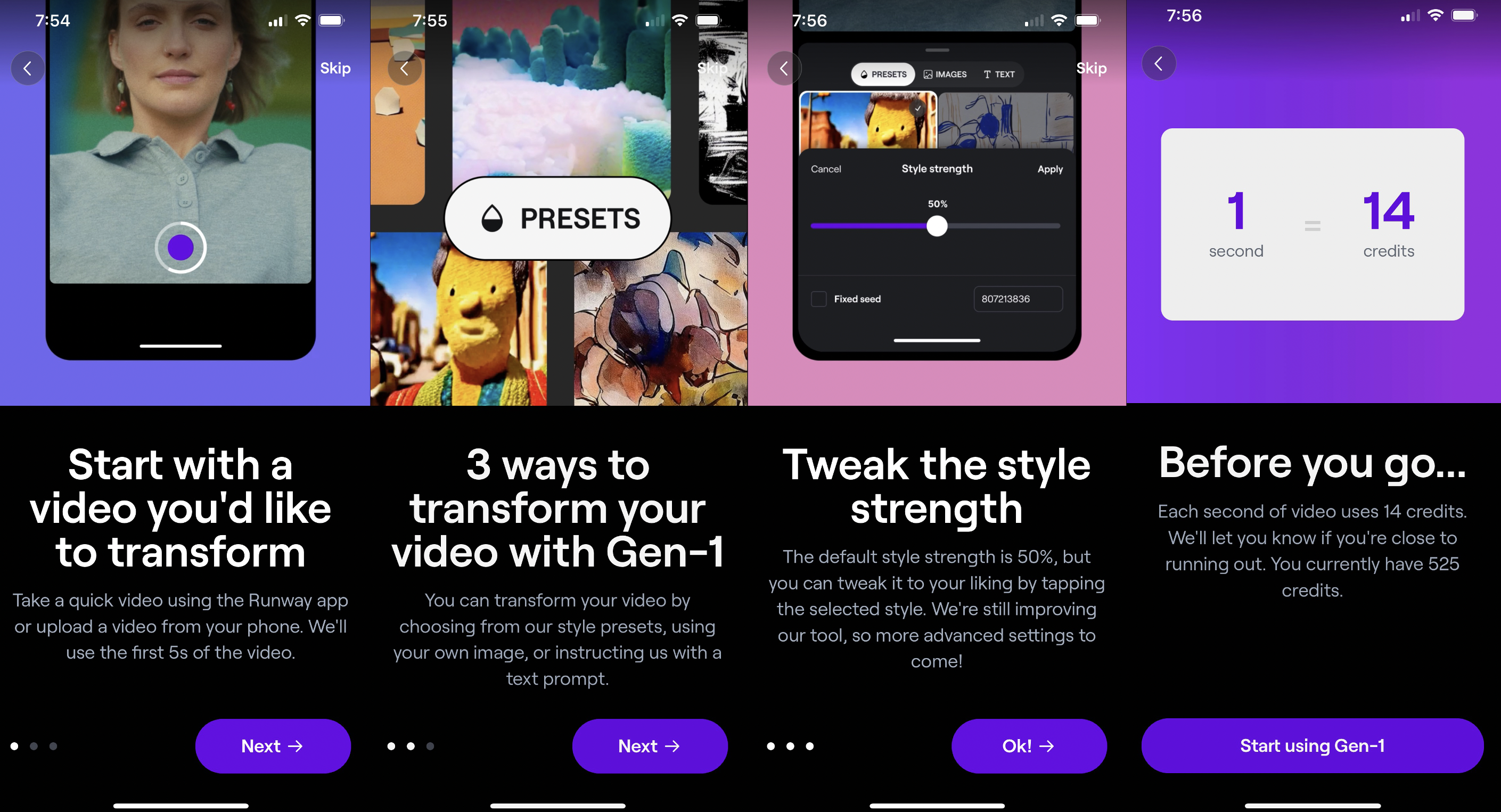

Avec la nouvelle application, les utilisateurs pourront enregistrer une vidéo à partir de leur téléphone et générer une vidéo AI en quelques minutes. Ils peuvent également transformer n’importe quelle vidéo existante dans leur bibliothèque en utilisant des invites de texte, des images ou des préréglages de style.

Les utilisateurs peuvent choisir parmi la liste de préréglages de Runway comme « Cloudscape » ou transformer leur vidéo pour qu’elle ressemble à une argile, un croquis au fusain, une aquarelle, un origami en papier et plus encore. Ils peuvent également Télécharger une image ou saisir une idée dans la zone de texte.

L’application générera ensuite quatre aperçus parmi lesquels les utilisateurs pourront choisir. Une fois qu’ils ont sélectionné celui qu’ils aiment le plus, il faudra quelques minutes pour produire le produit final. Nous avons testé l’application nous-mêmes et avons constaté que cela prenait environ 60 secondes ou plus. Parfois, il a fallu deux minutes pour générer.

Naturellement, comme avec tout générateur d’IA, les résultats ne sont pas parfaits et semblent souvent déformés ou bizarres. En général, le concept de générateurs vidéo AI peut sembler idiot et peut-être même fantaisiste. Mais à mesure que la technologie évolue et s’améliore au fil du temps, elle pourrait être précieuse pour les utilisateurs. Par exemple, les créateurs de contenu peuvent pimenter leurs publications sur les réseaux sociaux.

Quoi qu’il en soit, nous avons constaté que l’application mobile de Runway était facile à utiliser et amusante dans l’ensemble.

Vous trouverez ci-dessous un exemple que nous avons trouvé, en utilisant youtube.com/watch?v=CQ_eDE0OMds » target= »_blank » rel= »noopener »>un clip de Michael Scott de « The Office ». Une invite de texte que nous avons entrée était « marionnette réaliste ».

(Attention : le résultat est terrifiant.)

Crédits image : Runway (tiré du clip Office)

Nous avons également essayé « l’animation 3D », qui s’est avérée correcte.

Crédits image : Runway (tiré du clip Office)

Certes, il y a quelques autres mises en garde en plus des problèmes et des visages déformés.

Si les utilisateurs veulent la version gratuite, il y a une limite de 525 crédits et ils ne peuvent télécharger que des vidéos de cinq secondes. Chaque seconde d’une vidéo utilise 14 crédits.

À l’avenir, Runway prévoit d’ajouter la prise en charge de vidéos plus longues, a déclaré le co-fondateur et PDG Cristóbal Valenzuela à fr.techtribune.net. L’application continuera à s’améliorer et à lancer de nouvelles fonctionnalités, a-t-il ajouté.

« Nous nous concentrons sur l’amélioration de l’efficacité, de la qualité et du contrôle. Dans les semaines et les mois à venir, vous verrez toutes sortes de mises à jour, des sorties plus longues aux vidéos de meilleure qualité », a déclaré Valenzuela.

Notez également que l’application ne génère pas de nudité ou d’œuvres protégées par le droit d’auteur, vous ne pouvez donc pas créer de vidéos qui imitent le style de l’IP populaire.

La nouvelle application mobile de Runway propose deux forfaits premium : Standard (143,99 $/an) et Pro (344,99 $/an). Le plan standard vous offre 625 crédits/mois et d’autres fonctionnalités premium comme la vidéo 1080p, des projets illimités et plus encore. Le plan Pro offre 2 250 crédits/mois et tous les 30+ outils d’IA de Runway.

Crédits image : Piste

Un mois après la sortie de Runway Gen-1 – qui a été lancé en février – Runway a déployé son Gen-2 modèle. Sans doute une avancée par rapport aux modèles texte-image Stable Diffusion et DALL-E, Gen-2 est un générateur de texte-vidéo, de sorte que les utilisateurs pourront générer des vidéos à partir de zéro.

Runway a lentement commencé à déployer l’accès à sa version bêta fermée pour Gen-2, nous a dit Valenzuela.

L’application prend actuellement en charge le modèle Gen-1, mais Gen-2 sera bientôt disponible avec les autres outils d’IA de Runway, tels que son générateur d’image à image.

Meta et google ont tous deux lancé des générateurs de texte en vidéo, appelés respectivement Make-A-Video et Imagen.

Runway a développé divers logiciels de montage vidéo alimentés par l’IA depuis son lancement en 2018. La société dispose d’une variété d’outils différents au sein de son éditeur vidéo basé sur le webtelles que l’interpolation d’image, la suppression de l’arrière-plan, les effets de flou, une fonctionnalité qui nettoie ou supprime le suivi audio et de mouvement, parmi bien d’autres.

Les outils ont aidé les influenceurs et même les studios de cinéma/TV à réduire le temps passé à éditer et à créer des vidéos.

Par exemple, le équipe d’effets visuels derrière « Everything Everywhere All at Once » a utilisé la technologie de Runway pour aider à créer la scène du film où Evelyn (Michelle Yeoh) et Joy (Stephanie Hsu) sont dans un multivers où elles ont été transformées en roches mouvantes.

De plus, l’équipe graphique derrière « The Late Show with Stephen Colbert » de CBS a utilisé Runway pour réduire les heures de montage à seulement cinq minutes, selon le directeur artistique Andro Buneta.

Runway exploite également Runway Studios, sa division de divertissement et de production.