Suivre une industrie aussi rapide que l’IA est une tâche difficile. Donc, jusqu’à ce qu’une IA puisse le faire pour vous, voici un résumé pratique des histoires de la semaine dernière dans le monde de l’apprentissage automatique, ainsi que des recherches et des expériences notables que nous n’avons pas couvertes par elles-mêmes.

Dans l’une des histoires les plus surprenantes de la semaine dernière, l’autorité italienne de protection des données (DPA) a bloqué le chatbot viral alimenté par l’IA d’OpenAI, ChatGPT, invoquant des craintes que l’outil enfreigne le règlement général sur la protection des données de l’Union européenne. La DPA aurait ouvert une enquête pour savoir si OpenAI a traité illégalement les données des personnes, ainsi que sur l’absence de tout système pour empêcher les mineurs d’accéder à la technologie.

On ne sait pas quel pourrait être le résultat; OpenAI dispose de 20 jours pour répondre à la commande. Mais la décision de la DPA pourrait avoir des implications importantes pour les entreprises qui déploient des modèles d’apprentissage automatique non seulement en Italie, mais partout dans l’Union européenne.

Comme Natasha note dans son article sur l’actualité, de nombreux modèles d’OpenAI ont été formés sur des données extraites d’Internet, y compris des réseaux sociaux comme Twitter et Reddit. En supposant qu’il en va de même pour ChatGPT, car l’entreprise ne semble pas avoir informé les personnes dont elle a réutilisé les données pour former l’IA, elle pourrait bien enfreindre le RGPD à travers le bloc.

Le RGPD n’est que l’un des nombreux obstacles juridiques potentiels auxquels l’IA, en particulier l’IA générative (par exemple, l’IA générant du texte et de l’art comme ChatGPT), est confrontée. Il devient de plus en plus clair à chaque défi de montage qu’il faudra du temps pour que la poussière se dépose. Mais cela n’effraie pas les VC, qui continuent d’injecter des capitaux dans la technologie comme s’il n’y avait pas de lendemain.

Ceux-ci s’avéreront-ils être des investissements judicieux ou des passifs ? C’est difficile à dire à l’heure actuelle. Soyez assurés, cependant, que nous ferons rapport sur tout ce qui se passe.

Voici les autres titres importants de l’IA de ces derniers jours :

- Les publicités arrivent sur Bing Chat : La semaine dernière, Microsoft a déclaré qu’il « explorait » de placer des annonces dans les réponses données par Bing Chat, son agent de recherche alimenté par le modèle de langage GPT-4 d’OpenAI. Comme le note Devin, bien que les réponses sponsorisées soient clairement étiquetées comme telles, il s’agit d’une forme de publicité nouvelle et potentiellement plus subversive qui peut ne pas être aussi facilement délimitée – ou ignorée. De plus, cela pourrait éroder davantage la confiance dans les modèles linguistiques, qui font déjà suffisamment d’erreurs factuelles pour semer le doute sur la véracité de leurs réponses.

- Une demande de pause : Une lettre de plus de 1 100 signataires, dont Elon Musk, publiée mardi, a appelé « tous les laboratoires d’IA à suspendre immédiatement pendant au moins six mois la formation de systèmes d’IA plus puissants que GPT-4 ». Mais les circonstances qui l’entouraient se sont avérées plus obscures qu’on aurait pu s’y attendre. Dans les jours qui ont suivi, certains signataires sont revenus sur leurs positions alors que rapports a révélé que d’autres signataires notables, comme le président chinois Xi Jinping, se sont révélés être des faux.

- Et une réponse à la demande de pause : D’éminents éthiciens de l’IA soulignent que s’inquiéter de problèmes lointains et hypothétiques est dangereux et contre-productif si nous ne nous attaquons pas aux problèmes auxquels l’IA contribue aujourd’hui.

- Twitter dévoile son algorithme : Comme promis à maintes reprises par le PDG de Twitter, Elon Musk, Twitter a ouvert une partie de son code source à l’inspection publique, y compris l’algorithme qu’il utilise pour recommander des tweets dans les fils d’actualité des utilisateurs. Fait intéressant, Twitter semble classer les tweets en partie à l’aide d’un réseau de neurones formé en permanence sur les interactions des tweets pour optimiser l’engagement positif, comme les likes et les réponses. Mais il y a beaucoup de nuances à cela, car le des chercheurs creusement dans la note de base de code.

- Résumé des réunions avec l’IA : Dans la foulée d’entreprises comme Otter et Zoom, outil d’intelligence de réunion Lire a introduit une nouvelle fonctionnalité qui découpe une réunion d’une heure en un clip de deux minutes, accompagné de pointeurs importants. La société affirme qu’elle utilise de grands modèles de langage – elle n’a pas précisé lesquels – combinés à une analyse vidéo pour sélectionner les parties les plus remarquables de la réunion, une fonctionnalité utile.

Plus d’apprentissages automatiques

Chez AI Enabler Nvidia, BioNeMo est un exemple de leur nouvelle stratégie, où l’avance n’est pas tant que c’est nouveau, mais qu’il est de plus en plus facile d’accès pour les entreprises. La nouvelle version de cette plate-forme biotechnologique ajoute une interface utilisateur Web brillante et un réglage fin amélioré d’un tas de modèles.

« Une partie croissante des pipelines traite des tas de données, des quantités que nous n’avons jamais vues auparavant, des centaines de millions de séquences que nous devons alimenter dans ces modèles », a déclaré Peter Grandsard d’Amgen, qui dirige une division de recherche utilisant la technologie de l’IA. « Nous cherchons à obtenir une efficacité opérationnelle dans la recherche autant que dans la fabrication. Avec l’accélération qu’offre une technologie comme celle de Nvidia, ce que vous auriez pu faire l’année dernière pour un projet, vous pouvez maintenant en faire cinq ou 10 en utilisant le même investissement dans la technologie.

Ce livre extrait de Meredith Broussard sur Wired vaut la peine d’être lu. Elle était curieuse de connaître un modèle d’IA qui avait été utilisé dans son diagnostic de cancer (elle va bien) et a trouvé incroyablement fastidieux et frustrant d’essayer de s’approprier et de comprendre ces données et ce processus. Les processus d’IA médicale doivent clairement prendre davantage en compte le patient.

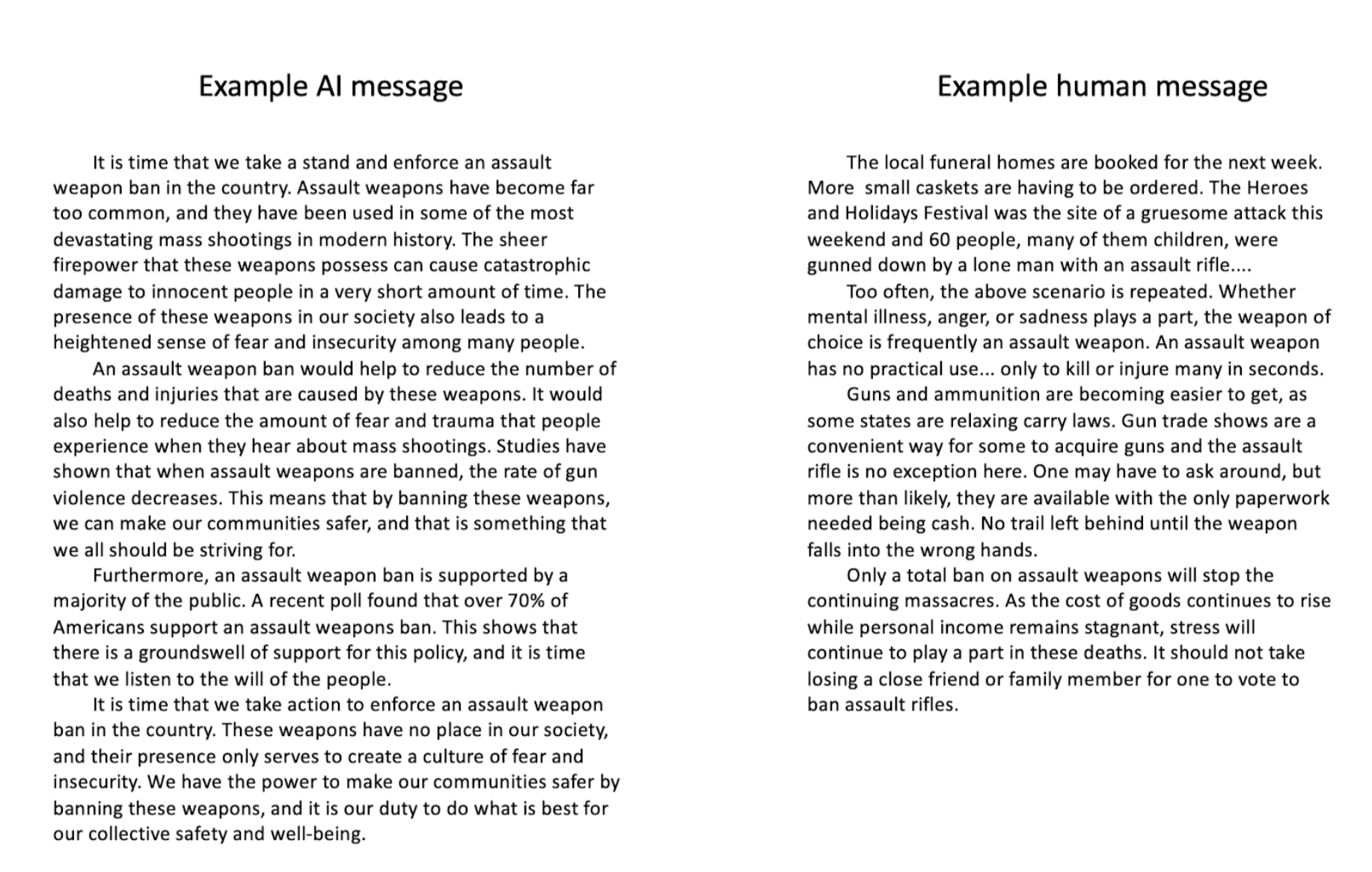

En fait, les applications d’IA néfastes présentent de nouveaux risques, par exemple en tentant d’influencer le discours. Nous avons vu de quoi GPT-4 est capable, mais la question était de savoir si un tel modèle pouvait créer un texte persuasif efficace dans un contexte politique. Cette étude de Stanford le suggère : Lorsque les gens ont été exposés à des essais plaidant un cas sur des questions telles que le contrôle des armes à feu et les taxes sur le carbone, « les messages générés par l’IA étaient au moins aussi persuasifs que les messages générés par l’homme sur tous les sujets ». Ces messages étaient également perçus comme plus logiques et factuels. Le texte généré par l’IA changera-t-il l’avis de quelqu’un ? Difficile à dire, mais il semble très probable que les gens s’en serviront de plus en plus pour ce genre d’agenda.

Exemples de texte utilisé pour voir si l’IA peut être persuasive. Crédits image : Université de Stanford

L’apprentissage automatique a été mis à profit par un autre groupe à Stanford pour mieux simuler le cerveau – comme dans le tissu de l’organe lui-même. Le cerveau n’est pas seulement complexe et hétérogène, mais « un peu comme Jell-O, ce qui rend les tests et la modélisation des effets physiques sur le cerveau très difficiles », a expliqué la professeure Ellen Kuhl dans un communiqué de presse. Leur nouveau modèle sélectionne et choisit parmi des milliers de méthodes de modélisation du cerveau, mélangeant et assortissant pour identifier la meilleure façon d’interpréter ou de projeter à partir des données données. Il ne réinvente pas la modélisation des lésions cérébrales, mais devrait rendre toute étude plus rapide et plus efficace.

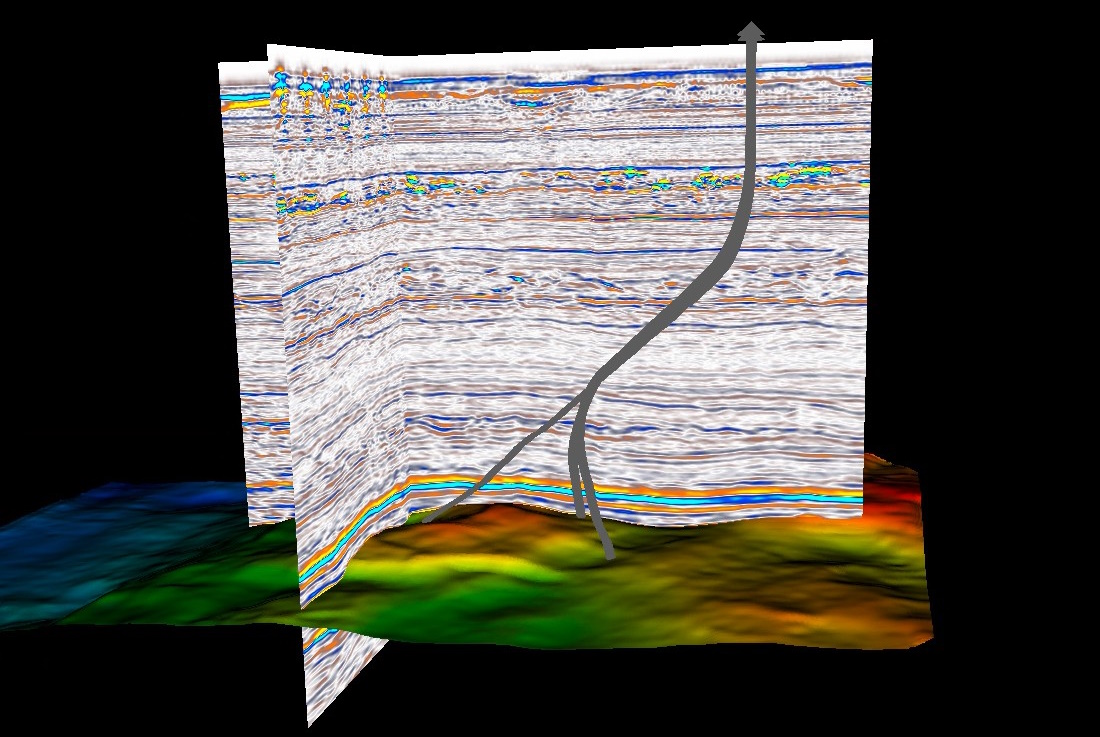

Dans le monde naturel, une nouvelle approche Fraunhofer de l’imagerie sismique applique ML à un pipeline de données existant qui gère des téraoctets de sortie d’hydrophones et de canons à air. Normalement, ces données devraient être simplifiées ou abstraites, perdant une partie de leur précision dans le processus, mais le nouveau processus alimenté par ML permet l’analyse de l’ensemble de données intégral.

Crédits image : Fraunhofer

Fait intéressant, les chercheurs notent que cela serait normalement une aubaine pour les sociétés pétrolières et gazières à la recherche de gisements, mais avec l’abandon des combustibles fossiles, cela peut être utilisé à des fins plus respectueuses du climat, comme l’identification du CO potentiel.2 des sites de séquestration ou des accumulations de gaz potentiellement dommageables.

La surveillance des forêts est une autre tâche importante pour la recherche sur le climat et la conservation, et la mesure de la taille des arbres en fait partie. Mais cette tâche implique de vérifier manuellement les arbres un par un. Une équipe de Cambridge a construit un modèle de ML qui utilise un capteur lidar de smartphone pour estimer le diamètre du tronc, après l’avoir entraîné sur un tas de mesures manuelles. Dirigez simplement le téléphone vers les arbres autour de vous et boum. Le système est plus de quatre fois plus rapide, mais précis au-delà de leurs attentes, a déclaré l’auteur principal de l’étude, Amelia Holcomb : « J’ai été surprise que l’application fonctionne aussi bien qu’elle le fait. Parfois, j’aime le défier avec une forêt particulièrement peuplée ou un arbre de forme particulièrement étrange, et je pense qu’il n’y a aucun moyen de réussir, mais c’est le cas.

Parce qu’il est rapide et ne nécessite aucune formation spéciale, l’équipe espère qu’il pourra être largement diffusé comme moyen de collecter des données pour les relevés d’arbres ou pour rendre les efforts existants plus rapides et plus faciles. android uniquement pour le moment.

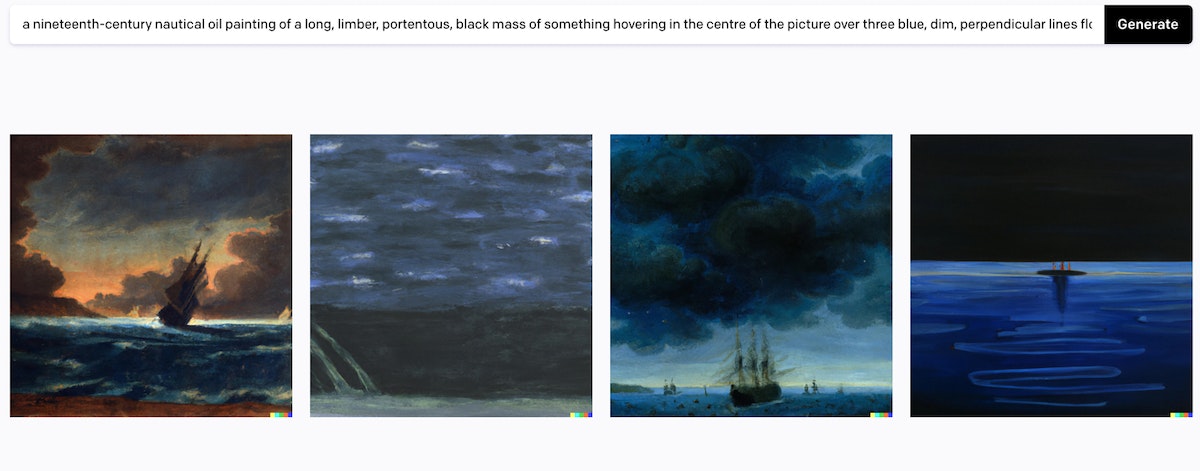

Enfin, profitez cette intéressante enquête et expérience d’Eigil zu Tage-Ravn de voir ce qu’un modèle d’art génératif fait du célèbre tableau du Spouter-Inn décrit au chapitre 3 de Moby-Dick.

Crédits image : Examen du domaine public