Plateforme développeur GitLab aujourd’hui annoncé une nouvelle fonctionnalité de sécurité basée sur l’IA qui utilise un grand modèle de langage pour expliquer les vulnérabilités potentielles aux développeurs, avec des plans pour l’étendre pour résoudre automatiquement ces vulnérabilités à l’aide de l’IA à l’avenir.

Plus tôt ce mois-ci, la société a annoncé un nouvel outil expérimental qui explique le code à un développeur – similaire à la nouvelle fonctionnalité de sécurité annoncée par GitLab – et une nouvelle fonctionnalité expérimentale qui automatiquement résume les commentaires sur les problèmes. Dans ce contexte, il convient également de noter que GitLab a déjà lancé un outil de complétion de code, qui est maintenant disponible aux utilisateurs de GitLab Ultimate et Premium, et son ML basé sur examinateurs suggérés caractéristique l’année dernière.

Crédits image : GitLab

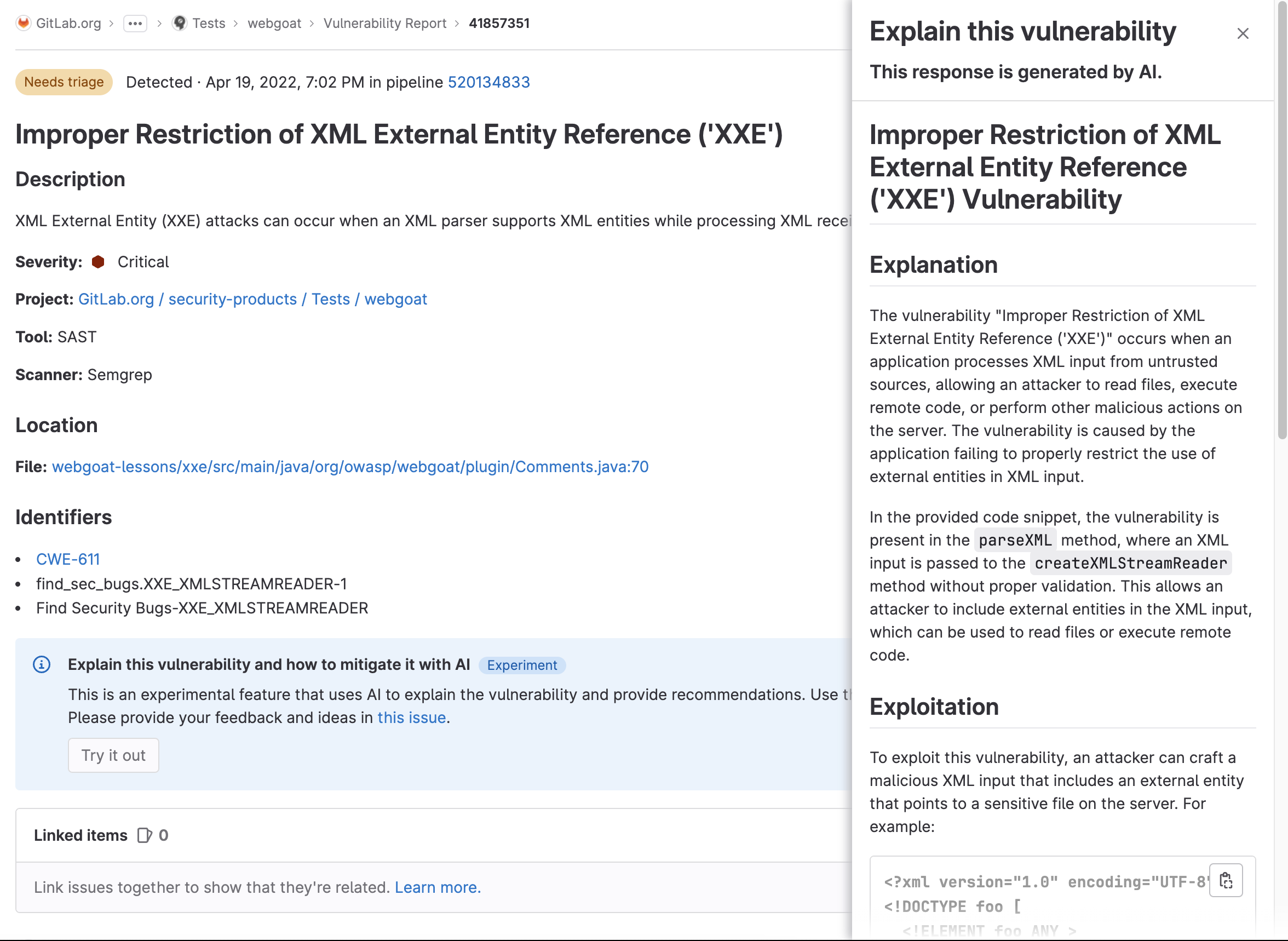

La nouvelle fonctionnalité « expliquer cette vulnérabilité » tentera d’aider les équipes à trouver le meilleur moyen de corriger une vulnérabilité dans le contexte de la base de code. C’est ce contexte qui fait la différence ici, car l’outil est capable de combiner les informations de base sur la vulnérabilité avec des informations spécifiques du code de l’utilisateur. Cela devrait faciliter et accélérer la résolution de ces problèmes.

L’entreprise appelle sa philosophie globale derrière l’ajout de fonctionnalités d’IA « vitesse avec garde-corps », c’est-à-dire la combinaison du code d’IA et de la génération de tests soutenus par la plate-forme DevSecOps complète de l’entreprise pour garantir que tout ce que l’IA génère peut être déployé en toute sécurité.

GitLab a également souligné que toutes ses fonctionnalités d’IA sont conçues dans un souci de confidentialité. « Si nous sont émouvant ynotre intellectuel propriété, qui est codewe sont seul en allant pour être Envoi en cours ce pour un modèle ce est GitLabs ou est au sein du GitLab nuage architecture », m’a dit le CPO de GitLab, David DeSanto. « Til raison pour laquelle c’est important pour nous – et cela remonte à entreprise DevSecOps – est-ce notre clients sont fortement réglementé. Notre clients sont généralement très sécurité et conformité conscient, et nous connaissait nous pourrait pas construire un code suggestions solution ce requis nous Envoi en cours il pour un troisième-faire la fête IA. » Il a également noté que GitLab n’utilisera pas les données privées de ses clients pour former ses modèles.

DeSanto a souligné que l’objectif global de GitLab pour son initiative d’IA est de multiplier par 10 l’efficacité – et pas seulement l’efficacité du développeur individuel, mais le cycle de développement global. Comme il l’a noté à juste titre, même si vous pouviez multiplier par 100 la productivité d’un développeur, des inefficacités plus en aval dans l’examen de ce code et sa mise en production pourraient facilement annuler cela.

« Si développement est 20% de le vie cycle, même si nous faire ce 50% plus efficace, vous êtes pas vraiment en allant pour se sentir ça », a déclaré DeSanto. « Maintenant, si nous faire le sécurité équipes, le opérations équipes, le équipes de conformité aussi plus efficace, alors comme un organisation, tu es en allant pour voir il. »

La fonctionnalité « expliquer ce code », par exemple, s’est avérée très utile non seulement pour les développeurs, mais également pour les équipes d’assurance qualité et de sécurité, qui comprennent désormais mieux ce qu’elles doivent tester. C’est sûrement aussi la raison pour laquelle GitLab l’a étendu pour expliquer également les vulnérabilités. À long terme, l’idée ici est de créer des fonctionnalités pour aider ces équipes à générer automatiquement des tests unitaires et des revues de sécurité – qui seraient ensuite intégrés à la plate-forme globale GitLab.

Selon le récent GitLab Rapport DevSecOps, 65 % des développeurs utilisent déjà l’IA et le ML dans leurs efforts de test ou prévoient de le faire dans les trois prochaines années. Déjà, 36 % des équipes utilisent un outil d’IA/ML pour vérifier leur code avant même que les réviseurs de code ne le voient.

« Compte tenu des contraintes de ressources auxquelles les équipes DevSecOps sont confrontées, l’automatisation et l’intelligence artificielle deviennent une ressource stratégique », écrit Dave Steer de GitLab dans l’annonce d’aujourd’hui. « Notre plate-forme DevSecOps aide les équipes à combler les lacunes critiques tout en appliquant automatiquement des politiques, en appliquant des cadres de conformité, en effectuant des tests de sécurité à l’aide des capacités d’automatisation de GitLab et en fournissant des recommandations assistées par l’IA, ce qui libère des ressources. »