Qu’est-ce qui vient de se passer? C’est un cas d’un autre jour, un autre avertissement sur la possibilité que l’IA provoque l’extinction de la race humaine. À cette occasion, il a été comparé aux risques posés par la guerre nucléaire et les pandémies. La déclaration provient d’experts dans le domaine et de ceux qui sont à l’origine de ces systèmes, dont le PDG d’OpenAI, Sam Altman.

L’IA au titre inquiétant Déclaration d’extinction du Center for AI Safety (CAIS) est signé par les PDG des meilleurs laboratoires d’IA : Altman, Demis Hassabis de Google DeepMind et Dario Amodei d’Anthropic. Parmi les autres signataires figurent des auteurs de manuels d’apprentissage en profondeur et d’IA, des lauréats du prix Turing tels que Geoffrey Hinton (qui a quitté Google à cause de ses craintes en matière d’IA), des dirigeants d’entreprises de haute technologie, des scientifiques, des professeurs, etc.

La déclaration ne se résume qu’à une seule phrase : « Atténuer le risque d’extinction de l’IA devrait être une priorité mondiale aux côtés d’autres risques à l’échelle de la société tels que les pandémies et la guerre nucléaire ».

Certains des risques liés à l’IA listé par le PCSRA comprennent la perpétuation des préjugés, l’alimentation d’armes autonomes, la promotion de la désinformation et la conduite de cyberattaques. L’organisation écrit qu’à mesure que l’IA devient plus avancée, elle pourrait poser des risques catastrophiques ou existentiels.

La militarisation est une préoccupation particulière pour le PCSRA. Il écrit que des acteurs malveillants pourraient réutiliser l’IA pour qu’elle soit hautement destructrice. Un exemple donné est l’apprentissage automatique des outils de découverte de drogues utilisés pour fabriquer des armes chimiques.

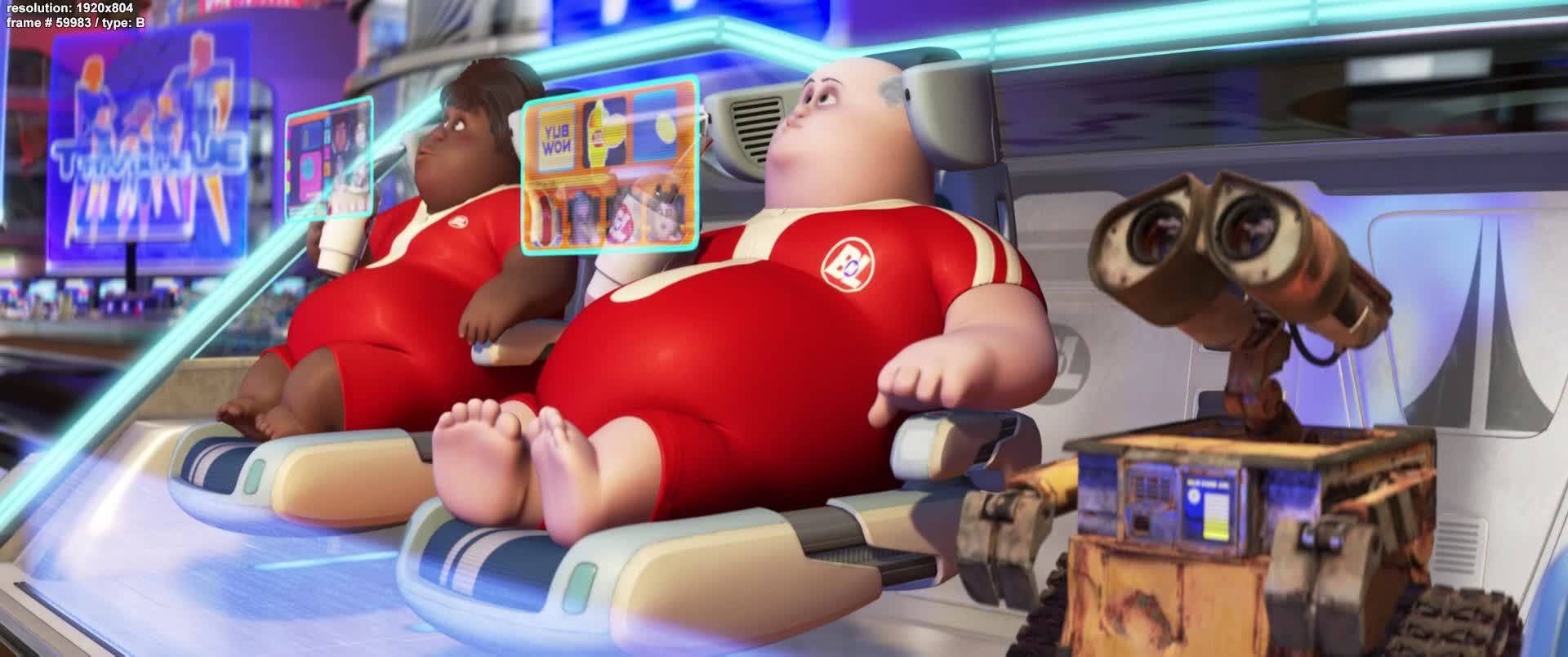

La désinformation générée par l’IA pourrait rendre la société moins équipée pour gérer des changements importants, et ces systèmes pourraient trouver de nouvelles façons de poursuivre leurs objectifs au détriment des valeurs individuelles et sociétales. Il y a aussi le risque d’affaiblissement, dans lequel les individus deviennent totalement dépendants des machines. Le PCSRA compare ce scénario à celui de WALL-E.

« Le monde a coopéré avec succès pour atténuer les risques liés à la guerre nucléaire. Le même niveau d’effort est nécessaire pour faire face aux dangers posés par les futurs systèmes d’IA », a déclaré le directeur du CAIS, Dan Hendrycks. Le registre.

Il n’y a pas que ceux qui sont impliqués dans l’IA qui craignent où la technologie pourrait mener. Plus des deux tiers des Américains pensent que cela pourrait menacer la civilisation, même si la plupart des adultes américains n’ont jamais utilisé ChatGPT. Nous avons également entendu Warren Buffett comparer l’IA à la création de la bombe atomique.

L’inclusion d’Altman sur la liste des signataires intervient après qu’OpenAI a appelé à la création d’un chien de garde mondial pour superviser le développement de l’IA. Certains affirment cependant que son plaidoyer en faveur d’une réglementation ne vise qu’à étouffer l’innovation de ses rivaux et à aider son entreprise à rester au top.

En mars, un groupe des meilleurs esprits technologiques du monde a signé une lettre demandant une pause de six mois sur le développement avancé de l’IA. Elon Musk était l’un des signataires, mais son nom est absent de la déclaration du PCSRA. Altman a confirmé en avril qu’OpenAI n’entraînait pas actuellement GPT-5.

Les avertissements concernant la destruction de l’humanité par l’IA existent depuis des années, mais l’avancement de ces systèmes en 2023 a alimenté les peurs comme jamais auparavant. Des déclarations constantes comme celle-ci ne font pas grand-chose pour apaiser les inquiétudes du public, mais il y a une bonne raison pour laquelle une réglementation est nécessaire, et il est peu probable que les entreprises la mettent en œuvre elles-mêmes sans pression.