Que se passerait-il si vous remplissiez une ville virtuelle d’IA et que vous les libériez ? Il s’avère qu’ils se brossent les dents et sont très gentils l’un avec l’autre ! Mais ce résultat peu excitant est une bonne nouvelle pour les chercheurs qui l’ont fait, puisqu’ils voulaient produire des « simulacres crédibles du comportement humain » et c’est exactement ce qu’ils ont obtenu.

L’article décrivant l’expérience, par des chercheurs de Stanford et de google, n’a pas été évalué par des pairs ni accepté pour publication, mais il constitue néanmoins une lecture intéressante. L’idée était de voir s’ils pouvaient appliquer les dernières avancées des modèles d’apprentissage automatique pour produire des « agents génératifs » qui prennent en compte leurs circonstances et produisent une action réaliste en réponse.

Et c’est vraiment ce qu’ils ont obtenu. Mais avant de vous laisser séduire par les images mignonnes et les descriptions de réflexion, de conversation et d’interaction, assurons-nous que vous comprenez que ce qui se passe ici ressemble plus à une troupe d’improvisation jouant un rôle sur un MUD qu’à n’importe quel type de proto-Skynet. (Seuls les millénaires comprendront la phrase précédente.)

Ces petits personnages ne sont pas tout à fait ce qu’ils semblent être. Les graphiques ne sont qu’une représentation visuelle de ce qui est essentiellement un tas de conversations entre plusieurs instances de ChatGPT. Les agents ne marchent pas de haut en bas, de gauche à droite ou ne s’approchent pas d’une armoire pour interagir avec elle. Tout cela se passe à travers une couche de texte complexe et cachée qui synthétise et organise les informations relatives à chaque agent.

Vingt-cinq agents, 25 instances de ChatGPT, chacun invité avec des informations au format similaire qui lui font jouer le rôle d’une personne dans une ville fictive. Voici comment une de ces personnes, John Lin, est configurée :

John Lin est un commerçant de pharmacie au Willow Market and Pharmacy qui aime aider les gens. Il cherche toujours des moyens de faciliter le processus d’obtention de médicaments pour ses clients. John Lin vit avec sa femme, Mei Lin, qui est professeur d’université, et son fils, Eddy Lin, qui étudie la théorie musicale. John Lin aime beaucoup sa famille ; John Lin connaît le vieux couple d’à côté, Sam Moore et Jennifer Moore, depuis quelques années ; John Lin pense que Sam Moore est un homme gentil et gentil…

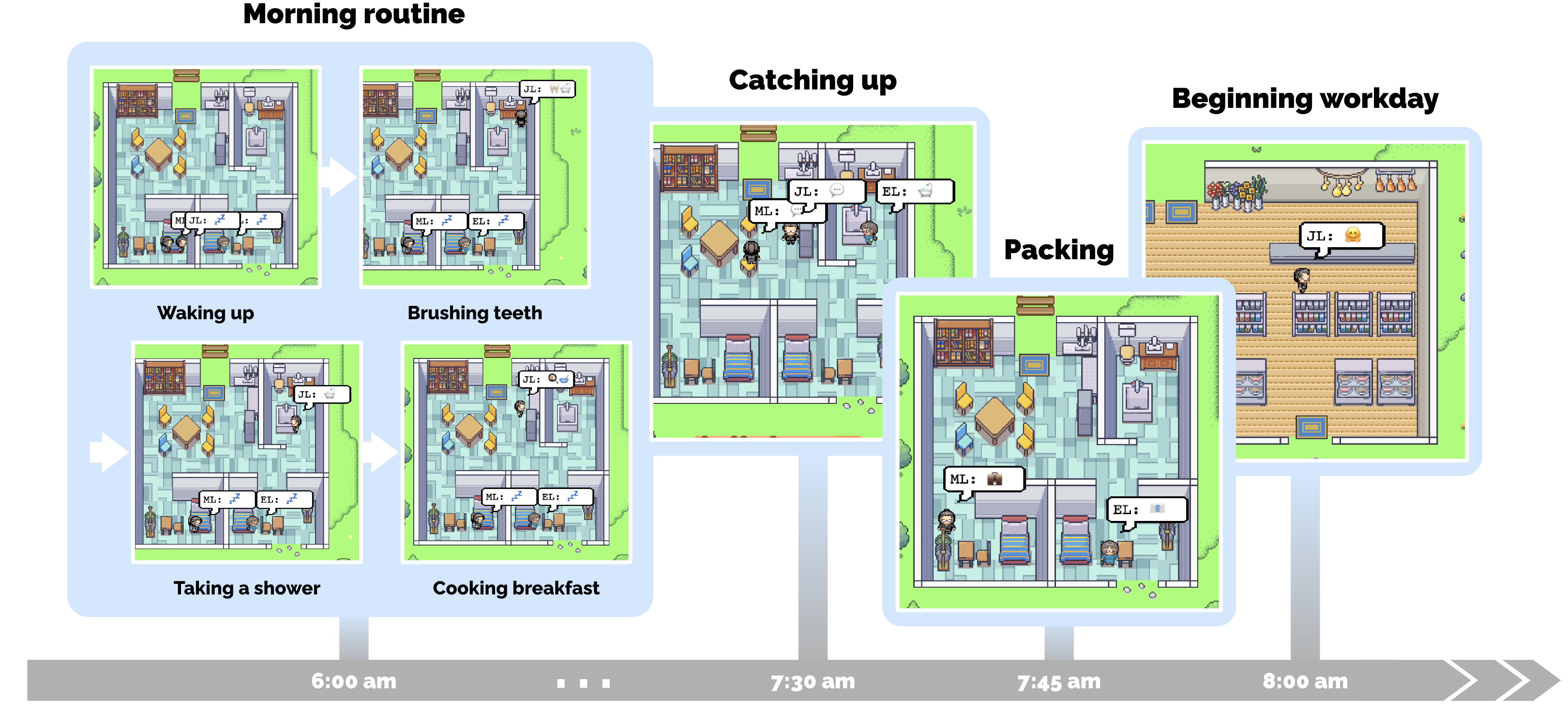

Avec ces informations, les agents sont ensuite invités à proposer leurs prochaines actions en fonction de l’heure et des circonstances. Par exemple, ils pourraient dire à l’agent John qu’il est 8 heures du matin et qu’il vient de se réveiller. Que fait-il? Eh bien, il se brosse les dents, embrasse sa femme (espérons-le dans cet ordre), s’habille, puis va à la cuisine.

Pendant ce temps, une autre instance ChatGPT totalement indépendante représentant le fils de John, Eddy, a également reçu ses propres informations. Lui aussi se lève, se brosse les dents, puis va à la cuisine.

Et maintenant, la structure globale de l’expérience intervient : les agents représentant John et Eddy ne sont pas tous les deux « dans » le même espace virtuel ou quoi que ce soit. Au lieu de cela, lorsque John a fini de s’habiller et dit qu’il va déménager dans la cuisine, le cadre expérimental l’informe que son fils Eddy est là, car dans son propre cas, Eddy a décidé d’emménager dans la cuisine à un moment qui se chevauche dans l’expérience. -niveau « jour », basé sur une estimation de la durée de diverses actions.

Puisqu’ils sont tous les deux dans la pièce en même temps, la configuration expérimentale les informe que l’autre personne est là – avec des informations comme celle-ci, il y a une table à laquelle personne n’est assis, le poêle est allumé, etc. faire ensuite?

Jean : Bonjour Eddy. Avez-vous bien dormi?

Eddy : Bonjour papa. Oui, j’ai très bien dormi.

Jean : C’est bien. Sur quoi travaillez-vous aujourd’hui ?

Eddy : Je travaille sur une nouvelle composition musicale pour ma classe. C’est pour cette semaine, alors j’essaie de le terminer. Mais je m’amuse tellement avec !

John : Ça sonne bien !

Quelle belle interaction normale entre un parent et son enfant. Ensuite, Mei entre et ils ont également une interaction agréable. Et tout est accompli en demandant à des chatbots totalement séparés ce qu’ils feraient si, dans une ville fictive où il est ce personne et avait une famille comme ce et était dans une chambre à ce temps, où ce se passait… qu’est-ce qu’ « ils », un vrai humain, feraient ?

Ainsi, ChatGPT devine ce qu’une personne ferait dans cette situation et donne sa réponse comme si elle jouait une aventure textuelle. Si vous lui disiez ensuite « il fait nuit noire, vous risquez d’être mangé par une grue », il dirait probablement qu’il allume une torche. Mais au lieu de cela, l’expérience permet aux personnages de poursuivre leur journée minute par minute, en faisant leurs courses, en se promenant dans le parc et en allant au travail.

Crédits image : Google/Université de Stanford

Les utilisateurs peuvent également écrire des événements et des circonstances, comme un robinet qui goutte ou un désir d’organiser une fête, et les agents répondent de manière appropriée, car tout texte, pour eux, est une réalité.

Tout cela est effectué en invitant laborieusement toutes ces instances de ChatGPT avec toutes les minuties des circonstances immédiates de l’agent. Voici une invite pour John lorsqu’il rencontre Eddy plus tard :

Nous sommes le 13 février 2023, 16h56.

Statut de John Lin : John est rentré tôt du travail.

Observation : John a vu Eddy faire une courte promenade autour de son lieu de travail.

Résumé du contexte pertinent de la mémoire de John :

Eddy Lin est le fils de John’s Lin. Eddy Lin travaille sur une composition musicale pour sa classe. Eddy Lin aime se promener dans le jardin quand il pense ou écoute de la musique.

John interroge Eddy sur son projet de composition musicale. Que dirait-il à Eddy ?[Answer:] Hey Eddy, comment avance le projet de composition musicale pour ta classe ?

Les instances commenceraient rapidement à oublier des choses importantes, car le processus est si long, de sorte que le cadre expérimental se trouve au-dessus de la simulation et leur rappelle des choses importantes ou les synthétise en éléments plus portables.

Par exemple, après que l’agent a été informé d’une situation dans le parc, où quelqu’un est assis sur un banc et a une conversation avec un autre agent, mais il y a aussi de l’herbe et du contexte et un siège vide au banc… dont aucun n’est important . Ce qui est important? De toutes ces observations, qui peuvent constituer des pages de texte pour l’agent, vous pourriez obtenir la « réflexion » que « Eddie et Fran sont amis parce que je les ai vus ensemble au parc ». Cela est entré dans la « mémoire » à long terme de l’agent – un tas de choses stockées en dehors de la conversation ChatGPT – et le reste peut être oublié.

Alors, à quoi tout ce charivari s’ajoute-t-il ? Quelque chose de moins que de véritables agents génératifs tels que proposés par l’article, bien sûr, mais aussi une première tentative extrêmement convaincante pour les créer. Dwarf Fortress fait la même chose, bien sûr, mais en codant à la main toutes les possibilités. Cela ne s’adapte pas bien !

Il n’était pas évident qu’un grand modèle de langage comme ChatGPT réponde bien à ce genre de traitement. Après tout, il n’a pas été conçu pour imiter des personnages fictifs arbitraires à long terme ou pour spéculer sur les détails les plus abrutissants de la journée d’une personne. Mais manipulés correctement – et avec une bonne dose de massage – non seulement un agent peut le faire, mais ils ne se cassent pas lorsque vous les utilisez comme pièces dans une sorte de diorama virtuel.

Cela a des implications potentiellement énormes pour les simulations d’interactions humaines, partout où elles peuvent être pertinentes – bien sûr, dans les jeux et les environnements virtuels, elles sont importantes, mais cette approche est encore monstrueusement peu pratique pour cela. Ce qui importe cependant, ce n’est pas que ce soit quelque chose que tout le monde puisse utiliser ou avec lequel jouer (même si ce sera bientôt, je n’en doute pas), mais que le système fonctionne du tout. Nous avons vu cela dans l’IA : si elle peut mal faire quelque chose, le fait qu’elle puisse le faire signifie généralement que ce n’est qu’une question de temps avant qu’elle ne le fasse bien.