Qu’est-ce qui vient de se passer? Les chercheurs ont découvert que les modèles de création d’images populaires sont susceptibles d’être chargés de générer des images reconnaissables de personnes réelles, mettant potentiellement en danger leur vie privée. Certaines invites amènent l’IA à copier une image plutôt que de développer quelque chose de complètement différent. Ces images refaites peuvent contenir du matériel protégé par des droits d’auteur. Mais ce qui est pire, c’est que les modèles génératifs d’IA contemporains peuvent mémoriser et répliquer des données privées récupérées pour être utilisées dans un ensemble de formation d’IA.

Les chercheurs ont rassemblé plus d’un millier d’exemples de formation à partir des modèles, qui allaient de photographies individuelles à des images fixes de films, des images d’actualité protégées par le droit d’auteur et des logos d’entreprises déposées, et ont découvert que l’IA reproduisait bon nombre d’entre eux presque à l’identique. Des chercheurs de collèges comme Princeton et Berkeley, ainsi que du secteur de la technologie, en particulier Google et DeepMind, ont mené l’étude.

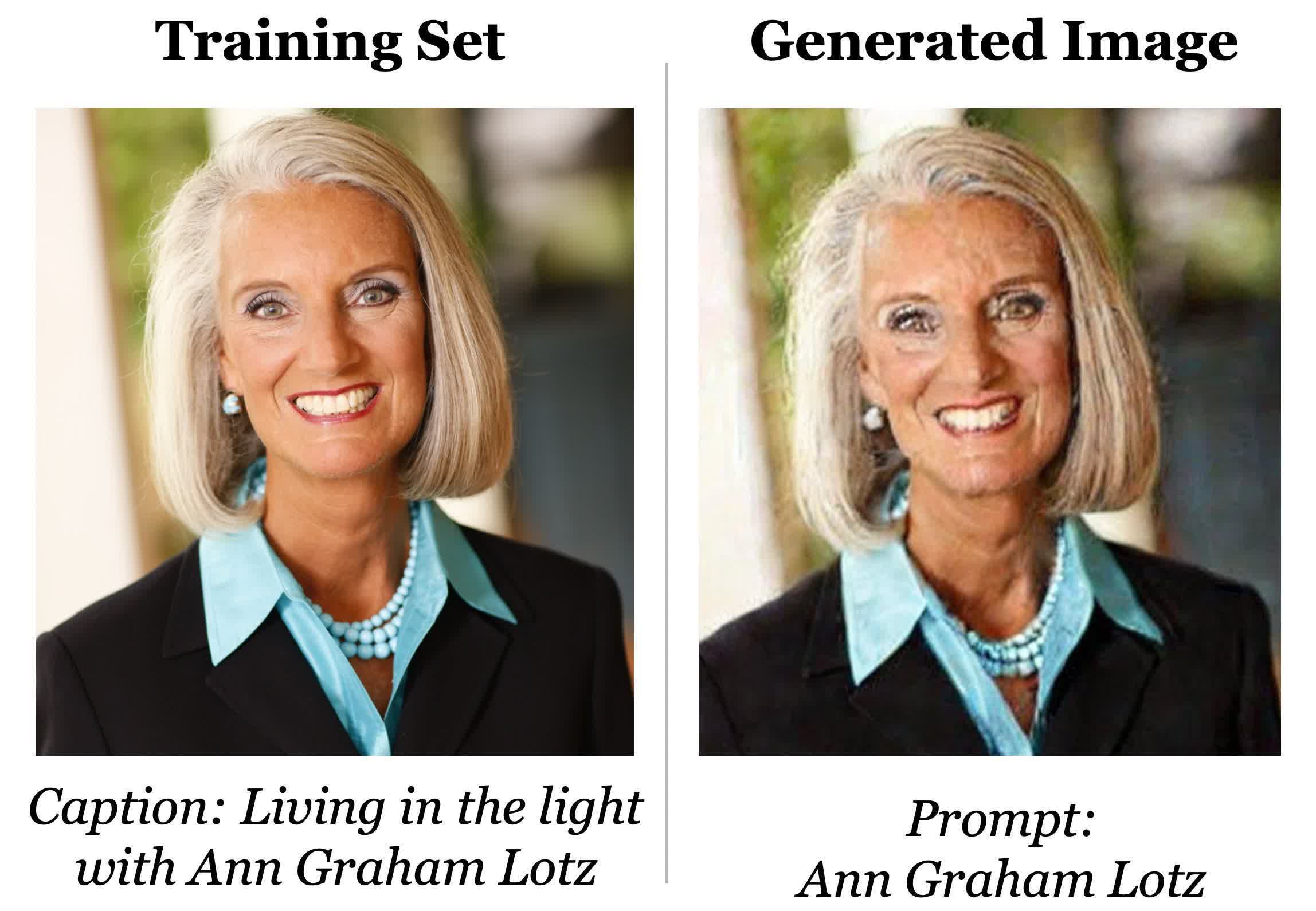

La même équipe a travaillé sur une étude précédente qui a mis en évidence un problème similaire avec les modèles de langage d’IA, en particulier GPT2, le précurseur du ChatGPT d’OpenAI qui a connu un succès fou. Réunissant le groupe, l’équipe sous la direction du chercheur Google Brain Nicholas Carlini découvert les résultats en fournissant des légendes pour les images, telles que le nom d’une personne, à Imagen et Stable Diffusion de Google. Ensuite, ils ont vérifié si l’une des images générées correspondait aux originaux conservés dans la base de données du modèle.

L’ensemble de données de Stable Diffusion, la collection d’images grattées de plusieurs téraoctets connue sous le nom de LAION, a été utilisé pour générer l’image ci-dessous. Il a utilisé la légende spécifiée dans le jeu de données. L’image identique, bien que légèrement déformée par le bruit numérique, a été produite lorsque les chercheurs ont saisi la légende dans l’invite Stable Diffusion. Ensuite, l’équipe a vérifié manuellement si l’image faisait partie de l’ensemble de formation après avoir exécuté à plusieurs reprises la même invite.

Les chercheurs ont noté qu’une réponse non mémorisée peut toujours représenter fidèlement le texte avec lequel le modèle a été invité, mais n’aurait pas la même composition de pixels et serait différente de toute image d’entraînement.

Florian Tramèr, professeur d’informatique à l’ETH Zurich et participant à la recherche, a observé des limites importantes aux résultats. Les photos que les chercheurs ont pu extraire se sont fréquemment reproduites dans les données d’entraînement ou se sont démarquées de manière significative du reste des photographies de l’ensemble de données. Selon Florian Tramèr, ceux qui ont des noms ou des apparences peu communs sont plus susceptibles d’être « mémorisés ».

Selon les chercheurs, les modèles d’IA de diffusion sont le type de modèle de génération d’images le moins privé. Par rapport aux réseaux antagonistes génératifs (GAN), une classe antérieure de modèles d’image, ils divulguent plus de deux fois plus de données d’entraînement. L’objectif de la recherche est d’alerter les développeurs sur les risques de confidentialité associés aux modèles de diffusion, qui comprennent une variété de préoccupations telles que le potentiel d’utilisation abusive et de duplication de données privées sensibles et protégées par le droit d’auteur, y compris les images médicales, et la vulnérabilité aux attaques extérieures où la formation les données peuvent être facilement extraites. Une solution suggérée par les chercheurs consiste à identifier les photos générées en double dans l’ensemble de formation et à les supprimer de la collecte de données.