En bref: OpenAI veut créer une intelligence artificielle générale (AGI) qui profite à toute l’humanité, et qui inclut la capacité de comprendre les concepts quotidiens et de les mélanger de manière créative. Les derniers modèles d’IA de la société combinent le traitement du langage naturel avec la reconnaissance d’image et montrent des résultats prometteurs pour atteindre cet objectif.

OpenAI est connu pour développer des modèles d’IA impressionnants tels que GPT-2 et GPT-3, qui sont capables d’écrire de fausses nouvelles crédibles mais peuvent également devenir des outils essentiels pour détecter et filtrer la désinformation en ligne et le spam. Auparavant, ils ont également créé des robots capables de battre des adversaires humains dans des jeux comme Dota 2, car ils peuvent jouer d’une manière qui nécessiterait des milliers d’années d’entraînement.

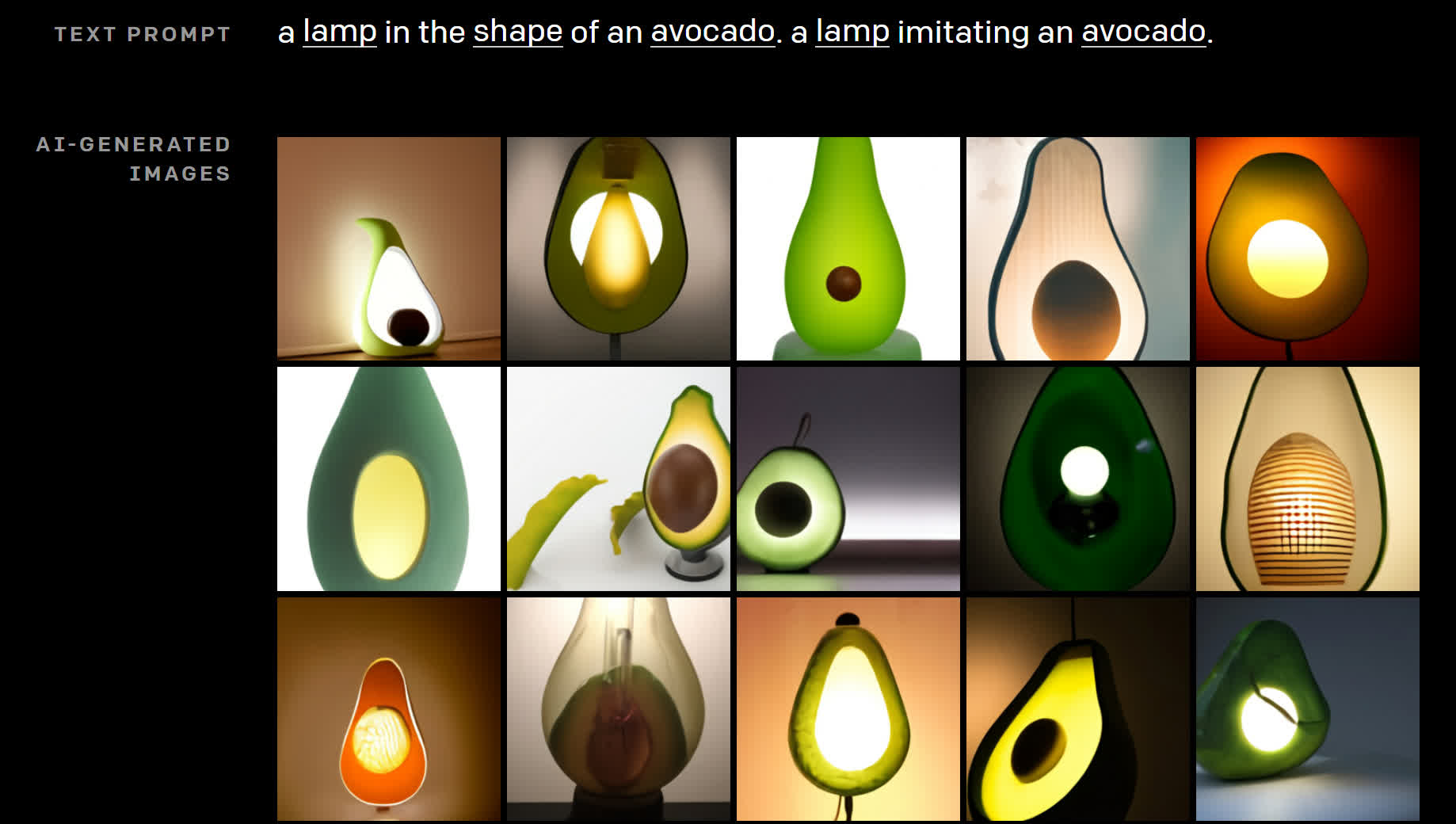

Le groupe de recherche a mis au point deux modèles supplémentaires qui s’appuient sur cette base. Le premier appelé DALL-E est un réseau neuronal qui peut essentiellement créer une image basée sur la saisie de texte. Le co-fondateur et scientifique en chef d’OpenAI, Ilya Sutskever, note qu’avec ses 12 milliards de paramètres, DALL-E est capable de créer presque tout ce que vous pouvez décrire, même des concepts qu’il n’aurait jamais vus en formation.

Par exemple, le nouveau système d’IA est capable de générer une image qui représente « une illustration d’un bébé radis daikon dans un tutu promenant un chien », « un vitrail avec une image d’une fraise bleue », « un fauteuil dans le la forme d’un avocat »ou« un escargot fait d’une harpe ».

DALL-E est capable de générer plusieurs résultats plausibles pour ces descriptions et bien d’autres, ce qui montre que la manipulation de concepts visuels à travers l’utilisation du langage naturel est désormais à portée de main.

Sutskever dit que «le travail impliquant des modèles génératifs a le potentiel d’avoir des impacts sociétaux importants et larges. À l’avenir, nous prévoyons d’analyser comment des modèles comme DALL-E sont liés à des problèmes sociétaux tels que l’impact économique sur certains processus de travail et certaines professions, le potentiel de biais dans les résultats du modèle et les défis éthiques à long terme impliqués par cette technologie. «

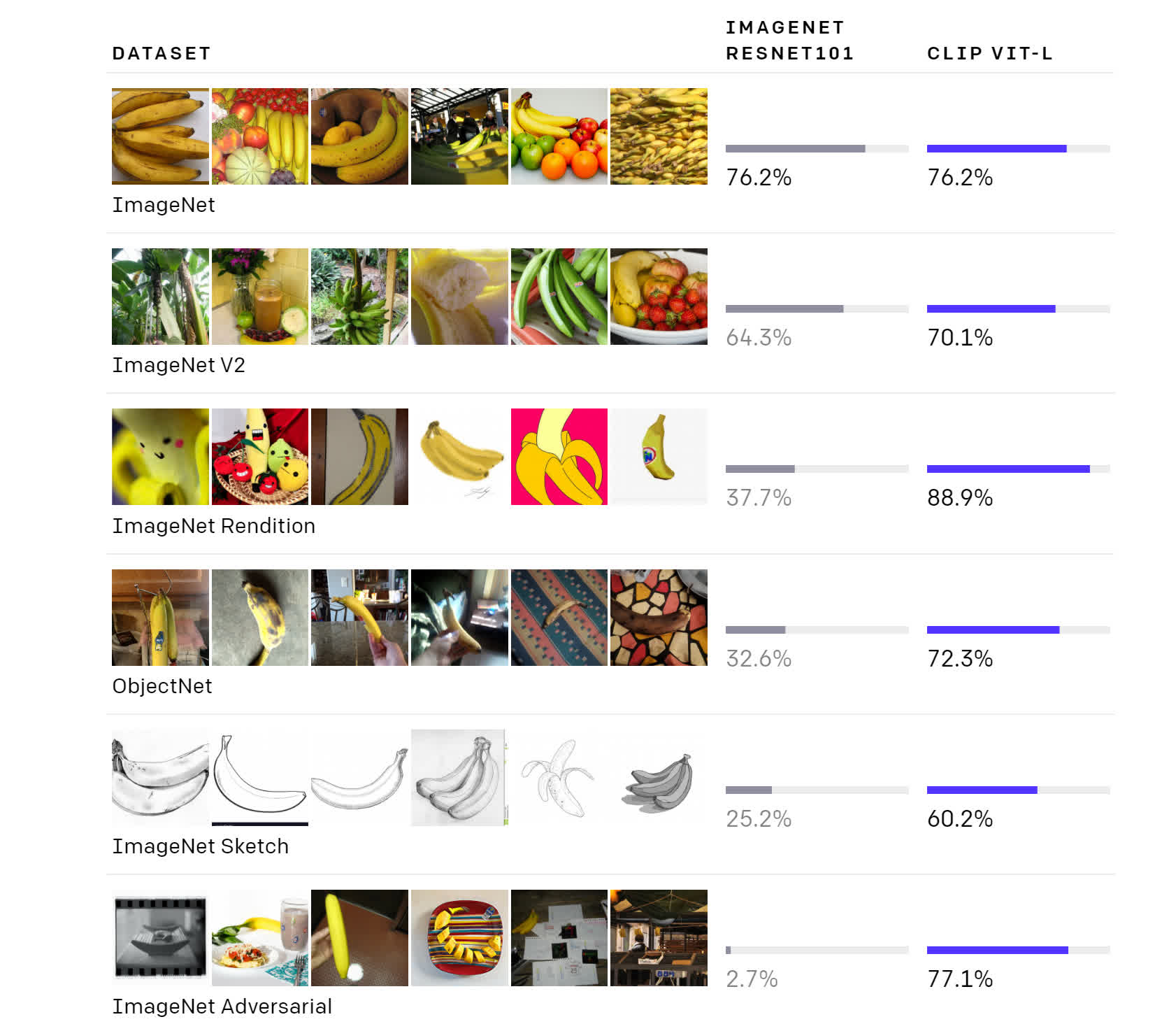

Le deuxième modèle d’IA multimodal introduit par OpenAI s’appelle AGRAFE. Formé sur pas moins de 400 millions de paires de textes et d’images extraites du Web, la force de CLIP est sa capacité à prendre un concept visuel et à trouver la description textuelle la plus susceptible d’être une description précise de celui-ci en utilisant très peu de formation.

Cela peut réduire le coût de calcul de l’IA dans certaines applications telles que la reconnaissance de caractères d’objet (OCR), la reconnaissance d’actions et la géolocalisation. Cependant, les chercheurs ont constaté qu’il ne fonctionnait pas dans d’autres tâches telles que la détection des tumeurs des ganglions lymphatiques et la classification des images satellites.

En fin de compte, DALL-E et CLIP ont été conçus pour donner aux modèles de langage comme GPT-3 une meilleure compréhension des concepts quotidiens que nous utilisons pour comprendre le monde qui nous entoure, même s’ils sont encore loin d’être parfaits. C’est une étape importante pour l’IA, qui pourrait ouvrir la voie à de nombreux outils utiles qui augmenteront les humains dans leur travail.