Depuis qu’Amazon a lancé sa branche de services de cloud computing en 2006 – largement connue sous le nom d’AWS (Amazon Web Services) – l’entreprise s’est donné pour mission de convertir le monde à sa vision de la manière dont les ressources informatiques peuvent être achetées et déployées, mais aussi pour les rendre aussi omniprésents que possible. Cette stratégie a été exposée au salon de cette année re: Inventer.

AWS a lancé plusieurs nouvelles options informatiques, certaines basées sur ses propres nouvelles conceptions de silicium personnalisées, ainsi qu’un éventail impressionnant d’outils et de services d’organisation, d’analyse et de connexion des données. Le nombre et la complexité de bon nombre des nouvelles fonctionnalités et services qui ont été dévoilés rendent difficile le suivi de tous les choix désormais disponibles pour les clients. Plutôt que d’être le résultat d’un développement incontrôlé, cependant, l’abondance de capacités est voulue.

Le nouveau PDG d’AWS, Adam Selipsky, a tenu à souligner lors de son discours (regarder ci-dessus) et d’autres apparitions que l’organisation est « obsédée » par le client. Par conséquent, la plupart de ses décisions et stratégies de produits sont basées sur les demandes des clients. Il s’avère que lorsque vous avez de nombreux types de clients différents avec différents types de charges de travail et d’exigences, vous vous retrouvez avec un éventail complexe de choix.

De manière réaliste, ce type d’approche atteindra une limite logique à un moment donné, mais en attendant, cela signifie que la vaste gamme de produits et services AWS représente probablement une image miroir de la totalité (et de la complexité) du paysage informatique d’entreprise actuel. En fait, il existe une mine d’informations sur les tendances informatiques d’entreprise qui attendent d’être glanées à partir d’une analyse des services utilisés, à quel degré et comment ils ont évolué au fil du temps, mais c’est un sujet pour une autre fois.

Dans le monde des options informatiques, la société a reconnu qu’elle disposait désormais de plus de 600 instances informatiques EC2 (Elastic Compute Cloud) différentes, chacune composée de différentes combinaisons de CPU et d’autres siliciums d’accélération, de mémoire, de connexions réseau, etc. Bien qu’il s’agisse d’un chiffre difficile à apprécier pleinement, cela indique une fois de plus à quel point les demandes informatiques d’aujourd’hui sont devenues diverses. Qu’il s’agisse d’applications cloud natives, basées sur l’IA ou le ML, conteneurisées qui nécessitent les derniers accélérateurs d’IA ou GPU dédiés, aux applications d’entreprise héritées « levées et déplacées » qui n’utilisent que des processeurs x86 plus anciens, les services de cloud computing comme AWS doivent désormais être en mesure de gérer tous de ce qui précède.

Les nouvelles entrées annoncées cette année incluent plusieurs basées sur les processeurs évolutifs Xeon de 3e génération d’Intel. Cependant, ce qui a reçu le plus d’attention, ce sont les instances basées sur trois des nouvelles conceptions de silicium d’Amazon. La Hpc7g L’instance est basée sur une version mise à jour du processeur Graviton3 basé sur Arm appelé Graviton3E qui, selon la société, offre 2 fois les performances en virgule flottante de l’instance Hpc6g précédente et 20% de performances globales par rapport à l’actuel Hpc6a.

Comme dans de nombreux cas, Hpc7g cible un ensemble spécifique de charges de travail, dans ce cas le calcul haute performance (HPC), comme les prévisions météorologiques, le traitement génomique, la dynamique des fluides, etc. Plus précisément, il est conçu pour les modèles ML plus volumineux qui finissent souvent par s’exécuter sur des milliers de cœurs. Ce qui est intéressant à ce sujet, c’est que cela montre à la fois à quel point les processeurs basés sur Arm ont progressé en termes de types de charges de travail pour lesquels ils ont été utilisés, ainsi que le degré de raffinement qu’AWS apporte à ses différentes instances EC2.

Lisez aussi : Pourquoi Amazon construit-il des processeurs ?

Séparément, dans plusieurs autres sessions, AWS a souligné l’élan vers l’utilisation de Graviton pour de nombreux autres types de charges de travail également, en particulier pour les applications conteneurisées natives du cloud de clients AWS comme DirecTV et Stripe.

Un aperçu intrigant qui est ressorti de ces sessions est qu’en raison de la nature des outils utilisés pour développer ces types d’applications, les défis du portage du code de x86 vers les instructions natives Arm (qui étaient autrefois considérées comme un énorme point d’arrêt pour Adoption de serveurs basés sur Arm) ont largement disparu.

Au lieu de cela, tout ce qui est requis est le simple changement de quelques options avant que le code ne soit terminé et déployé sur l’instance. Cela rend le potentiel de croissance future du cloud computing basé sur Arm beaucoup plus probable, en particulier sur les nouvelles applications.

Bien sûr, certaines de ces organisations s’efforcent de créer à l’avenir des applications complètement indépendantes du jeu d’instructions, ce qui rendrait apparemment le choix du jeu d’instructions non pertinent. Cependant, même dans cette situation, les instances de calcul qui offrent de meilleurs rapports prix/performances ou performances/watt, que les processeurs basés sur Arm ont souvent, sont une option plus attrayante.

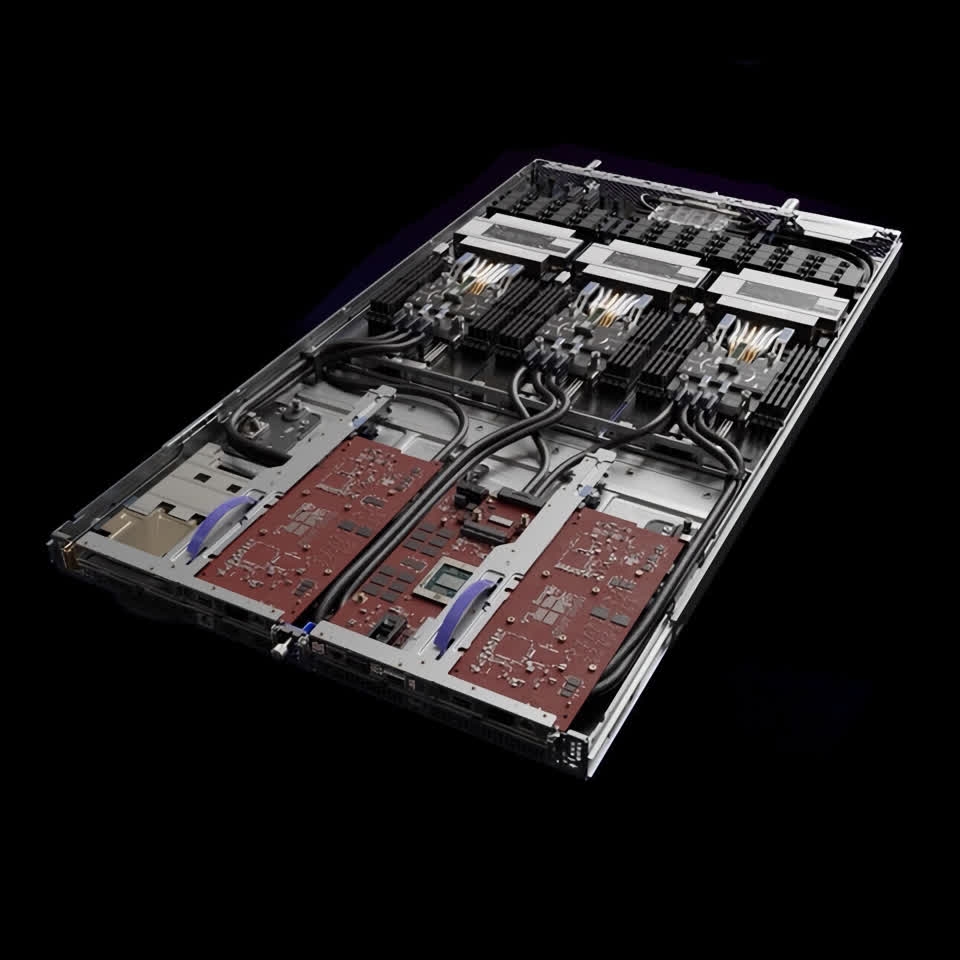

Pour les charges de travail ML, Amazon a dévoilé sa deuxième génération Inférence processeur dans le cadre de sa nouvelle instance Inf2. Inferentia2 est conçu pour prendre en charge l’inférence ML sur des modèles avec des milliards de paramètres, tels que de nombreux nouveaux grands modèles de langage pour des applications telles que la reconnaissance vocale en temps réel qui sont actuellement en développement.

La nouvelle architecture est conçue pour s’adapter à des milliers de cœurs, ce que ces énormes nouveaux modèles, tels que GPT-3, exigent. En outre, Inferentia2 inclut la prise en charge d’une technique mathématique connue sous le nom d’arrondi stochastique, qu’AWS décrit comme « une manière d’arrondir de manière probabiliste qui permet des performances élevées et une plus grande précision par rapport aux modes d’arrondi hérités ». Pour tirer le meilleur parti de l’informatique distribuée, l’instance Inf2 prend également en charge une version de nouvelle génération de l’architecture de réseau en anneau NeuronLink de la société, qui est censée offrir 4 fois les performances et 1/10 la latence des instances Inf1 existantes. La traduction de l’essentiel est qu’il peut offrir des performances par watt 45% plus élevées pour l’inférence que toute autre option, y compris celles alimentées par GPU. Étant donné que les besoins de consommation d’énergie d’inférence sont souvent 9 fois plus élevés que ce qui est nécessaire pour la formation de modèles selon AWS, c’est un gros problème.

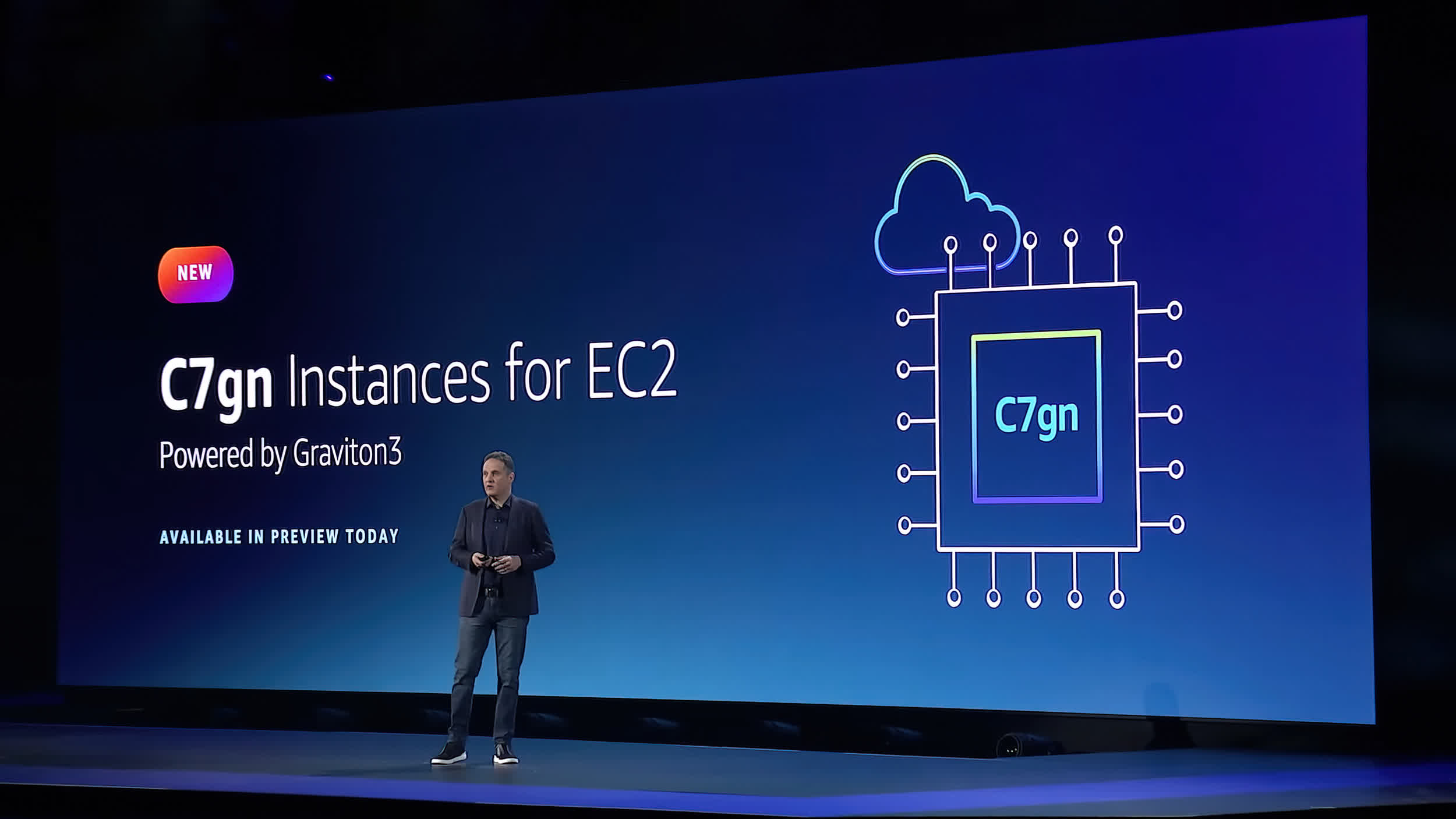

La troisième nouvelle instance pilotée par silicium personnalisé s’appelle C7gn et comprend une nouvelle carte réseau AWS Nitro équipée de puces Nitro de cinquième génération. Conçu spécifiquement pour les charges de travail qui exigent un débit extrêmement élevé, telles que les pare-feu, le réseau virtuel et le chiffrement/déchiffrement des données en temps réel, C7gn est censé avoir 2 fois la bande passante réseau et un traitement des paquets 50 % plus élevé par seconde que les instances précédentes. Surtout, les nouvelles cartes Nitro sont capables d’atteindre ces niveaux avec une amélioration de 40% des performances par watt par rapport à ses prédécesseurs.

Au total, l’accent mis par Amazon sur le silicium personnalisé et une gamme de plus en plus diversifiée d’options informatiques représente un ensemble complet d’outils pour les entreprises qui cherchent à déplacer davantage de leurs charges de travail vers le cloud. Comme pour de nombreux autres aspects de ses offres AWS, la société continue d’affiner et d’améliorer ce qui est clairement devenu un ensemble d’outils très sophistiqués et matures. Ensemble, ils offrent une vision remarquable et prometteuse de l’avenir de l’informatique et des nouveaux types d’applications qu’ils peuvent activer.

Bob O’Donnell est le fondateur et analyste en chef de TECHnalysis Research, LLC une société de conseil en technologie qui fournit des services de conseil stratégique et d’étude de marché à l’industrie technologique et à la communauté financière professionnelle. Vous pouvez le suivre sur Twitter @bobodtech.