La division cloud de Google emboîte le pas à Microsoft avec le lancement de Atelier d’IA de sécurité qui exploite des modèles d’IA génératifs pour obtenir une meilleure visibilité sur le paysage des menaces.

Sec-PaLM, un grand modèle de langage spécialisé (LLM) qui est « affiné pour les cas d’utilisation de la sécurité ».

L’idée est de tirer parti des dernières avancées de l’IA pour augmenter l’analyse des incidents ponctuels, la détection des menaces et l’analyse afin de contrer et de prévenir les nouvelles infections en fournissant des renseignements qui sont fiable, pertinent et exploitable.

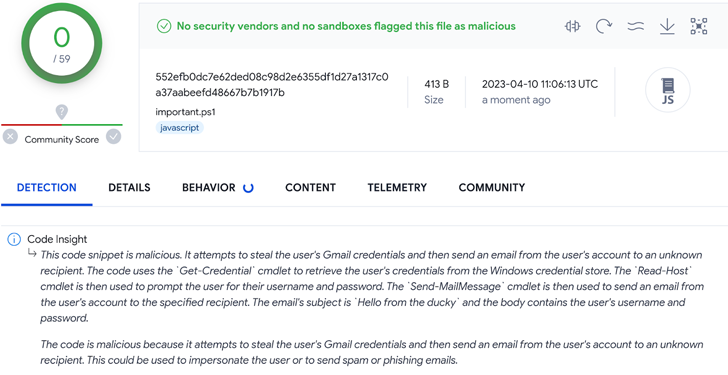

À cette fin, Security AI Workbench couvre une large gamme de nouveaux outils alimentés par l’IA, y compris Aperçu du code VirusTotal et Mandiant Breach Analytics pour Chroniclepour analyser les scripts potentiellement malveillants et alerter les clients des violations actives dans leurs environnements.

Les utilisateurs, comme avec le copilote de sécurité basé sur GPT-4 de Microsoft, peuvent « rechercher, analyser et enquêter de manière conversationnelle sur les données de sécurité » dans le but de réduire le temps moyen de réponse et de déterminer rapidement l’étendue complète des événements.

D’autre part, la fonctionnalité Code Insight de VirusTotal est conçue pour générer des résumés en langage naturel d’extraits de code afin de détecter et d’atténuer les menaces potentielles. Il peut également être utilisé pour signaler les faux négatifs et effacer les faux positifs.

Une autre offre clé est Centre de commande de sécurité IAqui utilise Sec-PaLM pour fournir aux opérateurs « une analyse quasi instantanée des résultats et des chemins d’attaque possibles », ainsi que les actifs impactés et les mesures d’atténuation recommandées.

Google utilise également des modèles d’apprentissage automatique pour détecter et répondre aux Abus d’API et attaques de logique métierdans lequel un adversaire arme une fonctionnalité légitime pour atteindre un objectif néfaste sans déclencher d’alerte de sécurité.

Zero Trust + Deception : apprenez à déjouer les attaquants !

Découvrez comment Deception peut détecter les menaces avancées, arrêter les mouvements latéraux et améliorer votre stratégie Zero Trust. Rejoignez notre webinaire perspicace !

« Parce que Security AI Workbench est basé sur l’infrastructure Vertex AI de Google Cloud, les clients contrôlent leurs données avec des fonctionnalités de niveau entreprise telles que l’isolation des données, la protection des données, la souveraineté et la prise en charge de la conformité », a déclaré Sunil Potti de Google Cloud.

Le développement intervient quelques jours après que Google a annoncé la création d’une nouvelle unité appelée Google DeepMind qui réunit ses groupes de recherche sur l’IA de DeepMind et l’équipe Brain de Google Research pour « construire plus systèmes capables de manière plus sûre et responsable. »

Les nouvelles de Google Security AI Workbench suivent également celles de GitLab des plans pour intégrer l’IA dans sa plate-forme pour aider les développeurs à éviter les fuites de jetons d’accès et à éviter les faux positifs lors des tests de sécurité.