Apple a annoncé jeudi qu’il introduisait de nouvelles fonctionnalités de sécurité pour les enfants dans iOS, iPadOS, watchOS et macOS dans le cadre de ses efforts pour limiter la propagation du matériel pédopornographique (CSAM) aux États-Unis.

À cet effet, le fabricant de l’iPhone a déclaré qu’il avait l’intention de commencer l’analyse côté client des images partagées via chaque appareil Apple pour le contenu connu d’abus d’enfants au fur et à mesure qu’ils sont téléchargés dans iCloud Photos, en plus de tirer parti de l’apprentissage automatique sur l’appareil pour vérifier tous les iMessage. images envoyées ou reçues par des comptes mineurs (âgés de moins de 13 ans) pour avertir les parents de photos sexuellement explicites dans la plateforme de messagerie.

En outre, Apple prévoit également de mettre à jour Siri et Search pour organiser une intervention lorsque les utilisateurs tentent d’effectuer des recherches sur des sujets liés à CSAM, alertant que « l’intérêt pour ce sujet est nuisible et problématique ».

« Messages utilise l’apprentissage automatique sur l’appareil pour analyser les pièces jointes d’images et déterminer si une photo est sexuellement explicite », Apple c’est noté. « La fonctionnalité est conçue pour qu’Apple n’ait pas accès aux messages. » La fonctionnalité, appelée Sécurité de la communication, serait un paramètre d’adhésion qui doit être activé par les parents via la fonctionnalité de partage familial.

Comment le matériel d’abus sexuel d’enfants est détecté

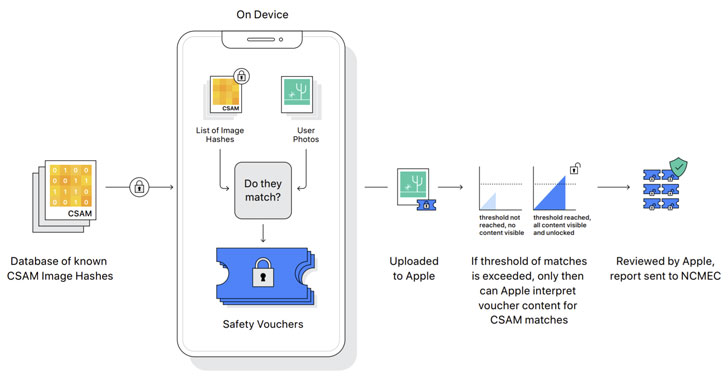

Détection d’images CSAM connues implique effectuer une correspondance sur l’appareil à l’aide d’une base de données de hachages d’images CSAM connus fournie par le National Center for Missing and Exploited Children (NCMEC) et d’autres organisations de sécurité des enfants avant que les photos ne soient téléchargées sur le cloud. « NeuralHash », comme on appelle le système, est alimenté par une technologie cryptographique connue sous le nom de intersection ensemble privé. Cependant, il convient de noter que même si la numérisation se fait automatiquement, la fonctionnalité ne fonctionne que lorsque le partage de photos iCloud est activé.

De plus, Apple devrait utiliser un autre principe cryptographique appelé partage de secret de seuil qui lui permet « d’interpréter » le contenu si un compte iCloud Photos franchit un seuil d’images d’abus d’enfants connus, après quoi le contenu est examiné manuellement pour confirmer qu’il y a un correspond, et si c’est le cas, désactivez le compte de l’utilisateur, signalez le matériel au NCMEC et transmettez-le aux forces de l’ordre.

Les chercheurs expriment leur inquiétude concernant la confidentialité

L’initiative CSAM d’Apple a incité les chercheurs en sécurité à exprimer des angoisses qu’il pourrait souffrir d’un glissement de mission et être étendu pour détecter d’autres types de contenu qui pourraient avoir des implications politiques et de sécurité, ou même piéger des individus innocents en leur envoyant des images inoffensives mais malveillantes conçues pour apparaître comme des correspondances pour la pornographie enfantine.

Le lanceur d’alerte américain Edward Snowden tweeté que, malgré les bonnes intentions du projet, ce qu’Apple déploie est une « surveillance de masse », tandis que le professeur de cryptographie et expert en sécurité de l’Université Johns Hopkins Matthieu Vert mentionné, « le problème est que le cryptage est un outil puissant qui assure la confidentialité, et vous ne pouvez pas vraiment avoir une confidentialité solide tout en surveillant chaque image que quelqu’un envoie. »

Apple vérifie déjà les fichiers et images iCloud envoyés par e-mail par rapport aux images d’abus d’enfants connus, tout comme les géants de la technologie comme Google, Twitter, Microsoft, Facebook et Dropbox, qui emploient méthodes de hachage d’image similaires rechercher et signaler des abus potentiels, mais la tentative d’Apple de marcher sur la corde raide de la vie privée pourrait renouveler les débats sur l’affaiblissement du cryptage, l’escalade d’un bras de fer de longue date sur la vie privée et le maintien de l’ordre à l’ère numérique.

Le New York Times, dans un enquête 2019, a révélé qu’un nombre record de 45 millions de photos et de vidéos en ligne d’enfants victimes d’abus sexuels ont été signalés en 2018, dont Facebook Messenger représentait près des deux tiers, Facebook dans son ensemble étant responsable de 90 % des signalements.

Apple, ainsi que WhatsApp, propriété de Facebook, ont continuellement résisté aux efforts visant à affaiblir intentionnellement le cryptage et à dérober leurs systèmes. Cela dit, Reuters signalé l’année dernière, la société a abandonné son projet de chiffrer les sauvegardes complètes des utilisateurs sur iCloud en 2018 après que le Federal Bureau of Investigation (FBI) des États-Unis a fait part de ses inquiétudes selon lesquelles cela entraverait les enquêtes.

« L’exploitation des enfants est un problème sérieux, et Apple n’est pas la première entreprise technologique à modifier sa position de protection de la vie privée pour tenter de la combattre. Mais ce choix aura un prix élevé pour la confidentialité globale des utilisateurs », a déclaré l’Electronic Frontier Foundation. (EFF) mentionné dans un communiqué, notant que la décision d’Apple pourrait briser les protections de cryptage et ouvrir la porte à des abus plus larges.

« Tout ce qu’il faudrait pour élargir la porte dérobée étroite qu’Apple construit, c’est une extension des paramètres d’apprentissage automatique pour rechercher des types de contenu supplémentaires, ou un ajustement des indicateurs de configuration à analyser, pas seulement les comptes des enfants, mais ceux de n’importe qui. Ce n’est pas le cas. une pente glissante ; c’est un système entièrement construit qui n’attend que la pression extérieure pour faire le moindre changement », a-t-il ajouté.

Les efforts CSAM devraient être déployés aux États-Unis dans les mois à venir dans le cadre d’iOS 15 et de macOS Monterey, mais il reste à voir si, ou quand, il sera disponible à l’international. En décembre 2020, Facebook était forcé d’éteindre certains de ses outils de détection d’abus d’enfants en Europe en réponse aux récents changements apportés à la directive sur la confidentialité en ligne de la Commission européenne qui interdisent effectivement les systèmes automatisés de recherche d’images d’abus sexuels d’enfants et d’autres contenus illégaux sans le consentement explicite des utilisateurs.