Hadoop est un framework open-source largement utilisé pour gérer Big Data. La plupart Bigdata / Analyse des données les projets se construisent en plus de Système écologique Hadoop. Il se compose de deux couches, l’une est pour Stocker des données et un autre est pour Données en cours.

Espace de rangement sera pris en charge par son propre système de fichiers appelé HDFS (Système de fichiers distribué Hadoop) et En traitement sera pris en charge par FIL (Encore un autre négociateur de ressources). Mapréduce est le moteur de traitement par défaut du Système écologique Hadoop.

Cet article décrit le processus d’installation du Pseudonode installation de Hadoop, où tous les démons (JVM) fonctionnera Nœud unique Cluster sur CentOS 7.

C’est principalement pour les débutants d’apprendre Hadoop. En temps réel, Hadoop sera installé en tant que cluster multinœud où les données seront réparties entre les serveurs sous forme de blocs et le travail sera exécuté de manière parallèle.

Conditions préalables

Installation de Java sur CentOS 7

1. Hadoop est un Eco-System composé de Java. Nous avons besoin Java installé dans notre système obligatoirement pour installer Hadoop.

# yum install java-1.8.0-openjdk

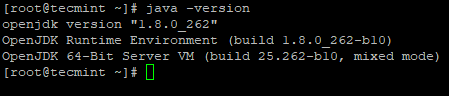

2. Ensuite, vérifiez la version installée de Java sur le système.

# java -version

Configurer la connexion sans mot de passe sur CentOS 7

Nous devons avoir ssh configuré dans notre machine, Hadoop gérera les nœuds avec l’utilisation de SSH. Utilisation du nœud maître SSH connexion pour connecter ses nœuds esclaves et effectuer des opérations telles que le démarrage et l’arrêt.

Nous devons configurer ssh sans mot de passe pour que le maître puisse communiquer avec les esclaves en utilisant ssh sans mot de passe. Sinon, pour chaque établissement de connexion, vous devez entrer le mot de passe.

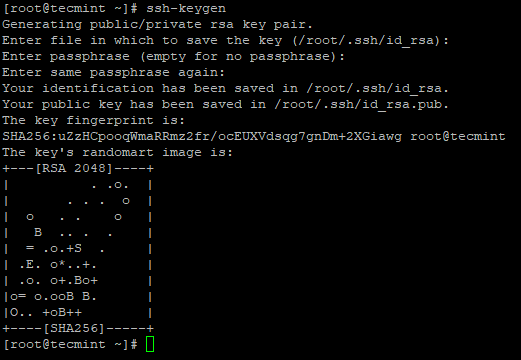

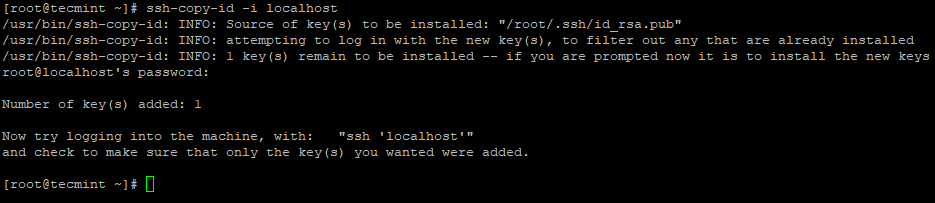

3. Configurez une connexion SSH sans mot de passe à l’aide des commandes suivantes sur le serveur.

# ssh-keygen # ssh-copy-id -i localhost

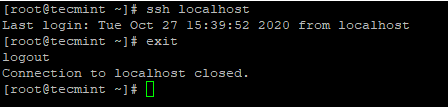

4. Après avoir configuré la connexion SSH sans mot de passe, essayez de vous connecter à nouveau, vous serez connecté sans mot de passe.

# ssh localhost

Installation de Hadoop dans CentOS 7

5. Accédez au site Web Apache Hadoop et téléchargez la version stable de Hadoop en utilisant ce qui suit commande wget.

# wget https://archive.apache.org/dist/hadoop/core/hadoop-2.10.1/hadoop-2.10.1.tar.gz # tar xvpzf hadoop-2.10.1.tar.gz

6. Ensuite, ajoutez le Hadoop variables d’environnement dans ~/.bashrc fichier comme indiqué.

HADOOP_PREFIX=/root/hadoop-2.10.1 PATH=$PATH:$HADOOP_PREFIX/bin export PATH JAVA_HOME HADOOP_PREFIX

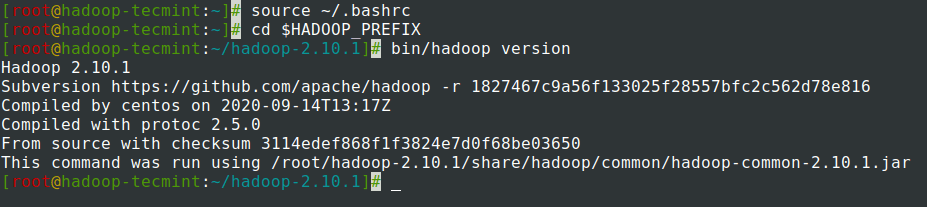

sept. Après avoir ajouté des variables d’environnement à ~/.bashrc le fichier, sourcez le fichier et vérifiez Hadoop en exécutant les commandes suivantes.

# source ~/.bashrc # cd $HADOOP_PREFIX # bin/hadoop version

Configurer Hadoop dans CentOS 7

Nous devons configurer ci-dessous les fichiers de configuration Hadoop afin de s’adapter à votre machine. Dans Hadoop, chaque service a son propre numéro de port et son propre répertoire pour stocker les données.

- Fichiers de configuration Hadoop – core-site.xml, hdfs-site.xml, mapred-site.xml et yarn-site.xml

8. Tout d’abord, nous devons mettre à jour JAVA_HOME et Hadoop chemin dans le hadoop-env.sh fichier comme indiqué.

# cd $HADOOP_PREFIX/etc/hadoop # vi hadoop-env.sh

Entrez la ligne suivante au début du fichier.

export JAVA_HOME=/usr/lib/jvm/java-1.8.0/jre export HADOOP_PREFIX=/root/hadoop-2.10.1

9. Ensuite, modifiez le core-site.xml fichier.

# cd $HADOOP_PREFIX/etc/hadoop # vi core-site.xml

Coller suivant entre <configuration> balises comme indiqué.

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

dix. Créez les répertoires ci-dessous sous tecmint répertoire de base de l’utilisateur, qui sera utilisé pour NN et DN espace de rangement.

# mkdir -p /home/tecmint/hdata/ # mkdir -p /home/tecmint/hdata/data # mkdir -p /home/tecmint/hdata/name

dix. Ensuite, modifiez le hdfs-site.xml fichier.

# cd $HADOOP_PREFIX/etc/hadoop # vi hdfs-site.xml

Coller suivant entre <configuration> balises comme indiqué.

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/home/tecmint/hdata/name</value>

</property>

<property>

<name>dfs .datanode.data.dir</name>

<value>home/tecmint/hdata/data</value>

</property>

</configuration>

11. Encore une fois, modifiez le mapred-site.xml fichier.

# cd $HADOOP_PREFIX/etc/hadoop # cp mapred-site.xml.template mapred-site.xml # vi mapred-site.xml

Coller suivant entre <configuration> balises comme indiqué.

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

12. Enfin, modifiez le yarn-site.xml fichier.

# cd $HADOOP_PREFIX/etc/hadoop # vi yarn-site.xml

Coller suivant entre <configuration> balises comme indiqué.

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

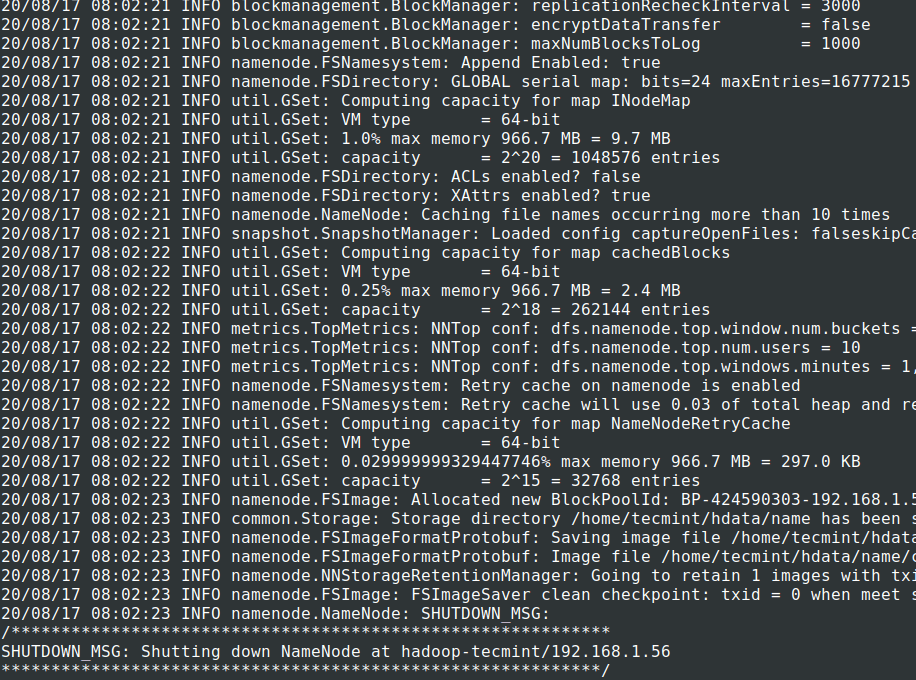

Formatage du système de fichiers HDFS via le NameNode

13. Avant de démarrer le Grappe, nous devons formater le Hadoop NN dans notre système local où il a été installé. Habituellement, cela sera fait dans la phase initiale avant de démarrer le cluster pour la première fois.

Formater le NN entraînera une perte de données dans le métastore NN, nous devons donc être plus prudents, nous ne devons pas formater NN pendant que le cluster est en cours d’exécution, sauf si cela est requis intentionnellement.

# cd $HADOOP_PREFIX # bin/hadoop namenode -format

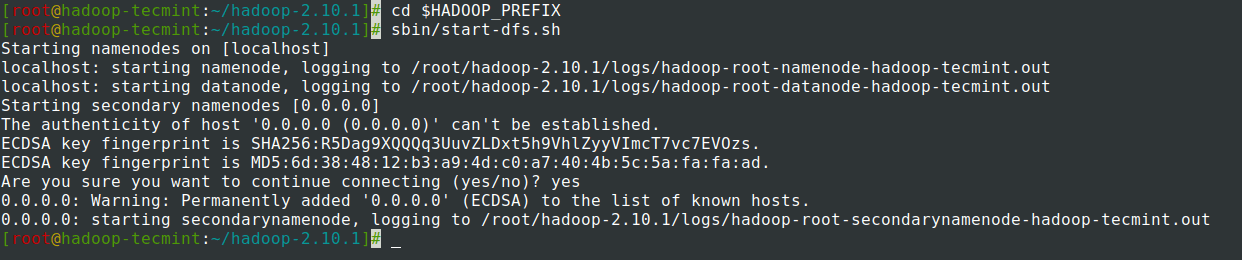

14. Début NomNœud démon et DataNode démon: (port 50070).

# cd $HADOOP_PREFIX # sbin/start-dfs.sh

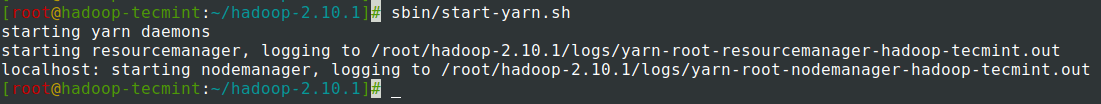

15. Début Gestionnaire de ressources démon et NodeManager démon: (port 8088).

# sbin/start-yarn.sh

16. Pour arrêter tous les services.

# sbin/stop-dfs.sh # sbin/stop-dfs.sh

Résumé

Résumé

Dans cet article, nous avons parcouru le processus étape par étape pour configurer Pseudonode Hadoop (Nœud unique) Grappe. Si vous avez une connaissance de base de Linux et suivez ces étapes, le cluster sera UP dans 40 minutes.

Cela peut être très utile pour le débutant pour commencer à apprendre et à pratiquer Hadoop ou cette version vanille de Hadoop peut être utilisé à des fins de développement. Si nous voulons avoir un cluster en temps réel, soit nous avons besoin d’au moins 3 serveurs physiques en main, soit nous devons provisionner Cloud pour avoir plusieurs serveurs.

Si vous appréciez ce que nous faisons ici sur TecMint, vous devriez considérer:

TecMint est le site communautaire à la croissance la plus rapide et le plus fiable pour tout type d’articles, de guides et de livres Linux sur le Web. Des millions de personnes visitent TecMint! pour rechercher ou parcourir les milliers d’articles publiés disponibles GRATUITEMENT à tous.

Si vous aimez ce que vous lisez, pensez à nous acheter un café (ou 2) en guise de remerciement.

Nous sommes reconnaissants pour votre soutien sans fin.

.

![10 exemples de commandes Gzip [Compress Files in Linux]](https://media.techtribune.net/uploads/2023/06/Gzip-Command-in-Linux-238x178.png)