Introduction et architecture

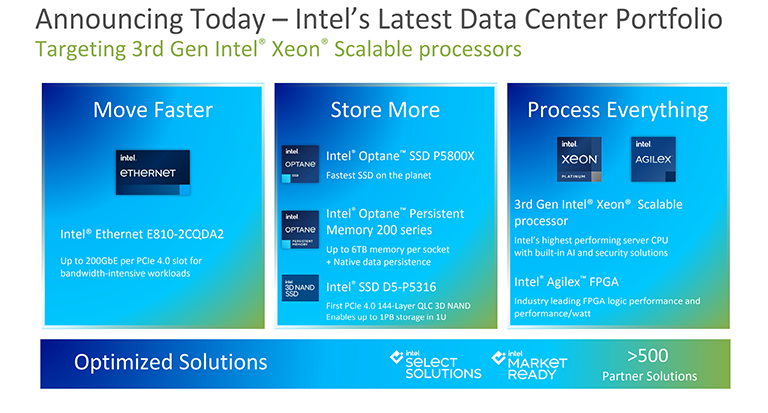

Intel annonce aujourd’hui une mise à jour significative de son portefeuille de centres de données. Construit sur les piliers du déplacement plus rapide des données, du stockage plus important et du traitement de tout, il existe de nouveaux SSD, de la mémoire Optane, de l’Ethernet, des FPGA et, bien sûr, des processeurs Xeon.

Le fait même que l’accent ne soit pas entièrement mis sur une nouvelle série de Xeons de 3e génération est révélateur en soi. Intel considère que les lancements matériels du portefeuille sont synergiques – plus que la somme des parties – et les processeurs Xeon n’ont qu’une place égale dans cette ligne de pensée.

Pourtant, Intel lance une multitude de processeurs Xeon armés d’une série d’améliorations est un gros problème dans ce segment, d’autant plus que la sortie vient juste après AMD qui lance ses processeurs Epyc de 3e génération les plus rapides à ce jour. Nous pouvons enfin comparer le meilleur d’une entreprise par rapport à l’autre.

Il est intéressant qu’Intel parle rarement des Xeons de manière isolée; tout est question de plate-forme. Cela a également du sens, car les fournisseurs ont besoin de solutions optimisées pour répondre à des besoins éclectiques, mais alors que la popularité de divers autres accélérateurs diminue et diminue, les processeurs restent le cheval de bataille de l’infrastructure du serveur.

Intel affirme avoir expédié plus de 50 millions de Xeons couvrant des marchés tels que le Cloud, la 5G, Edge, Enterprise et HPC. Il n’y a pas de Xeon unique pour cette raison même, Intel ayant des modèles spécifiquement pour les environnements de traitement multimédia, de mise en réseau et de virtualisation. Il existe des modèles utilisés dans des cartes à un, deux, quatre ou huit connecteurs, de huit cœurs à 40, des architectures de travée et des prix entre 555 $ et 13012 $. C’est résolument compliqué, mais les environnements cibles disparates le sont aussi.

À la base de ces 57 processeurs Xeon se trouve une architecture et une plate-forme communes, nous allons donc approfondir progressivement les aspects techniques des derniers Xeons de 3e génération.

Intel a publié Xeons depuis plus de 20 ans et utilise généralement une architecture commune pour les produits de serveur et de bureau (Core). Plus récemment, ce qui simplifie beaucoup, la 1ère génération Xeon Scalable est basée sur l’architecture Skylake-SP de 2017, la 2ème génération Xeon Scalable utilise une microarchitecture optimisée dérivée de Skylake connue sous le nom de Cascade Lake (2019) pour les systèmes 1-2S.

Rendant les choses alambiquées, Intel a lancé l’année dernière la première tranche de processeurs évolutifs Xeon de 3e génération. Nom de code Cooper Lake, ils ont été construits en utilisant les tripes de Cascade Lake, bien qu’avec quelques améliorations mineures, et conçus pour le marché de niche desservant les systèmes à 4 et 8 prises.

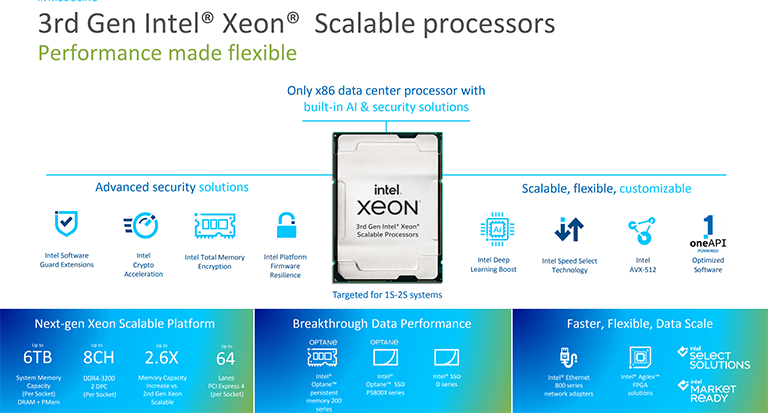

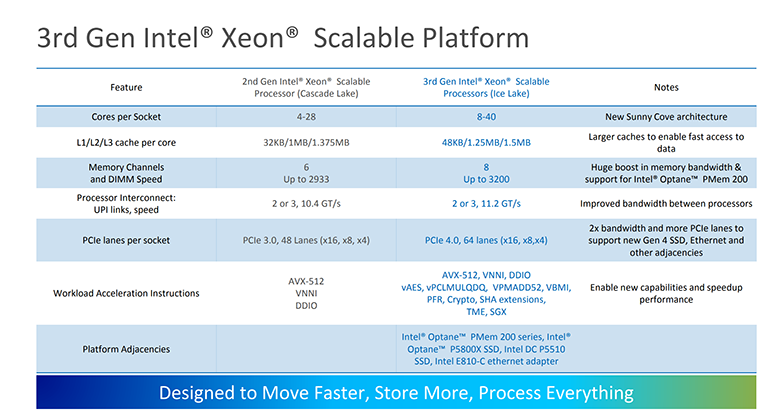

Cependant, le processeur Intel Xeon Scalable de 3e génération d’aujourd’hui n’est pas une mise à jour; c’est une refonte de l’architecture. Conçus pour les systèmes 1S-2S et utilisant le même socket physique LGA 4189 que Cooper Lake, les cœurs de processeur sont basés sur la technologie 10 nm Ice Lake tandis que la plate-forme étend l’ensemble des fonctionnalités en offrant huit canaux de mémoire DDR4-3200 compatibles AMD, plus rapidement interconnexions processeur à processeur, PCIe 4.0 et un certain nombre de nouvelles instructions bénéficiant au traitement, à la sécurité et à la cryptographie de l’IA.

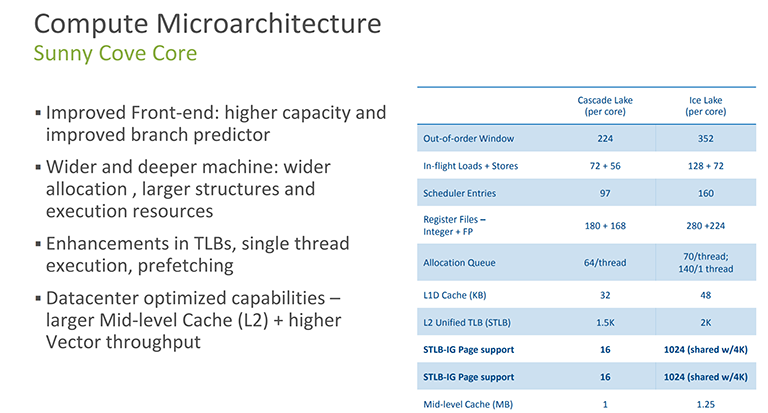

Allons un peu plus loin. Ice Lake est peut-être familier aux lecteurs car la microarchitecture a déjà fait ses débuts sur les puces mobiles et de bureau. Les cœurs de Sunny Cove se trouvent dans les processeurs de bureau 11th Gen Core de la semaine dernière, on peut donc s’attendre à une amélioration de 20% de l’IPC par rapport au cœur Skylake de base utilisé à Cascade Lake.

Cela dit, il est important de comprendre qu’Intel n’utilise pas ici sa meilleure microarchitecture. La plate-forme Tiger Lake, vue sur mobile, est supérieure car elle utilise des noyaux Willow Cove. Ils ont des caches encore plus grands, des fréquences plus élevées et une prise en charge plus rapide de la mémoire. Intel ignorera ces cœurs et passera directement aux cœurs successeurs de Golden Cove pour la prochaine itération de Xeon à venir plus tard cette année. Pourquoi? Horaire.

Ce n’est un secret pour personne que les problèmes de fabrication d’Intel ont imprégné tous les segments de l’industrie du matériel. Les Xeons basés sur Ice Lake étaient censés être disponibles il y a au moins un an, pour mieux lutter contre la menace Epyc et fournir aux clients un changement plus rapide des performances. Cette version d’avril 2021 peut être interprétée comme potentiellement problématique car elle peut se rapprocher raisonnablement de ces Xeons de nouvelle génération basés sur Sapphire Rapids et construits sur un nouveau socket. Comment convaincre les clients de gros volumes d’opter pour cette infrastructure qui n’a pas de chemin de mise à niveau évident? Pour être juste, comprenez que les décisions en matière de microarchitecture sont prises il y a des années, généralement au moins trois, de sorte que le brassage du pack par Intel relève davantage de la nécessité de la fabrication que de la réflexion sur le design.

De retour sur la bonne voie. Ce noyau de Sunny Cove n’est pas un fac-similé parfait de la version de bureau. Intel sait que les charges de travail des datacenters sont généralement différentes dans la mesure où leur empreinte de code est plus importante et a tendance à s’appuyer davantage sur l’efficacité frontale que sur les ordinateurs de bureau. Pour aider les choses, le cache L2 de l’implémentation Xeon est de 1,25 Mo par cœur, et non de 512 Ko sur le bureau de Rocket Lake, et il existe une myriade de modifications mineures qui n’apparaissent pas facilement sur une fiche technique, mais qui font une différence cumulative dans le bon environnement. En d’autres termes, une puce à huit cœurs de 11e génération Core n’est pas (exactement) la même chose qu’un Xeon à 8 cœurs. Nous irions jusqu’à dire que cela se situe entre Sunny Cove et Willow Cove dans l’ordre hiérarchique d’Intel.

Une autre distinction clé est en cours. Alors qu’Intel a rétroporté ces cœurs vers un processus de 14 nm sur le bureau, la densité de calcul par socket est beaucoup plus importante sur le serveur. C’est précisément la raison pour laquelle le Xeon Scalable de 3e génération utilise le dernier processus 10 nm et permet à Intel de pousser les capacités par socket à 40C80T, contre 28C56T sur la dernière génération. Rival AMD, bien sûr, utilise des Epycs 64C128T depuis deux générations maintenant, mais il est difficile d’ignorer le bond de 43% d’Intel cette fois-ci. Sur le papier, ces puces sont plus un jeu pour les clients qui ont avant tout besoin de performances de calcul.

Plus de cœurs, de canaux de mémoire et un IPC plus élevé sont des facteurs évidents de performances de calcul directes. Intel, cependant, tient à être considéré comme le principal adoptant de certaines technologies que, dit-il, les clients veulent vraiment. Vous vous souviendrez peut-être que nous avons déploré l’utilisation de l’AVX-512 gonflable sur l’itération de bureau. Sur le serveur, ils ont beaucoup plus de sens car les applications peuvent être réglées pour eux, et ils contribuent à propulser la cryptographie (sécurité de lecture) et les performances d’inférence de l’IA à un niveau supérieur. AVX-512 est un terme fourre-tout également appliqué à la génération précédente. Avec beaucoup plus de sous-ensembles traitant de la sécurité et de la cryptographie ici, Ice Lake offre un support plus complet que Cascade ou Cooper Lake.

L’argument supplémentaire d’amélioration de l’ISA est intéressant. AMD, qui n’a pas l’AVX-512 de cette génération, rétorquera que tout client vraiment dépendant du traitement de l’IA ou de la sécurité côté cryptographie investira dans un FPGA ou une carte d’extension dédiée à cette tâche, permettant le déchargement du processeur et sans doute de meilleures performances. . Intel, d’autre part, affirme que le fait d’avoir ces instructions d’accélération spécifiques dans ses derniers Xeons leur permet d’être plus qu’un poney de calcul à l’ancienne et présente un autre moyen pour les entreprises d’améliorer la métrique TCO si elles tirent parti d’une capacité autrement sous-utilisée – des fonctionnalités implémentées via analyse des charges de travail émergentes et des retours clients.

Actuellement disponible sur les processeurs Xeon E, Intel propose également des extensions SGX (Software Guard Extensions) à cette famille. Il fonctionne en utilisant un cryptage de mémoire matériel qui isole le code d’application spécifique et les données en mémoire, dans la veine de la virtualisation sécurisée (SEV) d’AMD, bien que si les performances passées sont quelque chose à dire, la surcharge de performances sur Intel est plus grande que sur AMD. La taille de la partie de la mémoire protégée par SGX diffère d’un modèle à l’autre et est appelée enclave.