Développement et déploiement vision IA Les applications sont complexes et coûteuses. Les organisations ont besoin Scientifiques des données et Ingénieurs en apprentissage automatique pour créer des pipelines de formation et d’inférence basés sur des données non structurées telles que des images et des vidéos. Avec la pénurie aiguë d’ingénieurs qualifiés en apprentissage automatique, la création et l’intégration d’applications d’IA de vision intelligente sont devenues coûteuses pour les entreprises.

D’autre part, des entreprises telles que Google, Intel, Meta, Microsoft, NVIDIA et OpenAI mettent des modèles pré-entraînés à la disposition des clients. Des modèles pré-entraînés tels que la détection des visages, la détection des émotions, la détection des poses et la détection des véhicules sont librement disponibles pour les développeurs afin de créer des applications intelligentes basées sur la vision. De nombreuses organisations ont investi dans la vidéosurveillance, la surveillance et les caméras IP pour la sécurité. Bien que ces caméras puissent être connectées à des modèles pré-entraînés existants, la plomberie nécessaire pour relier les points est beaucoup trop complexe.

Création de pipelines d’inférence d’IA de vision

La création d’un pipeline d’inférence d’IA de vision pour obtenir des informations à partir de caméras existantes et de modèles pré-entraînés ou de modèles personnalisés implique le traitement, l’encodage et la normalisation des flux vidéo alignés sur le modèle cible. Une fois que cela est en place, le résultat de l’inférence doit être capturé avec les métadonnées pour fournir des informations via des tableaux de bord visuels et des analyses.

Pour les fournisseurs de plates-formes, le pipeline d’inférence d’IA de vision offre l’opportunité de créer des outils et des environnements de développement pour relier les points entre les sources vidéo, les modèles et le moteur d’analyse. Si l’environnement de développement fournit un no-code/low-code , il accélère et simplifie encore le processus.

L’IDG

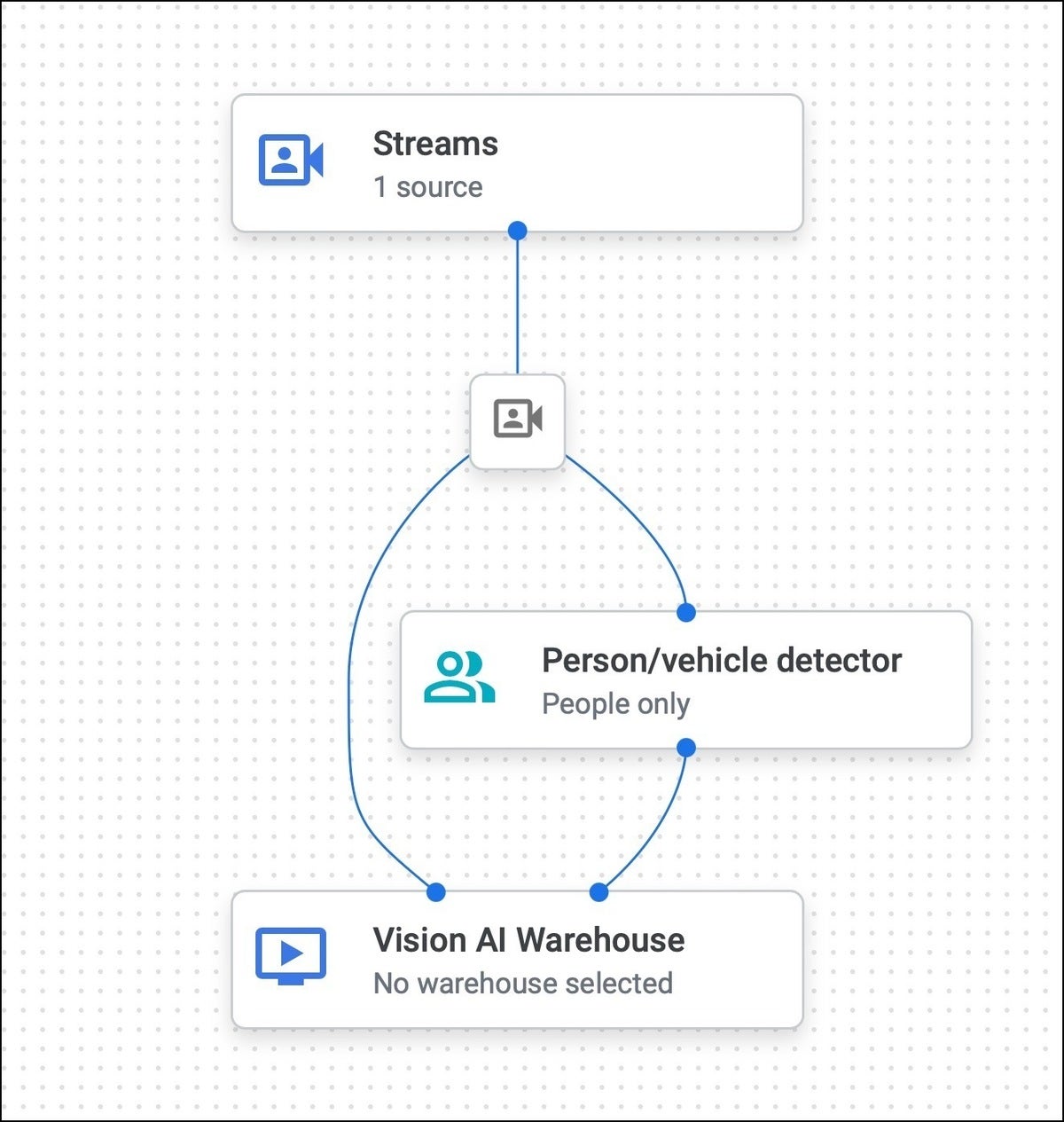

L’IDGGraphique 1. Création d’un pipeline d’inférence AI Vision avec Vertex AI Vision.

À propos de Vertex AI Vision

Google Vision de l’IA de Vertex permet aux organisations d’intégrer de manière transparente l’IA de vision par ordinateur dans les applications sans la plomberie et le levage lourd. Il s’agit d’un environnement intégré qui combine des sources vidéo, des modèles d’apprentissage automatique et des entrepôts de données pour fournir des informations et des analyses riches. Les clients peuvent soit utiliser des modèles pré-entraînés disponibles dans l’environnement, soit apporter des modèles personnalisés formés dans le Vertex AI plateforme.

L’IDG

L’IDGGraphique 2. Il est possible d’utiliser des modèles pré-entraînés ou des modèles personnalisés formés dans la plateforme Vertex AI.

Une application Vertex AI Vision démarre avec une zone vierge, qui est utilisée pour créer un pipeline d’inférence de vision IA en faisant glisser et en déposant des composants à partir d’une palette visuelle.

L’IDG

L’IDGGraphique 3. Création d’un pipeline avec des composants glisser-déposer.

La palette contient divers connecteurs qui incluent les flux caméra/vidéo, une collection de modèles préentraînés, des modèles spécialisés ciblant des secteurs verticaux spécifiques, des modèles personnalisés construits à l’aide d’AutoML ou de Vertex AI et des magasins de données sous la forme de BigQuery et AI Vision Warehouse.

Selon Google Cloud, Vertex AI Vision dispose des services suivants:

- Flux de vision Vertex AI: service de point de terminaison permettant d’ingérer des flux vidéo et des images sur un réseau géographiquement distribué. Connectez n’importe quelle caméra ou appareil de n’importe où et laissez Google gérer la mise à l’échelle et l’ingestion.

- Vertex AI Vision Applications: les développeurs peuvent créer des pipelines de traitement et d’analyse multimédias étendus et mis à l’échelle automatique à l’aide de cette plate-forme d’orchestration sans serveur.

- Modèles de vision Vertex AI: modèles de vision prédéfinis pour les tâches d’analyse courantes, notamment le comptage du taux d’occupation, la détection des EPI, le floutage des visages et la reconnaissance des produits de vente au détail. De plus, les utilisateurs peuvent créer et déployer leurs propres modèles formés au sein de la plateforme Vertex AI.

- Entrepôt Vertex AI Vision: un système intégré de stockage multimédia enrichi sans serveur qui combine la recherche Google et le stockage vidéo géré. Des pétaoctets de données vidéo peuvent être ingérés, stockés et recherchés dans l’entrepôt.

Par exemple, le pipeline ci-dessous ingère la vidéo à partir d’une source unique, la transmet au compteur de personnes/véhicules et stocke les métadonnées d’entrée et de sortie (inférence) dans AI Vision Warehouse pour exécuter des requêtes simples. Il peut être remplacé par BigQuery pour s’intégrer à des applications existantes ou effectuer des requêtes SQL complexes.

L’IDG

L’IDGGraphique 4. Un exemple de pipeline construit avec Vertex AI Vision.

Déploiement d’un pipeline Vertex AI Vision

Une fois que le pipeline est bUILT visuellement, il peut être déployé pour commencer à effectuer l’inférence. Les coches vertes dans la capture d’écran ci-dessous indiquent un déploiement réussi.

L’IDG

L’IDGGraphique 5. Les graduations vertes indiquent que le pipeline a été déployé.

L’étape suivante consiste à commencer à ingérer le flux vidéo pour déclencher l’inférence. Google fournit un outil de ligne de commande appelé vaictl pour récupérer le flux vidéo à partir d’une source et le transmettre au point de terminaison Vertex AI Vision. Il prend en charge les fichiers vidéo statiques et les flux RTSP basés sur l’encodage H.264.

Une fois le pipeline déclenché, les flux d’entrée et de sortie peuvent être surveillés à partir de la console, comme illustré.

L’IDG

L’IDGGraphique 6. Surveillance des flux d’entrée et de sortie à partir de la console.

Étant donné que la sortie d’inférence est stockée dans AI Vision Warehouse, elle peut être interrogée en fonction d’un critère de recherche. Par exemple, la capture d’écran suivante montre des images contenant au moins cinq personnes ou véhicules.

L’IDG

L’IDGGraphique 7. Exemple de requête pour la sortie d’inférence.

Google fournit un SDK pour communiquer par programmation avec l’entrepôt. Les développeurs BigQuery peuvent utiliser les bibliothèques existantes pour exécuter des requêtes avancées basées sur ANSI SQL.

Intégrations et prise en charge de Vertex AI Vision à la périphérie

Vertex AI Vision a une intégration étroite avec Vertex AI, le PaaS d’apprentissage automatique géré de Google. Les clients peuvent former des modèles via AutoML ou une formation personnalisée. Pour ajouter un traitement personnalisé de la sortie, Google a intégré Cloud Functions, qui peut manipuler la sortie pour ajouter des annotations ou des métadonnées supplémentaires.

Le véritable potentiel de la plate-forme Vertex AI Vision réside dans son approche sans code et sa capacité à s’intégrer à d’autres services Google Cloud tels que BigQuery, Cloud Functions et Vertex AI.

Bien que Vertex AI Vision soit une excellente étape vers la simplification de la vision AI, un support supplémentaire est nécessaire pour déployer des applications à la périphérie. Les secteurs verticaux tels que les soins de santé, l’assurance et l’automobile préfèrent exécuter des pipelines d’IA de vision à la périphérie pour éviter la latence et respecter la conformité. L’ajout de la prise en charge de la périphérie deviendra un facteur clé pour Vertex AI Vision.

Droits d’auteur © 2022 IDG Communications, Inc.