Lors de l’I/O 2023 la semaine dernière, Google a annoncé une nouvelle version de Project Starline et a permis à davantage de personnes de l’essayer. Nous avons eu la chance de découvrir la technologie de vidéoconférence immersive, tandis que MKBHD a pu enregistrer une bonne approximation de ce que c’est que d’utiliser Project Starline.

L’original contre le nouveau projet Starline

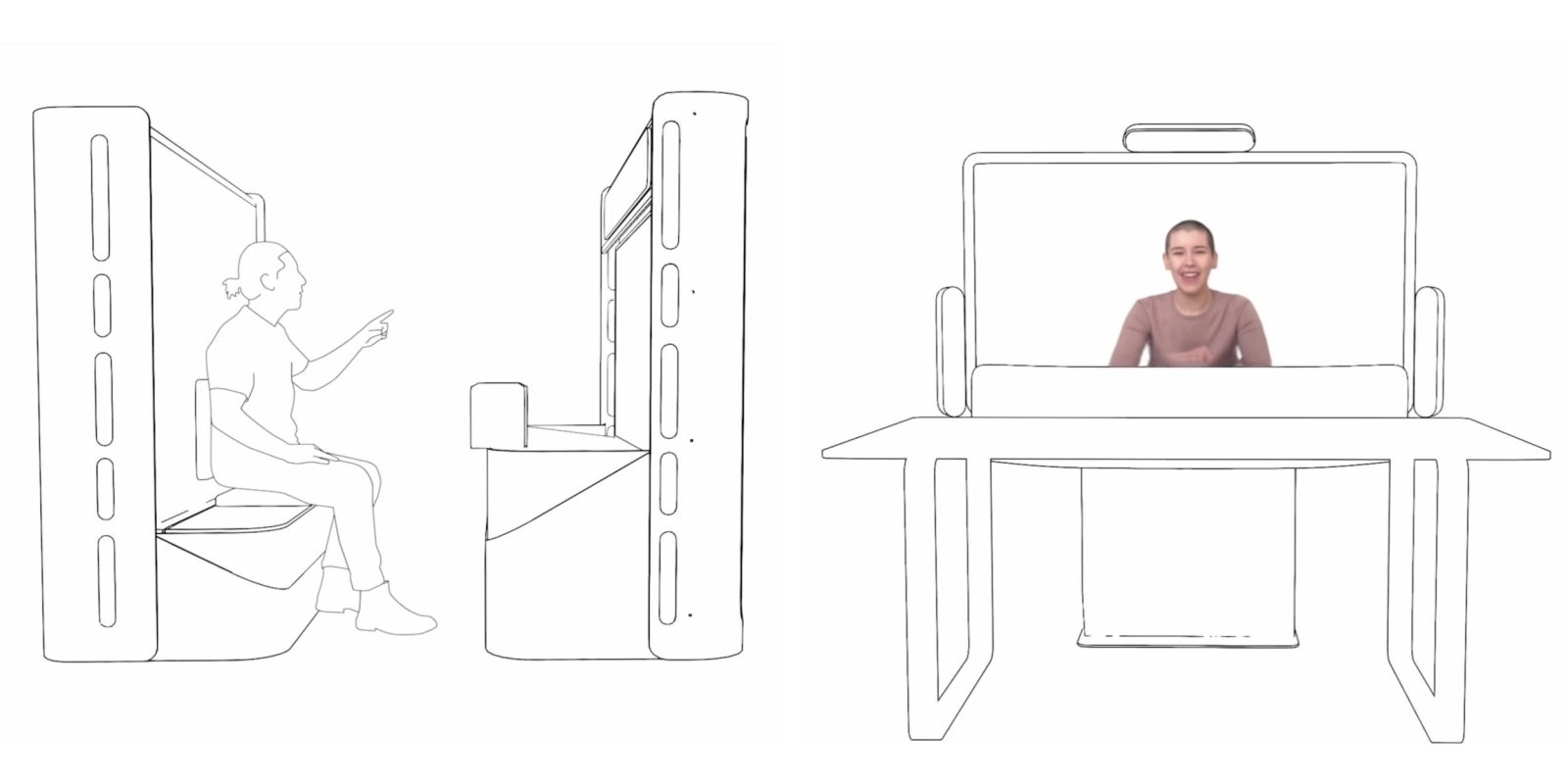

Les premiers prototypes du projet Starline étaient logés dans ce qui était essentiellement une cabine avec deux composants principaux. L' »unité d’affichage » comprenait un panneau de 65 pouces 8K (60 Hz), des haut-parleurs, des microphones, des éclairages et un ordinateur, ainsi que plusieurs ensembles de caméras :

- Quatre caméras de suivi du visage à fréquence d’images élevée (120FPS) pour « estimer l’emplacement 3D des yeux, des oreilles et de la bouche avec une précision d’environ cinq millimètres ».

- Trois groupes de modules de caméra pour la vidéo 3D. Chacun contient deux caméras infrarouges et une caméra couleur, tandis que le module inférieur contient une autre caméra couleur zoomée sur le visage.

L’« unité de rétroéclairage » se composait du banc et du rétroéclairage infrarouge. Quatre GPU NVIDIA (deux Quadro RTX 6000 et deux Titan RTX) ont été utilisés pour compresser quatre flux de couleurs et trois flux de profondeur. Tout a été transmis sur WebRTC avec Project Starline combinant le travail de Google dans l’imagerie 3D, la compression en temps réel, l’audio spatial et les affichages de champ lumineux.

Cette configuration est évidemment coûteuse et techniquement intensive, Google notant la semaine dernière à quel point « la taille et la complexité du système rendaient difficile son installation dans de nombreux bureaux d’aujourd’hui ».

Le nouveau prototype Project Starline ressemble plus à un tableau blanc numérique avec un protège-profondeur (en quelque sorte) devant l’écran, ainsi qu’une table fixe. Notamment, seul un «quelques caméras standard» disposés en haut, à gauche et à droite de l’écran et l’IA sont utilisés pour créer une carte de profondeur.

Projet Starline pratique

Depuis que Project Starline a été annoncé à I/O 2021, les gens ont été ravis de l’apparence réaliste et tridimensionnelle des personnes devant eux. Depuis lors, Google a lentement élargi l’accès aux sociétés tierces.

En utilisant Starline la semaine dernière, il y a définitivement une sensation de profondeur inattendue. La personne devant vous n’est pas plate et j’ai immédiatement regardé à gauche et à droite pour vérifier.

Cependant, je ne dirais pas non plus qu’ils sont entièrement en 3D. Il y a une limite à leur profondeur qui, pour moi, était évidente après la surprise et l’émerveillement initiaux. J’avais l’impression que la personne que je regardais était une découpe en carton de 1 à 2 pouces d’épaisseur plutôt qu’une tête et un corps entiers. C’était la même chose lorsque mon partenaire de démonstration a tendu une pomme devant moi.

Pour une raison quelconque, l’effet 3D était bien meilleur lorsque j’ai retiré mes lunettes. Avec eux, l’effet 3D se sentait localisé dans mes images et ressemblait quelque peu à regarder un film 3D dans une configuration de théâtre sophistiquée.

En attendant, je souhaite que la personne 3D soit beaucoup plus partageuse. Je pouvais voir les pixels de la même manière que je trouve la résolution de 1800 × 1920 par œil du Méta Quête Pro ne pas être assez pointu.

Compte tenu de ma brève utilisation, je vois Starline comme un plus/un complément à l’expérience d’appel vidéo. Il y a une nouveauté à ajouter une certaine profondeur réelle que je pourrais voir vouloir toujours avoir au fil du temps.

Alors que la personne devant moi avait de la profondeur, l’une des choses que j’ai trouvées les plus surprenantes a été de regarder la transition entre le bord de l’écran Starline et le mur derrière l’écran. La fenêtre Starline ressemblait vraiment à un portail vers un autre monde que je voulais littéralement traverser. J’ai trouvé cela extrêmement amusant.

Démo Starline de MKBHD

Compte tenu du suivi impliqué, Starline est très difficile à démontrer virtuellement. Vous devez en faire l’expérience en personne pour obtenir le plein effet. Cependant, Marques Brownlee et son équipe ont eu l’idée de reproduire l’expérience dans une vidéo :

Vous voyez, en gros, une fois que vous vous êtes assis pour la première fois dans le stand Project Starline, ce système doit identifier où se trouve votre visage, puis vous pouvez vous déplacer et regarder des choses avec le suivi de la tête et du corps. Et bien sûr, cela ne fonctionnera pas si vous mettez simplement une caméra là-dedans. Mais si vous lui montrez un visage et un appareil photo en même temps, comme par exemple un visage en carton où vous pouvez coller un objectif d’appareil photo d’une manière ou d’une autre à travers ce visage en carton, alors cela suivra et vous pourrez voir de quoi je parle.