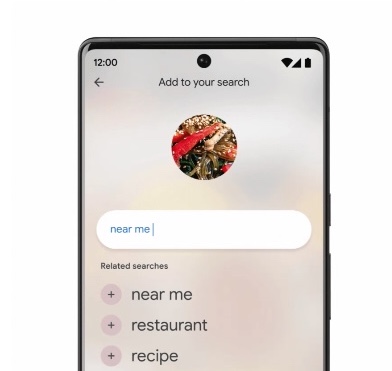

En avril, Google a introduit une nouvelle fonctionnalité « multisearch » qui offrait un moyen de rechercher sur le Web en utilisant à la fois du texte et des images. Aujourd’hui, lors de la conférence des développeurs d’E/S de Google, la société a annoncé une extension de cette fonctionnalité, appelée « Multisearch Near Me ». Cet ajout, qui arrivera plus tard en 2022, permettra aux utilisateurs de l’application Google de combiner une image ou une capture d’écran avec le texte « près de chez moi » pour être dirigé vers les options pour les détaillants locaux ou les restaurants qui auraient les vêtements, les articles ménagers ou les aliments que vous recherchez. Il annonce également un développement à venir pour la recherche multiple qui semble être construit avec des lunettes AR à l’esprit, car il peut rechercher visuellement plusieurs objets dans une scène en fonction de ce que vous « voyez » actuellement via le viseur d’un appareil photo de smartphone.

Avec la nouvelle requête multirecherche « près de chez moi », vous serez en mesure de trouver des options locales liées à votre combinaison de recherche visuelle et textuelle actuelle. Par exemple, si vous travailliez sur un projet de bricolage et que vous tombiez sur une pièce que vous deviez remplacer, vous pouvez prendre une photo de la pièce avec l’appareil photo de votre téléphone pour l’identifier, puis trouver une quincaillerie locale qui a un remplacement en stock.

Ce n’est pas si différent de la façon dont la recherche multiple fonctionne déjà, explique Google – il s’agit simplement d’ajouter le composant local.

Crédits d’image: Google (en anglais seulement

À l’origine, l’idée avec la recherche multiple était de permettre aux utilisateurs de poser des questions sur un objet devant eux et d’affiner ces résultats par couleur, marque ou autres attributs visuels. La fonctionnalité fonctionne aujourd’hui mieux avec les recherches d’achats, car elle permet aux utilisateurs de réduire les recherches de produits d’une manière que les recherches Web textuelles standard pourraient parfois avoir du mal à gérer. Par exemple, un utilisateur pourrait prendre une photo d’une paire de baskets, puis ajouter du texte pour demander à les voir en bleu pour qu’on leur montre uniquement les chaussures de la couleur spécifiée. Ils pouvaient choisir de visiter le site Web pour les baskets et de les acheter immédiatement. L’extension pour inclure l’option « près de chez moi » limite maintenant simplement les résultats afin de diriger les utilisateurs vers un détaillant local où le produit donné est disponible.

En termes d’aide aux utilisateurs pour trouver des restaurants locaux, la fonctionnalité fonctionne de la même manière. Dans ce cas, un utilisateur pourrait effectuer une recherche en fonction d’une photo qu’il a trouvée sur un blog culinaire ou ailleurs sur le Web pour savoir quel est le plat et quels restaurants locaux pourraient avoir l’option sur leur menu pour dîner, ramasser ou livrer. Ici, google search combine l’image avec l’intention que vous êtes à la recherche d’un restaurant à proximité et numérisera des millions d’images, d’avis et de contributions de la communauté à Google Maps pour trouver l’endroit local.

La nouvelle fonctionnalité « près de chez moi » sera disponible dans le monde entier en anglais et sera déployée dans plus de langues au fil du temps, a déclaré Google.

L’ajout le plus intéressant à la recherche multiple est la possibilité de rechercher dans une scène. À l’avenir, Google affirme que les utilisateurs pourront faire un panoramique de leur appareil photo pour en savoir plus sur plusieurs objets dans cette scène plus large.

Google suggère que la fonctionnalité pourrait être utilisée pour scanner les étagères d’une librairie, puis voir plusieurs informations utiles superposées devant vous.

Crédits d’image: Google (en anglais seulement

« Pour rendre cela possible, nous rassemblons non seulement la vision par ordinateur, la compréhension du langage naturel, mais nous combinons également cela avec la connaissance du Web et de la technologie sur l’appareil », a déclaré Nick Bell, directeur principal de Google Search. « Donc, les possibilités et les capacités de cela vont être énormes et significatives », a-t-il noté.

La société – qui est arrivée sur le marché de la RA tôt avec sa sortie google glass – n’a pas confirmé qu’elle avait une sorte de nouvel appareil de type lunettes AR en préparation, mais a fait allusion à la possibilité.

« Avec les systèmes d’IA maintenant, ce qui est possible aujourd’hui – et qui le sera au cours des prochaines années – ouvre en quelque sorte de nombreuses opportunités », a déclaré Bell. En plus de la recherche vocale, de la recherche sur ordinateur et sur mobile, la société estime que la recherche visuelle sera également une plus grande partie de l’avenir, a-t-il noté.

« Il y a 8 milliards de recherches visuelles sur Google avec Lens chaque mois maintenant et ce nombre est trois fois plus grand qu’il y a seulement un an », a poursuivi Bell. « Ce que nous voyons certainement de la part des gens, c’est que l’appétit et le désir de chercher visuellement sont là. Et ce que nous essayons de faire maintenant, c’est de nous pencher sur les cas d’utilisation et d’identifier où cela est le plus utile », a-t-il déclaré. « Je pense que lorsque nous réfléchissons à l’avenir de la recherche, la recherche visuelle est certainement un élément clé de cela. »

L’entreprise, bien sûr, est supposément travailler sur un projet secret, nom de code Project Iris, pour construire un nouveau casque AR with une date de sortie prévue pour 2024. Il est facile d’imaginer non seulement comment cette capacité de numérisation de scène pourrait fonctionner sur un tel appareil, mais aussi comment toute sorte de fonction de recherche image-plus-texte (ou voix!) pourrait être utilisée sur un casque AR. Imaginez à nouveau regarder la paire de baskets que vous avez aimée, par exemple, puis demander à un appareil de se rendre au magasin le plus proche que vous pourriez faire l’achat.

« En regardant plus loin, cette technologie pourrait être utilisée au-delà des besoins quotidiens pour aider à relever les défis sociétaux, comme aider les défenseurs de l’environnement à identifier les espèces végétales qui ont besoin de protection, ou aider les travailleurs humanitaires en cas de catastrophe à trier rapidement les dons en cas de besoin », a suggéré Prabhakar Raghavan, vice-président directeur de google search, s’exprimant sur scène à Google I / O.

Malheureusement, Google n’a pas offert de calendrier pour le moment où il s’attendait à mettre la capacité de numérisation de scène entre les mains des utilisateurs, car la fonctionnalité est encore « en développement ».