Nvidia a annoncé aujourd’hui que ses nouveaux GPU de centre de données basés sur Ampère, les GPU A100 Tensor Core, sont désormais disponibles en alpha sur Google Cloud. Comme son nom l’indique, ces GPU ont été conçus pour les charges de travail de l’IA, ainsi que pour l’analyse de données et les solutions informatiques hautes performances.

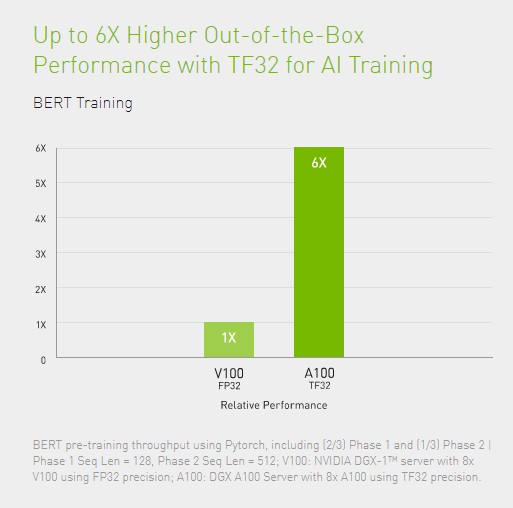

L’A100 promet une amélioration significative des performances par rapport aux générations précédentes. Nvidia dit que l’A100 peut augmenter les performances de formation et d’inférence de plus de 20 fois par rapport à ses prédécesseurs (bien que vous verrez principalement des améliorations de 6 ou 7 fois dans la plupart des benchmarks) et atteint environ 19,5 TFLOP en performances en simple précision et 156 TFLOP pour le flotteur tenseur. 32 charges de travail.

« Les clients de Google Cloud se tournent souvent vers nous pour fournir les derniers services matériels et logiciels afin de les aider à stimuler l’innovation sur l’IA et les charges de travail de calcul scientifique », a déclaré Manish Sainani, directeur de la gestion des produits chez Google Cloud, dans l’annonce d’aujourd’hui. «Avec notre nouvelle famille A2 VM, nous sommes fiers d’être le premier grand fournisseur de cloud à commercialiser Nvidia GPU A100, comme nous l’étions Nvidiades GPU T4. Nous sommes ravis de voir ce que nos clients feront de ces nouvelles capacités. »

Les utilisateurs de Google Cloud peuvent accéder à des instances avec jusqu’à 16 de ces GPU A100, pour un total de 640 Go de mémoire GPU et 1,3 To de mémoire système.