![]()

L’amélioration des photos dans les films et les émissions de télévision est souvent ridiculisé pour être incroyable, mais la recherche en réel retouche photo est se glissant de plus en plus dans le domaine de la science-fiction. Il suffit de jeter un œil à la dernière technologie de mise à l’échelle des photos par IA de Google.

Dans un article intitulé « Génération d’images haute fidélité à l’aide de modèles de diffusion» publié sur le blog Google AI (et repéré par RMR), les chercheurs de Google dans le Équipe du cerveau partager sur les nouvelles percées qu’ils ont faites en super-résolution d’image.

En super-résolution d’image, un modèle d’apprentissage automatique est formé pour transformer une photo basse résolution en une photo haute résolution détaillée, et les applications potentielles de cette gamme allant de la restauration d’anciennes photos de famille à l’amélioration de l’imagerie médicale.

Google a exploré un concept appelé « modèles de diffusion », qui a été proposé pour la première fois en 2015, mais qui, jusqu’à récemment, a pris le pas sur une famille de méthodes d’apprentissage en profondeur appelées « modèles génératifs profonds ». La société a constaté que ses résultats avec cette nouvelle approche surpassaient les technologies existantes lorsque les humains sont invités à juger.

La première approche s’appelle SR3, ou Super-Résolution via un raffinement répété. Voici l’explication technique :

« SR3 est un modèle de diffusion à super résolution qui prend en entrée une image basse résolution et crée une image haute résolution correspondante à partir de bruit pur », écrit Google. « Le modèle est entraîné sur un processus de corruption d’image dans lequel du bruit est progressivement ajouté à une image haute résolution jusqu’à ce qu’il ne reste plus que du bruit pur.

« Il apprend ensuite à inverser ce processus, en commençant par le bruit pur et en supprimant progressivement le bruit pour atteindre une distribution cible grâce au guidage de l’image basse résolution d’entrée. »

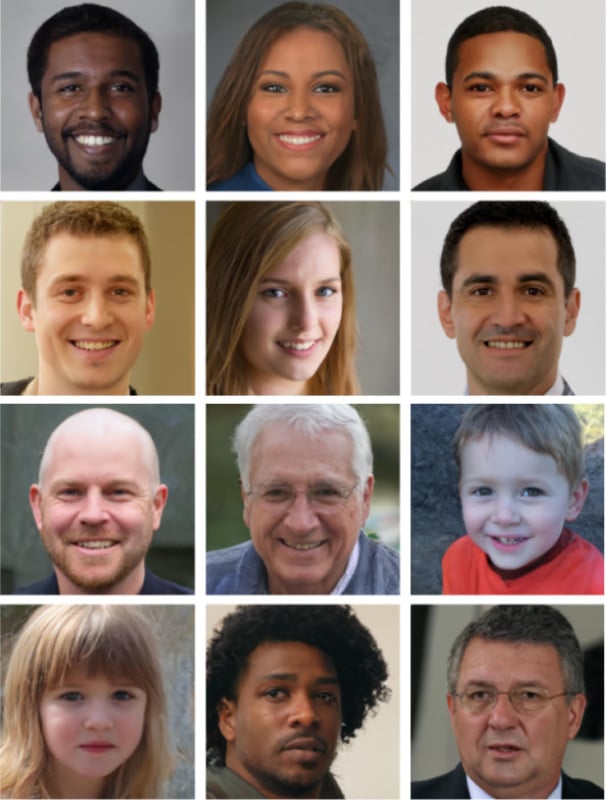

SR3 s’est avéré efficace pour la mise à l’échelle des portraits et des images naturelles. Lorsqu’il est utilisé pour effectuer une mise à l’échelle 8x sur les visages, il a un « taux de confusion » de près de 50 % alors que les méthodes existantes n’atteignent que 34 %, ce qui suggère que les résultats sont en effet photo-réalistes.

Voici d’autres portraits agrandis à partir d’originaux basse résolution :

Une fois que Google a vu à quel point SR3 était efficace dans la mise à l’échelle des photos, la société est allée plus loin avec une deuxième approche appelée MDP, un modèle de diffusion conditionnelle aux classes.

« CDM est un modèle de diffusion conditionnelle de classe formé sur des données ImageNet pour générer des images naturelles à haute résolution », écrit Google. « Étant donné qu’ImageNet est un jeu de données difficile à entropie élevée, nous avons construit le CDM sous la forme d’une cascade de modèles de diffusion multiples. Cette approche en cascade consiste à enchaîner plusieurs modèles génératifs sur plusieurs résolutions spatiales : un modèle de diffusion qui génère des données à basse résolution, suivi d’une séquence de modèles de diffusion à super-résolution SR3 qui augmentent progressivement la résolution de l’image générée jusqu’à la résolution la plus élevée. «

![]()

Google a publié un ensemble d’exemples montrant des photos basse résolution agrandies en cascade. Une photo 32×32 peut être améliorée en 64×64 puis en 256×256. Une photo 64×64 peut être agrandie en 256×256 puis 1024×1024.

![]()

![]()

![]()

Comme vous pouvez le voir, les résultats sont impressionnants et les photos finales, malgré quelques erreurs (telles que des lacunes dans les montures de lunettes), passeraient probablement à première vue comme de véritables photographies originales pour la plupart des téléspectateurs.

« Avec SR3 et CDM, nous avons poussé les performances des modèles de diffusion à l’état de l’art sur les benchmarks de génération ImageNet de super-résolution et de classe conditionnelle », écrivent les chercheurs de Google. « Nous sommes ravis de tester davantage les limites des modèles de diffusion pour une grande variété de problèmes de modélisation générative. »