Google a annoncé une recherche révolutionnaire dans le traitement du langage naturel appelée Chain of Thought Prompting qui élève l’état de l’art des technologies avancées comme PaLM et LaMDA à ce que les chercheurs appellent un niveau remarquable.

Le fait que Chain of Thought Prompting puisse améliorer PaLM et LaMDA à ces taux importants est un gros problème.

LaMDA et PaLM

La recherche a mené des expériences en utilisant deux modèles de langage, Language Model for Dialogue Applications (LaMDA) et Pathways Language Model (PaLM).

LaMDA est un modèle axé sur la conversation, comme un chatbot, mais peut également être utilisé pour de nombreuses autres applications qui nécessitent de parler, de dialoguer.

PaLM est un modèle qui suit ce que Google appelle l’architecture Pathways AI où un modèle de langage est formé pour apprendre à résoudre des problèmes.

Auparavant, les modèles d’apprentissage automatique étaient formés pour résoudre un type de problème et ils étaient essentiellement lâchés pour faire cette chose vraiment bien. Mais pour faire autre chose, Google devrait former un nouveau modèle.

L’architecture Pathways AI est un moyen de créer un modèle capable de résoudre des problèmes qu’il n’a pas nécessairement vus auparavant.

Tel que cité dans le Google PaLM explicatif :

« … nous aimerions former un modèle capable non seulement de gérer de nombreuses tâches distinctes, mais aussi de tirer parti de ses compétences existantes et de les combiner pour apprendre de nouvelles tâches plus rapidement et plus efficacement.

Ce qu’il fait

Le document de recherche énumère trois percées importantes pour le raisonnement en chaîne de pensée:

- Il permet aux modèles de langage de décomposer des problèmes complexes en plusieurs étapes en une séquence d’étapes

- La chaîne du processus de pensée permet aux ingénieurs de jeter un coup d’œil dans le processus et lorsque les choses tournent mal, cela leur permet d’identifier où cela s’est mal passé et de le réparer.

- Peut résoudre des problèmes de mots mathématiques, peut accomplir un raisonnement de bon sens et, selon le document de recherche, peut (en principe) résoudre n’importe quel problème basé sur des mots qu’un humain peut.

Tâches de raisonnement en plusieurs étapes

La recherche donne un exemple de tâche de raisonnement en plusieurs étapes sur laquelle les modèles de langage sont testés :

Q: La cafétéria avait 23 pommes. S’ils en ont utilisé 20 pour préparer le déjeuner et en ont acheté 6 de plus, combien de pommes ont-ils?

R : La cafétéria avait 23 pommes à l’origine. Ils en ont utilisé 20 pour préparer le déjeuner. Ils avaient donc 23 – 20 = 3. Ils ont acheté 6 pommes de plus, donc ils ont 3 + 6 = 9. La réponse est 9. »

PaLM est un modèle de langage de pointe qui fait partie de l’architecture Pathways AI. Il est si avancé qu’il peut expliquer pourquoi une blague est drôle.

Pourtant, aussi avancé que soit le PaLM, les chercheurs affirment que la Chaîne de Pensée Incite améliore considérablement ces modèles, et c’est ce qui rend cette nouvelle recherche si digne d’être prise en compte.

Google l’explique comme ceci:

« Le raisonnement en chaîne de pensée permet aux modèles de décomposer des problèmes complexes en étapes intermédiaires qui sont résolues individuellement.

De plus, la nature linguistique de la chaîne de pensée la rend applicable à toute tâche qu’une personne pourrait résoudre via le langage.

Le document de recherche poursuit en notant que l’incitation standard ne s’améliore pas vraiment lorsque l’échelle du modèle est augmentée.

Cependant, avec cette nouvelle approche, l’échelle a un impact positif significatif et notable sur la performance du modèle.

Résultats

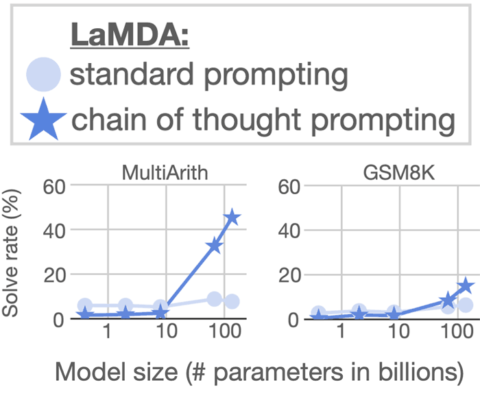

Chain of Thought Prompting a été testé sur LaMDA et PaLM, en utilisant deux ensembles de données de problèmes de mots mathématiques.

Ces ensembles de données sont utilisés par les chercheurs comme un moyen de comparer les résultats sur des problèmes similaires pour différents modèles linguistiques.

Vous trouverez ci-dessous des images de graphiques montrant les résultats de l’utilisation de Chain of Thought Prompting sur LaMDA.

Les résultats de la mise à l’échelle de LaMDA sur l’ensemble de données MultiArith montrent qu’il en a résulté une amélioration modeste. Mais LaMDA obtient des scores significativement plus élevés lorsqu’il est mis à l’échelle avec Chain of Thought Prompting.

Les résultats sur l’ensemble de données GSM8K montrent une amélioration modeste.

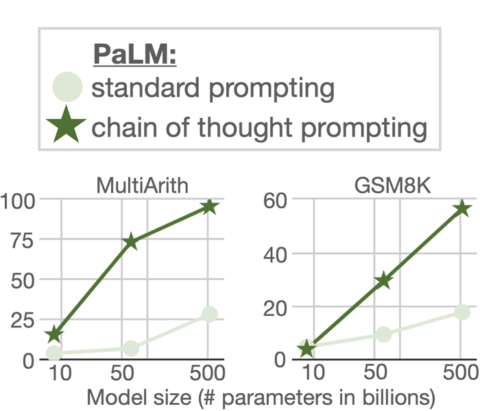

C’est une autre histoire avec le modèle de langage PaLM.

Comme on peut le voir dans le graphique ci-dessus, les gains de la mise à l’échelle de PaLM avec Chain of Thought Prompting sont énormes, et ils sont énormes pour les deux ensembles de données (MultiArith et GSM8K).

Les chercheurs qualifient les résultats de remarquables et d’un nouvel état de l’art:

« Sur l’ensemble de données GSM8K des problèmes de mots mathématiques, PaLM montre des performances remarquables lorsqu’il est mis à l’échelle à des paramètres 540B.

… combinaison de la chaîne de thSi l’incitation avec le modèle PaLM du paramètre 540B conduit à de nouvelles performances de pointe de 58%, dépassant l’état de l’art précédent de 55% obtenu en ajustant GPT-3 175B sur un grand ensemble d’entraînement, puis en classant les solutions potentielles via un vérificateur spécialement formé.

De plus, les travaux de suivi sur l’auto-cohérence montrent que la performance de l’incitation à la chaîne de pensée peut être encore améliorée en prenant le vote majoritaire d’un large ensemble de processus de raisonnement générés, ce qui se traduit par une précision de 74% sur GSM8K.

Conclusions

La conclusion d’un document de recherche est l’une des parties les plus importantes pour vérifier si la recherche fait progresser l’état de l’art ou est une impasse ou nécessite plus de recherche.

La section de conclusion du document de recherche de Google a une note fortement positive.

Il note :

« Nous avons exploré l’incitation à la chaîne de pensée comme une méthode simple et largement applicable pour améliorer le raisonnement dans les modèles linguistiques.

Grâce à des expériences sur le raisonnement arithmétique, symbolique et de bon sens, nous constatons que le traitement de la chaîne de pensée est une propriété émergente de l’échelle du modèle qui permet à des modèles de langage suffisamment grands d’effectuer des tâches de raisonnement qui ont autrement des courbes d’échelle plates.

L’élargissement de l’éventail des tâches de raisonnement que les modèles de langage peuvent effectuer inspirera, espérons-le, d’autres travaux sur les approches du raisonnement basées sur le langage.

Cela signifie que Chain of Thought Prompting peut avoir le potentiel de fournir à Google la possibilité d’améliorer considérablement ses différents modèles linguistiques, ce qui peut à son tour conduire à des améliorations significatives dans le genre de choses que Google peut faire.

Références

Lire l’article Google AI

Les modèles de langage effectuent le raisonnement via la chaîne de pensée

Télécharger et lire le document de recherche

La chaîne de pensée suscite le raisonnement dans les grands modèles linguistiques (PDF) (en anglais seulement)

!function(f,b,e,v,n,t,s) {if(f.fbq)return;n=f.fbq=function(){n.callMethod? n.callMethod.apply(n,arguments):n.queue.push(arguments)}; if(!f._fbq)f._fbq=n;n.push=n;n.loaded=!0;n.version='2.0'; n.queue=[];t=b.createElement(e);t.async=!0; t.src=v;s=b.getElementsByTagName(e)[0]; s.parentNode.insertBefore(t,s)}(window,document,'script', 'https://connect.facebook.net/en_US/fbevents.js');

if( typeof sopp !== "undefined" && sopp === 'yes' ){ fbq('dataProcessingOptions', ['LDU'], 1, 1000); }else{ fbq('dataProcessingOptions', []); }

fbq('init', '1321385257908563');

fbq('track', 'PageView');

fbq('trackSingle', '1321385257908563', 'ViewContent', { content_name: 'google-chain-of-thought-prompting', content_category: 'news seo ' });