Il reste d’innombrables gros problèmes à résoudre dans le monde de l’automatisation, et l’apprentissage robotique se situe quelque part près du sommet. S’il est vrai que les humains sont devenus assez bons dans la programmation de systèmes pour des tâches spécifiques, il y a une grande question ouverte de: et puis quoi?

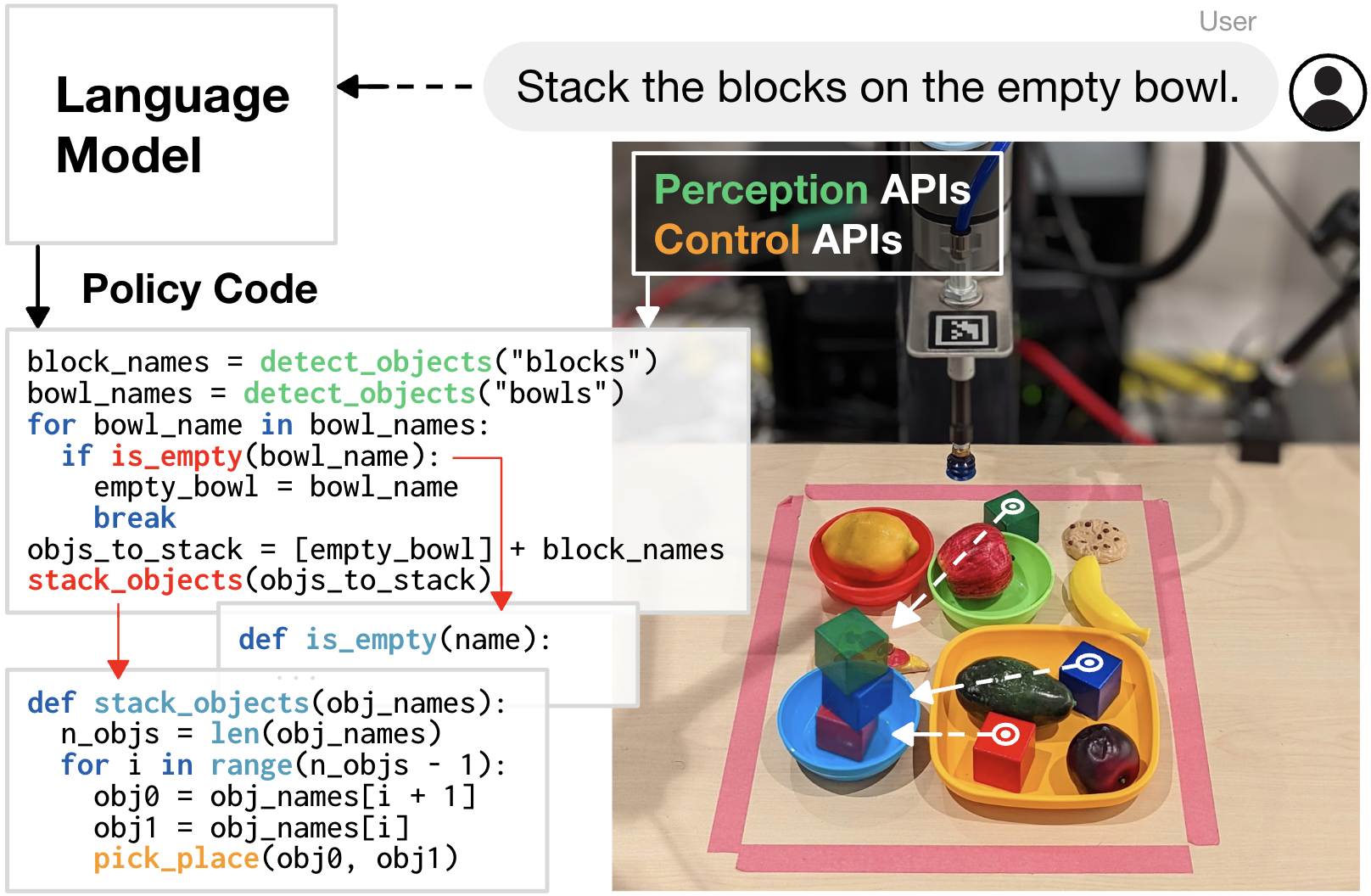

Une nouvelle recherche présentée lors de l’événement sur l’IA de Google à New York ce matin propose l’idée de laisser les systèmes robotiques écrire efficacement leur propre code. Le concept est conçu pour éviter aux développeurs humains d’avoir à reprogrammer les choses au fur et à mesure que de nouvelles informations apparaissent.

Crédits d’image : Google (en anglais)

L’entreprise note que la recherche existante et les modèles formés peuvent être efficaces dans la mise en œuvre du concept. Tout ce travail peut s’avérer fondamental dans le développement de systèmes qui peuvent continuer à générer leur propre code basé sur des objets et des scénarios rencontrés dans le monde réel. La nouvelle œuvre exposée aujourd’hui est Code as Policies (CaP).

Crédits d’image : Google (en anglais)

Jacky Liang, stagiaire en recherche chez Google, et Andy Zeng, chercheur en robotique, notent dans un article de blog:

Avec CaP, nous proposons d’utiliser des modèles de langage pour écrire directement le code du robot via des invites à quelques plans. Nos expériences démontrent que la sortie de code a conduit à une amélioration de la généralisation et de la performance des tâches par rapport à l’apprentissage direct des tâches robotiques et à la production d’actions en langage naturel. CaP permet à un seul système d’effectuer une variété de tâches robotiques complexes et variées sans formation spécifique à la tâche.

Le système, tel que décrit, s’appuie également sur des bibliothèques et des API tierces pour générer au mieux le code adapté à un scénario spécifique – ainsi que la prise en charge des langages et (pourquoi pas?) des emojis. Les informations accessibles dans ces API sont l’une des limitations existantes à l’heure actuelle. Les chercheurs notent: « Ces limites indiquent des pistes pour les travaux futurs, y compris l’extension des modèles de langage visuel pour décrire les comportements des robots de bas niveau (par exemple, les trajectoires) ou la combinaison de CaP avec des algorithmes d’exploration qui peuvent ajouter de manière autonome à l’ensemble des primitives de contrôle. »

Dans le cadre de l’annonce d’aujourd’hui, Google publie des versions open source du code accessibles via son Site GitHub pour s’appuyer sur la recherche qu’il a présentée jusqu’à présent. Donc, vous savez, toutes les mises en garde concernant les premières étapes de la recherche ici.