Pendant la pandémie de COVID-19, le public a lutté contre une toute autre menace : ce que le secrétaire général de l’ONU António Guterres a appelé une « pandémie de désinformation ». La propagande trompeuse et autres fake news sont facilement partageables sur les réseaux sociaux, ce qui menace la santé publique. Autant que un en quatre adultes a affirmé qu’ils ne recevront pas le vaccin. Et ainsi, alors que nous avons enfin suffisamment de doses pour atteindre l’immunité collective aux États-Unis, trop de gens sont inquiets quant aux vaccins (ou sceptiques quant au fait que COVID-19 est même une maladie dangereuse) pour atteindre ce seuil.

cependant, une nouvelle étude du Massachusetts Institute of Technology et de l’incubateur de technologies sociales de Google, Jigsaw a un certain espoir de corriger la désinformation sur les réseaux sociaux. Dans une étude massive impliquant 9 070 participants américains – en tenant compte du sexe, de la race et de la partisanerie – les chercheurs ont découvert que quelques interventions simples d’interface utilisateur peuvent empêcher les gens de partager de fausses nouvelles autour de COVID-19.

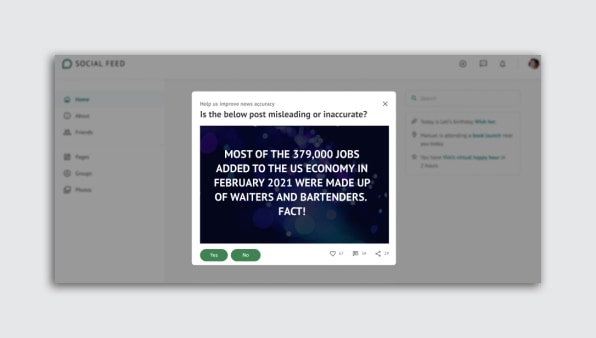

Comment? Pas par « l’alphabétisation” qui leur apprend la différence entre les sources fiables et les sources moche. Et pas à travers un contenu qui a été « signalé » comme faux par les vérificateurs de faits, comme Facebook a tenté.

Au lieu de cela, les chercheurs ont introduit plusieurs invites différentes via une simple fenêtre contextuelle, toutes avec un seul objectif : amener les gens à réfléchir à l’exactitude de ce qu’ils sont sur le point de partager. Lorsqu’ils étaient prêts à considérer l’exactitude d’une histoire, les gens étaient jusqu’à 20 % moins susceptibles de partager une fausse nouvelle. « Ce n’est pas que nous ayons proposé une intervention que vous donnez aux gens une fois, et ils sont fixés », explique le professeur du MIT David Rand, qui était également l’auteur principal de l’étude. « Au lieu de cela, le fait est que les plates-formes, de par leur conception, détournent constamment les gens de la précision. »

Au début de l’expérience, les gens ont reçu une invite contextuelle, comme si on leur demandait d’évaluer l’exactitude d’un titre neutre. Un exemple était : « » Seinfeld » arrive officiellement sur Netflix. » C’était simplement pour les amener à penser à la précision. Ensuite, on leur a présenté un contenu à enjeux plus élevés lié à COVID-19 et on leur a demandé s’ils le partageraient. Des exemples de gros titres COVID-19 que les gens devaient analyser étaient : « La vitamine C protège contre le coronavirus » (faux) et « CDC : la propagation du coronavirus peut durer jusqu’en 2021, mais l’impact peut être émoussé » (vrai). Les personnes qui étaient prêtes à réfléchir à l’exactitude des gros titres étaient moins susceptibles de partager de faux contenus COVID-19.

« La plupart du temps, les gens peuvent assez bien dire ce qui est vrai et faux. Et les gens disent, dans l’ensemble, qu’ils ne veulent pas partager d’informations inexactes », déclare Rand. « Mais ils peuvent le faire quand même parce qu’ils sont distraits, parce que le contexte des médias sociaux concentre leur attention sur d’autres choses [than accuracy]. «

Ce que d’autres choses? Photos de bébé. Une nouvelle annonce d’emploi d’un ennemi. La pression sociale omniprésente des likes, des partages et des followers compte. Rand explique que toutes ces choses s’additionnent et que la conception même des médias sociaux nous détourne de notre discernement naturel.

« Même si vous êtes quelqu’un qui se soucie de l’exactitude et est généralement un penseur critique, le contexte des médias sociaux éteint simplement cette partie de votre cerveau », explique Rand, qui a ensuite raconté une fois au cours de la dernière année, il a découvert qu’il avait partagé une histoire inexacte en ligne, alors qu’il est en fait un chercheur sur ce sujet.

Le MIT a d’abord été le pionnier de la théorie de la recherche. Ensuite, Jigsaw est intervenu pour collaborer et financer le travail tout en utilisant ses concepteurs pour créer les invites. Rocky Cole, responsable du programme de recherche chez Jigsaw, dit que l’idée est « en incubation » dans l’entreprise, et il n’imagine pas qu’elle soit utilisée dans les produits Google tant que l’entreprise ne s’assurera pas qu’il n’y ait pas de conséquences imprévues du travail. (Pendant ce temps, YouTube, filiale de Google, est toujours un refuge dangereux pour la désinformation extrémiste, promue par ses propres algorithmes suggestifs.)

Grâce à la recherche, le MIT et Jigsaw ont développé et testé plusieurs petites interventions qui pourraient aider à ramener une personne dans un état d’esprit sensé et perspicace. Une approche a été appelée une « évaluation ». Tout cela revenait à demander à quelqu’un d’évaluer si un exemple de titre semblait exact, au meilleur de sa connaissance. Cela a amorcé leur mode de discernement. Et lorsque les sujets ont vu un titre COVID-19 après avoir été amorcés, ils étaient beaucoup moins susceptibles de partager des informations erronées.

Une autre approche a été appelée «conseils». C’était juste une petite boîte qui incitait l’utilisateur à « Soyez sceptique face aux gros titres. Enquêter sur la source. Surveillez les mises en forme inhabituelles. Vérifiez les preuves. Une autre approche a été appelée « importance », et elle a simplement demandé aux utilisateurs à quel point il était important pour eux de ne partager que des histoires précises sur les réseaux sociaux. Ces deux approches ont permis de réduire le partage d’informations erronées d’environ 10 %.

Une approche qui n’a pas fonctionné était autour des normes partisanes, ce qui était une invite qui expliquait comment les républicains et les démocrates pensaient qu’il était important de partager uniquement des informations précises sur les réseaux sociaux. Fait intéressant, lorsque cette approche « normes » a été mélangée avec l’approche « pourboires » ou l’approche « importance », devinez quoi ? Les conseils et l’importance sont devenus Suite efficace. « La conclusion générale est que vous pouvez faire beaucoup de choses différentes qui amorcent le concept de précision de différentes manières, et elles fonctionnent toutes à peu près », explique Rand. « Vous n’avez pas besoin d’une façon magique parfaite de le faire. »

Le seul problème est que nous ne comprenons toujours pas une pièce clé du puzzle : combien de temps ces invites fonctionnent-elles ? Quand leurs effets s’estompent-ils ? Les utilisateurs commencent-ils à les régler ?

« Je ferais l’hypothèse [these effects are] assez éphémère », dit Cole. « La théorie suggère que les gens se soucient de la précision. . . mais ils voient une jolie vidéo de chat en ligne et tout à coup, ils ne pensent pas à la précision, ils pensent à autre chose. Et plus vous voyez des invites de précision, plus il est facile de les ignorer.

Ces inconnues ouvrent des pistes de recherches futures. En attendant, nous savons que nous avons à notre disposition des outils, qui peuvent être facilement intégrés aux plateformes de médias sociaux, pour aider à freiner la propagation de la désinformation.

Pour que les gens partagent des informations exactes, les sites pourraient nécessiter un flux constant de nouvelles façons d’amener les utilisateurs à réfléchir à l’exactitude. Rand indique une invite Twitter libéré lors de la dernière élection présidentielle. Il considère que cette invite est un très bon élément de conception, car elle demande aux lecteurs s’ils souhaitent lire un article avant de le retweeter, leur rappelant le sujet de l’exactitude. Mais Twitter n’a pas mis à jour l’invite au cours des nombreux mois qui ont suivi, et c’est probablement moins efficace en conséquence, dit-il. « La première fois [I saw that] c’était comme ‘Whoa! Merde ! » Dit Rand. « Maintenant, c’est comme ‘ouais, ouais’. »