Dans un récent article de blog, Google a annoncé l’introduction de la famille Accelerator-Optimized VM (A2) sur Google Compute Engine, basée sur NVIDIA Ampere GPU A100 Tensor Core. A2 fournit jusqu’à 16 GPU dans une seule machine virtuelle et est la première offre basée sur A100 dans le cloud public.

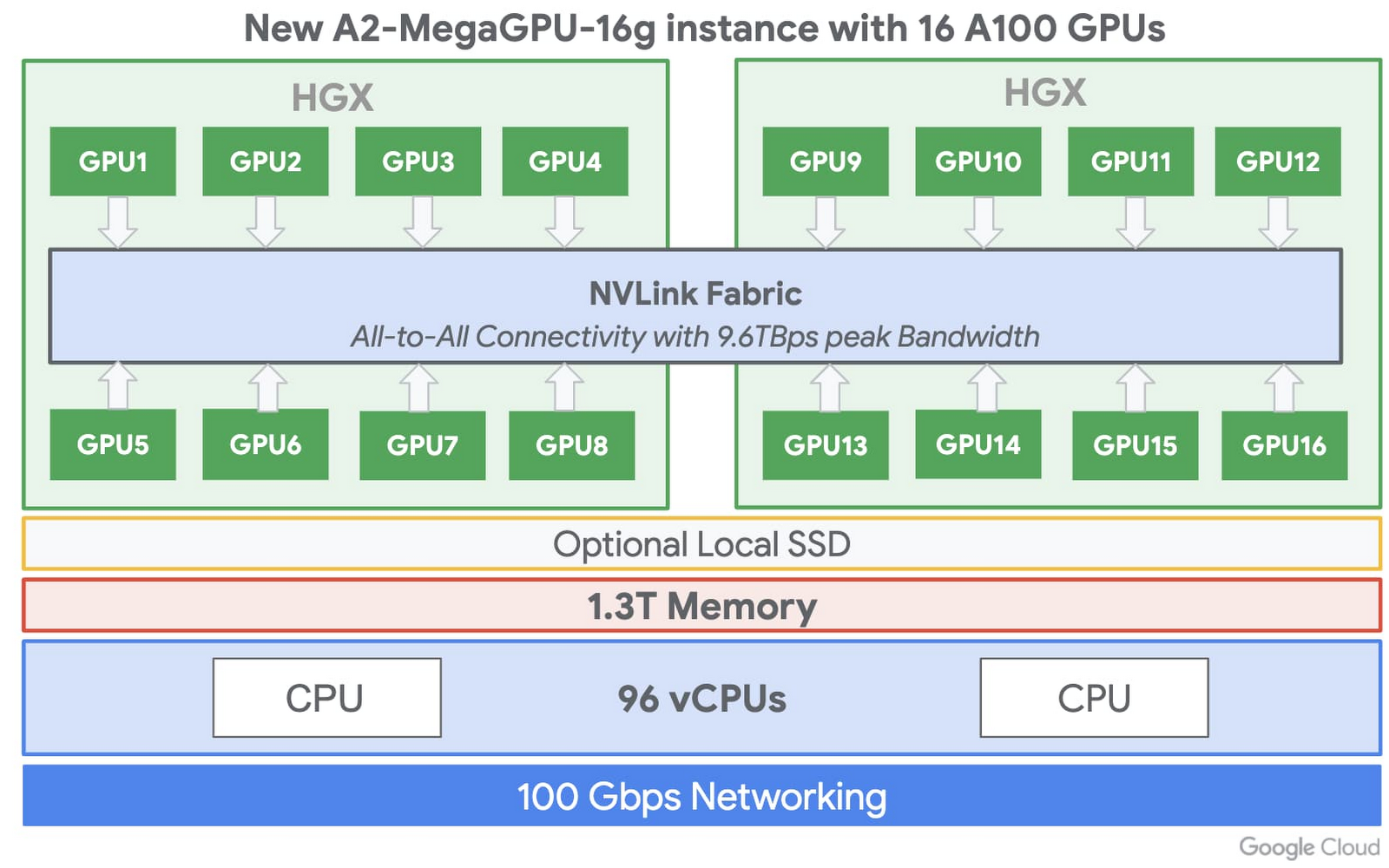

Google a conçu la famille de machines virtuelles A2 pour stimuler la formation et déduire les performances informatiques de ses clients. L’A2 comprend l’unité de traitement graphique NVIDIA A-100 Tensor Core basée sur la nouvelle Architecture NVIDIA Ampere. Selon le blog, l’A-100 offre jusqu’à 20 fois les performances de calcul par rapport au GPU de la génération précédente, et est livré avec 40 Go de mémoire GPU HBM2 haute performance. En outre, les machines virtuelles A2 sont livrées avec jusqu’à 96 processeurs virtuels Intel Cascade Lake, SSD locaux en option pour les charges de travail nécessitant des flux de données plus rapides vers les GPU et jusqu’à 100 Gbit / s de réseau.

Lorsque les clients ont des charges de travail plus exigeantes, l’A2 propose l’instance a2-megagpu-16g avec 16 GPU A100, qui incluent un total de 640 Go de mémoire GPU, 1,3 To de mémoire système et tout-en-un connectés via NVSwitch avec jusqu’à 9,6 To / s de bande passante agrégée.

Notez que A2 propose également des configurations plus petites permettant aux clients de répondre à leur besoin de puissance de calcul GPU. Les clients peuvent choisir entre cinq configurations, de un à 16 GPU, avec deux ratios CPU et réseau / GPU différents – chaque GPU devant être partitionné en sept instances de GPU, en raison de Ampère. capacité de groupe multi-instance (MIG).

Ian Buck, directeur général et vice-président de Accelerated Computing chez NVIDIA, a écrit dans une entreprise récente article de blog sur la disponibilité de l’A-100 sur GCP:

Dans les centres de données cloud, A100 peut alimenter une large gamme d’applications gourmandes en calcul, notamment la formation et l’inférence en IA, l’analyse de données, le calcul scientifique, la génomique, l’analyse vidéo de pointe, les services 5G, etc.

Avec la famille A2, les machines virtuelles Google élargissent encore son portefeuille de machines virtuelles prédéfinies et personnalisées, allant des machines optimisées pour les calculs aux accélérateurs. De plus, la société continue de concurrencer d’autres fournisseurs de cloud comme Microsoft, qui a récemment libéré nouvelles familles de machines virtuelles à usage général et optimisées en mémoire sur divers Chipsets Intel (AVX-512) – et AWS, qui a récemment libéré Instances EC2 Inf1 basées sur son Puces Inferentia. Bon nombre de ces nouveaux types de machines virtuelles sont destinés aux clients ayant des charges de travail d’IA et d’apprentissage automatique.

Holger Mueller, analyste principal et vice-président de Constellation Research Inc., a déclaré à InfoQ:

La bataille pour le leadership du cloud se déroule principalement dans la bataille de l’IA, et il s’agit de faire en sorte que la charge d’IA des entreprises soit attirée par le cloud de chaque fournisseur. Au milieu se trouvent des fournisseurs de plates-formes comme NVidia, qui fournissent une plate-forme multi-cloud et une option sur site. Ainsi, avec l’arrivée de la nouvelle plate-forme Nvidia sur Google Cloud, Google permet aux CxO de déplacer plus facilement les charges de travail de l’IA sur site et dans le cloud (Google).

Il a également déclaré:

Google étant le troisième fournisseur, il doit être plus ouvert et plus créatif pour attirer la charge – et c’est un autre exemple de la stratégie de Google. En revanche, la stratégie AWS et Azure plus large consiste toujours à passer aux architectures de calcul propriétaires du cloud pour les charges d’IA. Les CxO doivent être conscients que le verrouillage est toujours un résultat souhaitable pour la plupart des fournisseurs de technologies et doit équilibrer les risques entre commodité, rapidité et verrouillage.

Actuellement, la famille A2 VM est en alpha, et les clients peuvent demander l’accès par s’enregistrer. De plus, Google déclare que la disponibilité publique et les informations sur les prix arriveront plus tard dans l’année. Enfin, la société a également annoncé la prise en charge prochaine de Nvidia A100 pour Google Kubernetes Engine, Cloud AI Platform et d’autres services.

.