La création d’un modèle de langage par Google n’est pas quelque chose de nouveau ; en fait, Google LaMDA rejoint les goûts de BERT et MUM comme un moyen pour les machines de mieux comprendre l’intention de l’utilisateur.

Google a fait des recherches des modèles basés sur le langage pendant plusieurs années dans l’espoir de former un modèle qui pourrait essentiellement tenir une conversation perspicace et logique sur n’importe quel sujet.

Jusqu’à présent, Google LaMDA semble être le plus proche d’atteindre ce jalon.

Qu’est-ce que Google LaMDA?

LaMDA, qui signifie Language Models for Dialog Application, a été créé pour permettre aux logiciels de mieux s’engager dans une conversation fluide et naturelle.

LaMDA est basé sur la même architecture de transformateur que d’autres modèles de langage tels que BERT et GPT-3.

Cependant, grâce à sa formation, LaMDA peut comprendre des questions et des conversations nuancées couvrant plusieurs sujets différents.

Avec d’autres modèles, en raison de la nature ouverte des conversations, vous pourriez finir par parler de quelque chose de complètement différent, même si vous vous concentrez initialement sur un seul sujet.

Ce comportement peut facilement confondre la plupart des modèles conversationnels et des chatbots.

Pendant l’annonce Google I/O de l’année dernière, nous avons vu que LaMDA a été conçu pour surmonter ces problèmes.

La démonstration a prouvé comment le modèle pouvait naturellement mener une conversation sur un sujet donné au hasard.

Malgré le flot de questions vaguement associées, la conversation est restée sur la bonne voie, ce qui était incroyable à voir.

Comment fonctionne LaMDA?

LaMDA a été construit sur le réseau neuronal open-source de Google, Transformateur, qui est utilisé pour la compréhension du langage naturel.

Le modèle est entraîné à trouver des modèles dans les phrases, des corrélations entre les différents mots utilisés dans ces phrases, et même prédire le mot qui est susceptible de venir ensuite.

Il le fait en étudiant des ensembles de données constitués de dialogues plutôt que de simples mots individuels.

Bien qu’un système d’IA conversationnel soit similaire à un logiciel de chatbot, il existe des différences clés entre les deux.

Par exemple, les chatbots sont formés sur des ensembles de données limités et spécifiques et ne peuvent avoir qu’une conversation limitée basée sur les données et les questions exactes sur lesquelles ils sont formés.

D’autre part, parce que LaMDA est formé sur plusieurs ensembles de données différents, il peut avoir des conversations ouvertes.

Au cours du processus de formation, il reprend les nuances du dialogue ouvert et s’adapte.

Il peut répondre à des questions sur de nombreux sujets différents, en fonction du déroulement de la conversation.

Par conséquent, il permet des conversations qui sont encore plus similaires à l’interaction humaine que les chatbots peuvent souvent fournir.

Comment LaMDA est-il formé?

Google a expliqué que LaMDA a un processus de formation en deux étapes, y compris la pré-formation et le réglage fin.

Au total, le modèle est entraîné sur 1,56 billion de mots avec 137 milliards de paramètres.

Pré-formation

Pour la phase de pré-formation, l’équipe de Google a créé un ensemble de données de 1,56 T de mots à partir de plusieurs documents Web publics.

Ce jeu de données est ensuite tokenisé (transformé en une chaîne de caractères pour créer des phrases) en jetons 2.81T, sur lesquels le modèle est initialement formé.

Pendant la pré-formation, le modèle utilise parallélisation générale et évolutive pour prédire la prochaine partie de la conversation en fonction des jetons précédents qu’elle a vus.

Réglage fin

LaMDA est formé pour effectuer des tâches de génération et de classification pendant la phase de réglage fin.

Essentiellement, le générateur LaMDA, qui prédit la prochaine partie du dialogue, génère plusieurs réponses pertinentes basées sur la conversation aller-retour.

Les classificateurs LaMDA prédiront ensuite les scores de sécurité et de qualité pour chaque réponse possible.

Toute réponse avec un faible score de sécurité est filtrée avant que la réponse la mieux notée ne soit sélectionnée pour poursuivre la conversation.

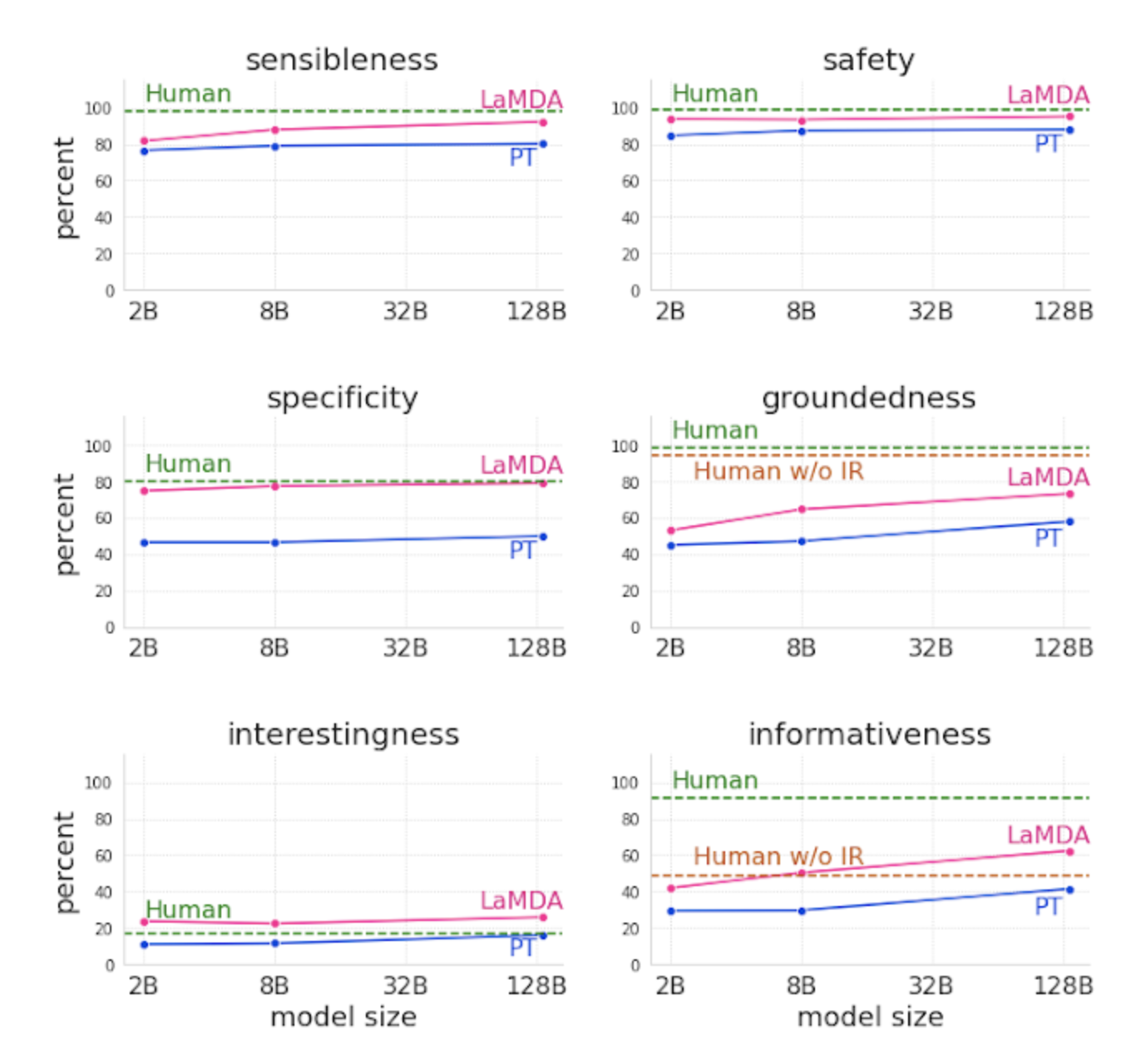

Les scores sont basés sur la sécurité, la sensibilité, la spécificité et les pourcentages intéressants.

Image tirée du blog Google AI, mars 2022

Image tirée du blog Google AI, mars 2022L’objectif est de s’assurer que la réponse la plus pertinente, la plus qualitative et, en fin de compte, la plus sûre est fournie.

Objectifs et mesures clés de LaMDA

Trois objectifs principaux du modèle ont été définis pour guider la formation du modèle.

Ce sont la qualité, la sécurité et la mise à la terre.

Qualité

Ceci est basé sur trois dimensions d’évaluateur humain:

- Sensibilité.

- Spécificité

- Interespicotement.

Le score de qualité est utilisé pour s’assurer qu’une réponse a du sens dans le contexte dans lequel elle est utilisée, qu’elle est spécifique à la question posée et qu’elle est considérée comme suffisamment perspicace pour créer un meilleur dialogue.

Sécurité

Pour assurer la sécurité, le modèle suit les normes de l’IA responsable. Un ensemble d’objectifs de sécurité est utilisé pour capturer et examiner le comportement du modèle.

Cela garantit que la sortie ne fournit aucune réponse involontaire et évite tout biais.

Enracinement

La mise à la terre est définie comme suit : « le pourcentage de réponses contenant des affirmations sur le monde extérieur. »

Ceci est utilisé pour s’assurer que les réponses sont aussi « factuellement exactes que possible, permettant aux utilisateurs de juger de la validité d’une réponse en fonction de la fiabilité de sa source ».

Évaluation

Grâce à un processus continu de quantification des progrès, les réponses du modèle pré-formé, du modèle affiné et des évaluateurs humains sont examinées pour évaluer les réponses par rapport aux mesures de qualité, de sécurité et d’enracinement susmentionnées.

Jusqu’à présent, ils ont pu conclure que :

- Les mesures de qualité s’améliorent avec le nombre de paramètres.

- La sécurité s’améliore avec un réglage fin.

- La mise à la terre s’améliore à mesure que la taille du modèle augmente.

Image tirée du blog Google AI, mars 2022

Image tirée du blog Google AI, mars 2022Comment LaMDA sera-t-il utilisé?

Bien qu’il s’agisse encore d’un travail en cours sans date de sortie finalisée, il est prévu que LaMDA sera utilisé à l’avenir pour améliorer l’expérience client et permettre aux chatbots de fournir une conversation plus humaine.

De plus, l’utilisation de LaMDA pour naviguer dans la recherche dans le moteur de recherche de Google est une véritable possibilité.

Implications de LaMDA pour le référencement

En se concentrant sur les modèles linguistiques et conversationnels, Google offre un aperçu de sa vision de l’avenir de la recherche et met en évidence un changement dans la façon dont ses produits sont prêts à se développer.

Cela signifie en fin de compte qu’il pourrait bien y avoir un changement dans le comportement de recherche et la façon dont les utilisateurs recherchent des produits ou des informations.

Google travaille constamment à améliorer la compréhension de l’intention de recherche des utilisateurs pour s’assurer qu’ils reçoivent les résultats les plus utiles et les plus pertinents dans les SERP.

Le modèle LaMDA sera, sans aucun doute, un outil clé pour comprendre les questions que les chercheurs peuvent poser.

Tout cela souligne davantage la nécessité de s’assurer que le contenu est optimisé pour les humains plutôt que pour les moteurs de recherche.

S’assurer que le contenu est conversationnel et écrit en pensant à votre public cible signifie que même si Google progresse, le contenu peut continuer à bien fonctionner.

C’est aussi la clé de régulièrement actualiser le contenu à feuilles persistantes pour s’assurer qu’il évolue avec le temps et demeure pertinent.

Dans un article intitulé Repenser la recherche : faire des dilettantes des experts, les ingénieurs de recherche de Google ont partagé comment ils envisagent des avancées de l’IA telles que LaMDA pour améliorer encore « la recherche en tant que conversation avec des experts ».

Ils ont partagé un exemple autour de la question de recherche, « Quels sont les avantages et les risques pour la santé du vin rouge? »

Actuellement, Google affichera une liste de boîtes de réponse de puces comme réponses à cette question.

Cependant, ils suggèrent qu’à l’avenir, une réponse pourrait bien être un paragraphe expliquant les avantages et les risques du vin rouge, avec des liens vers les informations sources.

Par conséquent, il sera plus important que jamais de s’assurer que le contenu est sauvegardé par des sources expertes si Google LaMDA génère des résultats de recherche à l’avenir.

Surmonter les défis

Comme pour tout modèle d’IA, il y a des défis à relever.

Le deux défis principaux les ingénieurs face à Google LaMDA sont la sécurité et la mise à la terre.

Sécurité – Éviter les biais

Parce que vous pouvez extraire des réponses de n’importe où sur le Web, il est possible que la sortie amplifie le biais, reflétant les notions qui sont partagées en ligne.

Il est important que la responsabilité vienne en premier avec Google LaMDA pour s’assurer qu’il ne génère pas de résultats imprévisibles ou nuisibles.

Pour aider à surmonter cela, Google a ouvert les ressources utilisées pour analyser et former les données.

Cela permet à divers groupes de participer à la création des ensembles de données utilisés pour former le modèle, aider à identifier les biais existants et minimiser le partage de toute information nuisible ou trompeuse.

Mise à la terre factuelle

Il n’est pas facile de valider la fiabilité des réponses produites par les modèles d’IA, car les sources sont collectées sur le Web.

Pour surmonter ce défi, l’équipe permet au modèle de consulter plusieurs external sources, y compris des systèmes de recherche d’informations et même une calculatrice, pour fournir des résultats précis.

La métrique Groundedness partagée précédemment garantit également que les réponses sont fondées sur des sources connues. Ces sources sont partagées pour permettre aux utilisateurs de valider les résultats donnés et d’empêcher la propagation de désinformation.

Quelle est la prochaine étape pour Google LaMDA?

Google est clair qu’il y a des avantages et des risques à des modèles de dialogue ouverts tels que LaMDA et s’engage à améliorer la sécurité et l’enracinement pour assurer une expérience plus fiable et impartiale.

La formation de modèles LaMDA sur différentes données, y compris des images ou des vidéos, est une autre chose que nous pourrions voir à l’avenir.

Cela ouvre la possibilité de naviguer encore plus sur le Web, en utilisant des invites de conversation.

Le PDG de Google, Sundar Pichai dit de LaMDA« Nous pensons que les capacités de conversation de LaMDA ont le potentiel de rendre l’information et l’informatique radicalement plus accessibles et plus faciles à utiliser. »

Bien qu’une date de déploiement n’ait pas encore été confirmée, il ne fait aucun doute que des modèles tels que LaMDA seront l’avenir de Google.

Plus de ressources :

Image en vedette: Andrey Suslov / Shutterstock

!function(f,b,e,v,n,t,s) {if(f.fbq)return;n=f.fbq=function(){n.callMethod? n.callMethod.apply(n,arguments):n.queue.push(arguments)}; if(!f._fbq)f._fbq=n;n.push=n;n.loaded=!0;n.version='2.0'; n.queue=[];t=b.createElement(e);t.async=!0; t.src=v;s=b.getElementsByTagName(e)[0]; s.parentNode.insertBefore(t,s)}(window,document,'script', 'https://connect.facebook.net/en_US/fbevents.js');

if( typeof sopp !== "undefined" && sopp === 'yes' ){ fbq('dataProcessingOptions', ['LDU'], 1, 1000); }else{ fbq('dataProcessingOptions', []); }

fbq('init', '1321385257908563');

fbq('track', 'PageView');

fbq('trackSingle', '1321385257908563', 'ViewContent', { content_name: 'how-google-lamda-works', content_category: 'seo ' });