Le mois dernier ici sur Search Engine Journal, l’auteur Roger Montti a couvert le document de recherche Google sur un nouvel algorithme de traitement du langage naturel nommé SMITH.

La conclusion? Ce SMITH surpasse BERT pour les longs documents.

Avant de plonger, dès maintenant, SMITH n’est pas en direct dans les algorithmes de Google. Si mes sens Spidey sont bons, il se déploiera avec l’indexation des passages ou le précédera.

Les lecteurs réguliers sauront que je m’intéresse à l’apprentissage automatique en ce qui concerne la recherche, et j’ai donc dû me plonger dans le document de recherche pour moi-même.

Je devais aussi revoir certains des documents BERT pour vraiment comprendre ce qui se passait.

Le BERT est-il sur le point d’être remplacé?

La plupart des documents sur le Web qui ne sont pas des contenus légers ne sont-ils pas donc longs et donc meilleurs pour SMITH?

Je vais d’abord vous amener à la conclusion.

SMITH peut faire les deux tâches et un bazooka peut ouvrir une porte. Mais il vaut toujours mieux apporter votre clé, dans de nombreux cas.

Publicité

Continuer la lecture ci-dessous

Pourquoi BERT ou SMITH pour commencer?

Ce que nous demandons vraiment avec cette question, c’est pourquoi un moteur de recherche voudrait utiliser le traitement du langage naturel (NLP).

La réponse est assez simple; La PNL aide à la transition des moteurs de recherche comprenant les chaînes (mots-clés) aux choses (entités).

Là où Google n’avait autrefois aucune idée de ce qui devrait être sur une page autre que les mots-clés, ou si le contenu avait même un sens, avec la PNL, il a appris à mieux comprendre le contexte des mots.

Le ton.

Ce «compte bancaire» et «berge» font référence à des banques différentes.

Que la phrase «Dave a rencontré Danny pour une bière, des bières, une pinte, un verre, une boisson, une bière, une bière…» n’est pas naturelle.

En tant que professionnel du référencement, le bon vieux temps me manque.

En tant que personne qui a besoin de trouver des choses sur Internet, je ne le fais pas.

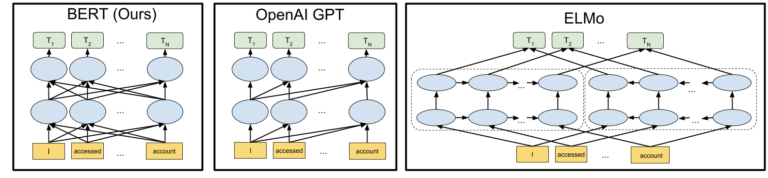

Entrez BERT

BERT est le meilleur modèle de PNL actuel que nous ayons pour de nombreuses, sinon la plupart, des applications, y compris la compréhension de structures linguistiques complexes.

La le plus grand bond en avant avec BERT à mon avis était dans le premier caractère, bidirectionnel.

Plutôt que de simplement «lire» de gauche à droite, il pourrait également comprendre le contexte en sens inverse.

Publicité

Continuer la lecture ci-dessous

Un exemple trop simplifié pourrait consister à comprendre la phrase suivante:

Une voiture a des lumières.

Si vous ne comprenez que de gauche à droite, lorsque vous appuyez sur le mot «feux», vous classerez la voiture comme quelque chose qui a des lumières parce que vous avez rencontré le mot voiture avant et que vous pourriez faire l’association.

Mais, si vous vouliez classer des éléments sur les voitures, les lumières peuvent être manquées parce qu’elles n’avaient pas été rencontrées avant «voiture».

Il est difficile d’apprendre dans une seule direction.

De plus, le «sous le capot» de BERT est remarquable et permet de traiter efficacement le langage avec des coûts de ressources inférieurs à ceux des modèles précédents – une considération importante lorsque l’on veut l’appliquer à l’ensemble du Web.

Un autre bond en avant avec BERT a été son application de jetons.

Dans BERT, il y a 30 000 jetons et chacun représente un mot commun avec quelques restes pour les fragments et les caractères au cas où un mot serait en dehors des 30 000.

Grâce au traitement des jetons et aux transformateurs, la façon dont BERT a pu comprendre le contenu lui a donné la capacité à laquelle j’ai fait allusion ci-dessus, à comprendre cela dans la phrase:

«L’homme est allé à la banque. Il s’est ensuite assis sur la rive du fleuve.

Les première et dernière instances de «banque» doivent recevoir des valeurs différentes car elles se réfèrent à des choses différentes.

Et SMITH?

Alors maintenant, SMITH fait son entrée, avec de meilleurs nombres et une meilleure utilisation des ressources dans le traitement de documents volumineux.

BERT utilise 256 jetons par document. Après cela, le coût de calcul devient trop élevé pour qu’il soit fonctionnel, et ce n’est souvent pas le cas.

SMITH, en revanche, peut gérer 2248 jetons. Les documents peuvent être 8x plus grands.

Pour comprendre pourquoi les coûts de calcul augmentent dans un seul modèle PNL, nous devons simplement considérer ce qu’il faut pour comprendre une phrase par rapport à un paragraphe.

Avec une phrase, il n’y a généralement qu’un seul concept de base à comprendre, et relativement peu de mots signifiant peu de liens entre les mots et les idées à garder en mémoire.

Faites de cette phrase un paragraphe et les connexions se multiplient de façon exponentielle.

Le traitement 8x du texte nécessite en fait beaucoup plus de fois que la vitesse et la capacité d’optimisation de la mémoire en utilisant le même modèle.

Publicité

Continuer la lecture ci-dessous

SMITH contourne ce problème en effectuant essentiellement des lots et en effectuant une grande partie du traitement hors ligne.

Mais il est intéressant de noter que pour que SMITH fonctionne, il s’appuie toujours fortement sur BERT.

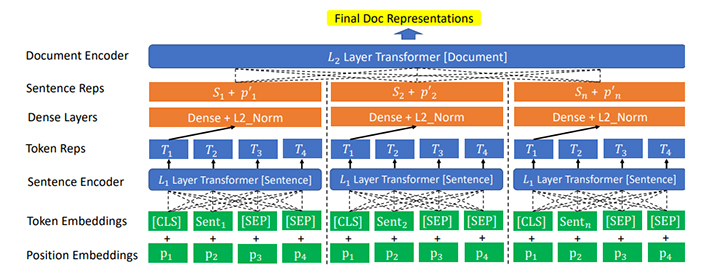

À la base, SMITH prend un document à travers le processus suivant:

- Il divise le document en tailles de regroupement qu’il peut gérer, en favorisant les phrases (c’est-à-dire que si le document allouait 4,5 phrases à un bloc basé sur la longueur, il le tronquerait à quatre).

- Il traite ensuite chaque bloc de phrase individuellement.

- Un transformateur apprend alors les représentations contextuelles de chaque bloc et les transforme en une représentation de document.

La schéma du processus ressemble à:

Vous pouvez voir une similitude entre les quatre lignes du bas et le processus BERT ci-dessus. Après cela, nous passons aux représentations au niveau des phrases et les transformons au niveau du document.

Publicité

Continuer la lecture ci-dessous

Un peu de Side Tech

Fait intéressant, pour former le modèle SMITH, nous prenons de BERT de deux manières:

1. Pour former le BERT, ils retireraient un mot d’une phrase et proposeraient des options.

Le BERT le mieux formé a réussi à choisir la bonne option. Par exemple, ils pourraient lui donner la phrase:

Le brun rapide _____ sauta par-dessus le chien paresseux.

Option 1 – laitue

Options 2 – renard

Plus il est formé, plus il est probable qu’il choisisse l’option 2.

Cette méthode de formation se poursuit également avec SMITH.

2. Parce qu’ils s’entraînent pour les gros documents, ils prennent également des passages et suppriment des phrases.

Plus le système est susceptible de reconnaître la phrase omise, mieux c’est.

Même idée, application différente.

Je trouve cette partie intéressante en tant que pro du référencement, car elle peint un monde avec du contenu généré par Google assemblé dans des SERPs murés. Bien sûr, l’utilisateur peut partir, mais pourquoi le ferait-il si Google pouvait rassembler du contenu court et long de toutes les meilleures sources en un seul endroit?

Publicité

Continuer la lecture ci-dessous

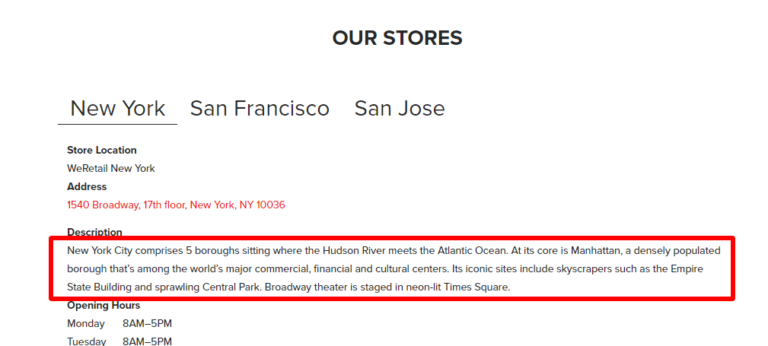

Vous pensez que cela n’arrivera pas? Ça commence déjà et ça ressemble à:

Bien qu’ils le fassent encore mal, comme en témoigne cet exemple du site Ryerson:

Cette prochaine étape rendra tout simplement moins flagrant qu’ils ne font qu’arnaquer du contenu.

On dirait que SMITH est meilleur …

On dirait que SMITH est meilleur, n’est-ce pas?

Et pour de nombreuses tâches, ce sera le cas.

Publicité

Continuer la lecture ci-dessous

Mais pensez à la façon dont vous utilisez Internet.

- «Quel temps fait-il?»

- « Jouer une chanson. »

- «Itinéraire vers un restaurant.»

De nombreuses requêtes sont satisfaites non seulement par des réponses courtes, mais également par des données limitées et souvent simples.

SMITH s’implique dans la compréhension de documents longs et complexes et de requêtes longues et complexes.

Cela comprendra le rassemblement de documents et de sujets pour créer leurs propres réponses.

Cela comprendra la détermination de la façon dont le contenu peut être divisé (oserais-je dire… en passages) afin que Google sache quoi faire surface.

Cela aidera chacun à mieux comprendre comment les pages de contenu sont liées les unes aux autres, comment les liens peuvent être valorisés, etc.

Ainsi, chacun sert un but.

SMITH est le bazooka. Cela peindra la compréhension de la façon dont les choses sont. Il est plus coûteux en ressources car il fait un travail plus important, mais il est beaucoup moins coûteux que le BERT de faire ce travail.

Publicité

Continuer la lecture ci-dessous

BERT aidera SMITH à le faire et aidera à comprendre les requêtes courtes et les morceaux de contenu.

Autrement dit, jusqu’à ce que les deux soient remplacés, nous ferons alors un autre bond en avant et je parierai que le prochain algorithme sera:

Borienté Object-agnostique Rtransformateur basé sur egresson gtoujours.

Les nerds de Star Trek comme moi dans la foule l’obtiendront. 😉

Plus de ressources:

Crédits d’image

Toutes les captures d’écran prises par l’auteur, janvier 2020