Le domaine de la génération d’images évolue rapidement. Bien que les modèles de diffusion utilisés par des outils populaires comme Midjourney et Stable Diffusion puissent sembler les meilleurs que nous ayons, la prochaine chose arrive toujours – et OpenAI aurait pu y parvenir avec des « modèles de cohérence », qui peuvent déjà effectuer des tâches simples et ordre de grandeur plus rapide que DALL-E.

Le papier était mis en ligne en prépublication le mois dernier, et n’était pas accompagné de la fanfare discrète qu’OpenAI réserve pour ses versions majeures. Ce n’est pas une surprise : il ne s’agit ici que d’un document de recherche très technique. Mais les résultats de cette technique précoce et expérimentale sont suffisamment intéressants pour être notés.

Les modèles de cohérence ne sont pas particulièrement faciles à expliquer, mais ont plus de sens contrairement aux modèles de diffusion.

En diffusion, un modèle apprend à soustraire progressivement le bruit d’une image de départ entièrement composée de bruit, en la rapprochant progressivement de l’invite cible. Cette approche a permis d'obtenir les images d'IA les plus impressionnantes d'aujourd'hui, mais elle repose fondamentalement sur l'exécution de 10 à des milliers d'étapes pour obtenir de bons résultats. Cela signifie que son fonctionnement est coûteux et suffisamment lent pour que les applications en temps réel ne soient pas pratiques.

L'objectif des modèles de cohérence était de créer quelque chose qui obtenait des résultats décents en une seule étape de calcul, ou au plus deux. Pour ce faire, le modèle est entraîné, comme un modèle de diffusion, à observer le processus de destruction de l'image, mais apprend à prendre une image à n'importe quel niveau d'obscurcissement (c'est-à-dire avec un peu ou beaucoup d'informations manquantes) et à générer une image source complète dans juste une étape.

Mais je m’empresse d’ajouter qu’il ne s’agit ici que de la description la plus vague de ce qui se passe. C'est ce genre de papier :

Un extrait représentatif du document de cohérence. Crédits images : OpenAI

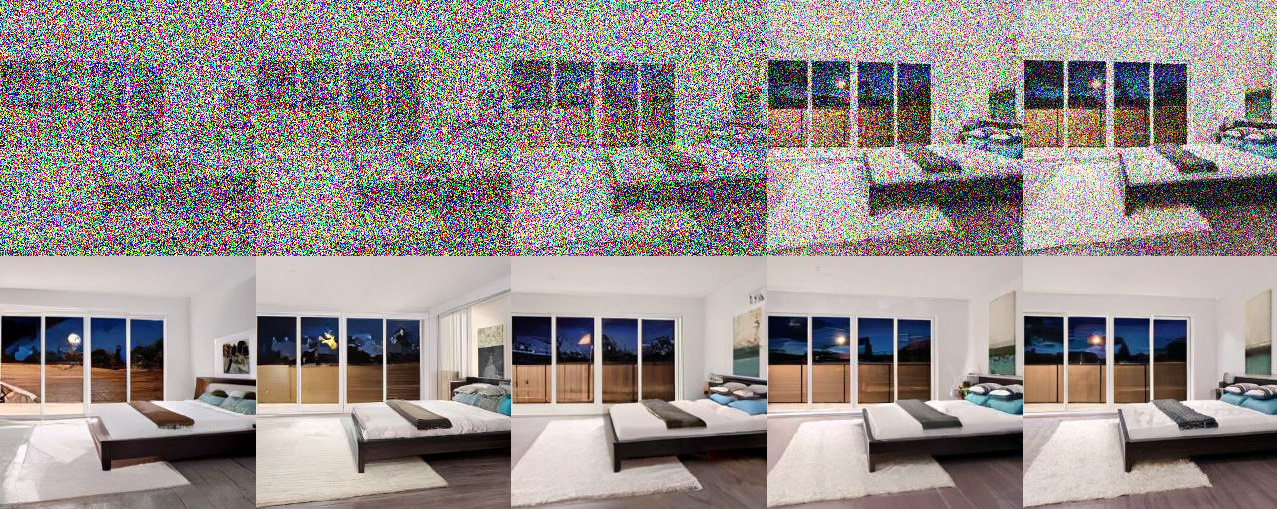

Les images qui en résultent ne sont pas époustouflantes – la plupart des images peuvent difficilement être qualifiées de bonnes. Mais ce qui compte, c’est qu’ils ont été générés en une seule étape plutôt qu’en cent ou mille. De plus, le modèle de cohérence se généralise à diverses tâches telles que la colorisation, la mise à l'échelle, l'interprétation des croquis, le remplissage, etc., également en une seule étape (bien que fréquemment améliorée d'une seconde).

Que l’image soit principalement composée de bruit ou de données, les modèles de cohérence aboutissent directement à un résultat final. Crédits images : OpenAI

Cela est important, d'abord, parce que le modèle dans la recherche sur l'apprentissage automatique est généralement que quelqu'un établit une technique, quelqu'un d'autre trouve un moyen de la faire fonctionner mieux, puis d'autres l'ajustent au fil du temps tout en ajoutant des calculs pour produire des résultats considérablement meilleurs que ceux avec lesquels vous avez commencé. C'est plus ou moins ainsi que nous nous sommes retrouvés avec les modèles de diffusion modernes et ChatGPT. Il s'agit d'un processus auto-limité car, en pratique, vous ne pouvez consacrer qu'une quantité limitée de calculs à une tâche donnée.

Ce qui se passe ensuite, cependant, est une nouvelle technique plus efficace qui peut faire ce que le modèle précédent faisait, bien pire au début mais aussi bien plus efficacement. Les modèles de cohérence le démontrent, même s'il est encore suffisamment tôt pour qu'ils ne puissent pas être directement comparés aux modèles de diffusion.

Mais cela est important à un autre niveau car cela montre comment OpenAI, de loin l’organisme de recherche en IA le plus influent au monde à l’heure actuelle, étudie activement la diffusion passée des cas d’utilisation de la prochaine génération.

Oui, si vous souhaitez effectuer 1 500 itérations en une minute ou deux à l’aide d’un cluster de GPU, vous pouvez obtenir des résultats époustouflants à partir des modèles de diffusion. Mais que se passe-t-il si vous souhaitez exécuter un générateur d'images sur le téléphone de quelqu'un sans vider sa batterie, ou fournir des résultats ultra-rapides, par exemple, dans une interface de chat en direct ? La diffusion n'est tout simplement pas le bon outil pour ce travail, et les chercheurs d'OpenAI recherchent activement le bon – y compris Ilya Sutskever, un nom bien connu dans le domaine, pour ne pas minimiser les contributions des autres auteurs, Yang Song, Prafulla Dhariwal et Mark. Chen.

Que les modèles de cohérence soient la prochaine grande étape pour OpenAI ou juste une autre flèche dans son carquois – l’avenir est presque certainement à la fois multimodal et multimodèle – dépendra de la manière dont la recherche se déroulera. J'ai demandé plus de détails et je mettrai à jour cet article si j'ai des nouvelles des chercheurs.