[ad_1]

Lors du Hot Chips 2023 (35), Samsung reparle de son traitement en mémoire (PIM) avec de nouvelles recherches et une nouvelle tournure. Nous en avons déjà parlé, par exemple dans notre Hot Chips 33 Samsung HBM2-PIM et Aquabolt-XL. Aujourd’hui, Samsung le montre dans le contexte de l’IA.

Puisque ces séances se déroulent en direct depuis l’auditorium, veuillez excuser les fautes de frappe. Hot Chips est un rythme fou.

Traitement Samsung dans la technologie de mémoire au Hot Chips 2023

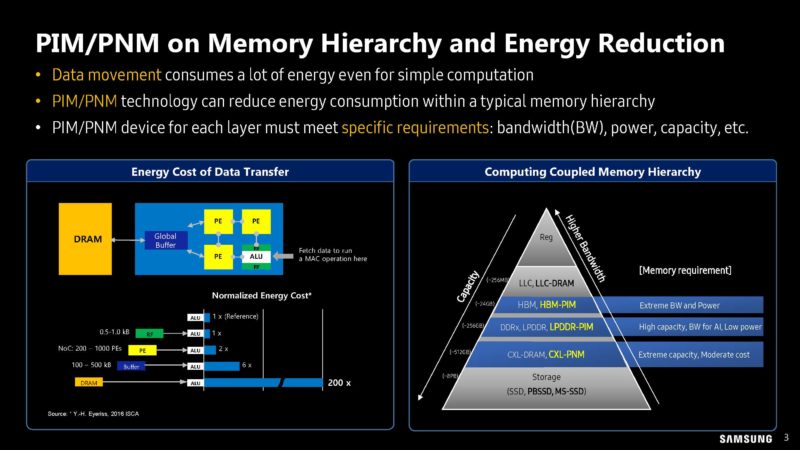

L’un des coûts les plus importants en informatique est le déplacement des données depuis différents emplacements de stockage et de mémoire vers les moteurs de calcul proprement dits.

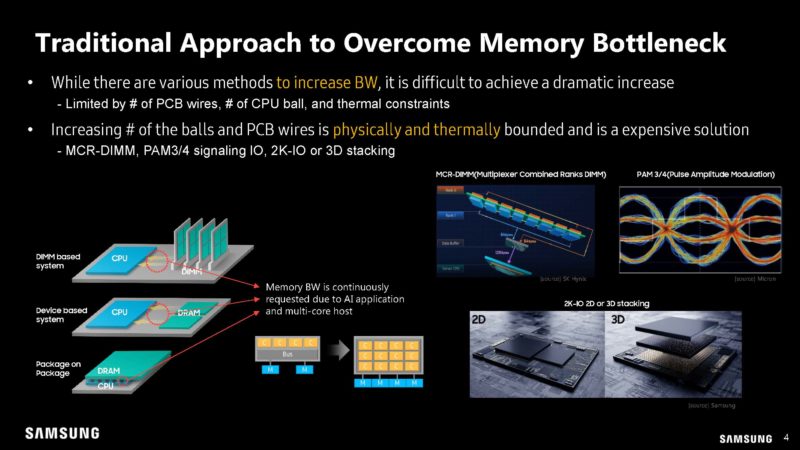

Actuellement, les entreprises tentent d’ajouter davantage de voies ou de canaux pour différents types de mémoire. Cela a ses limites.

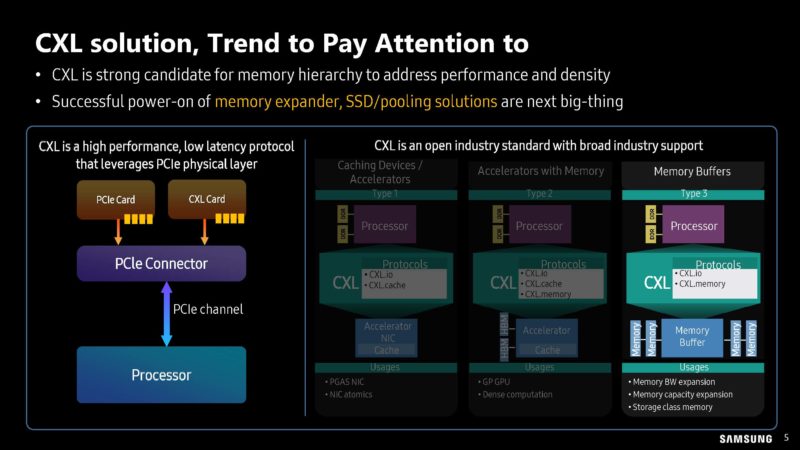

Samsung discute de CXL. CXL est utile car il permet, par exemple, de réutiliser les câbles pour PCIe afin de fournir plus de bande passante mémoire. Nous allons discuter davantage des appareils CXL Type-3 à l’avenir sur STH et nous les avons abordés à plusieurs reprises.

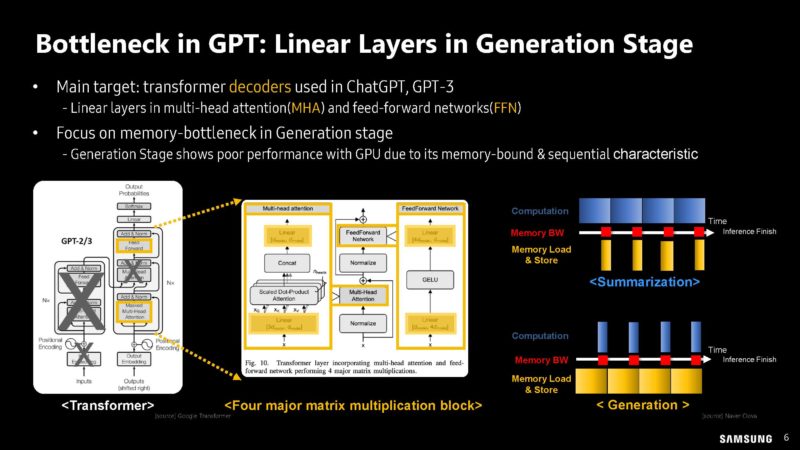

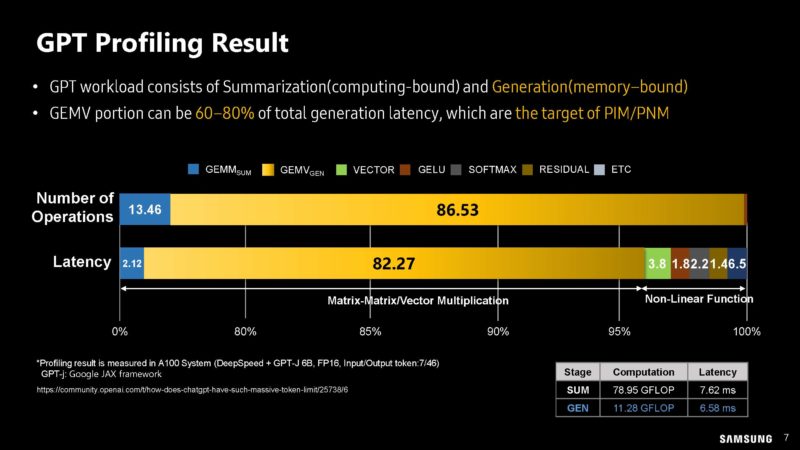

Samsung discute des goulots d’étranglement GPT.

Samsung a profilé les charges de travail liées au calcul et à la mémoire de GPT.

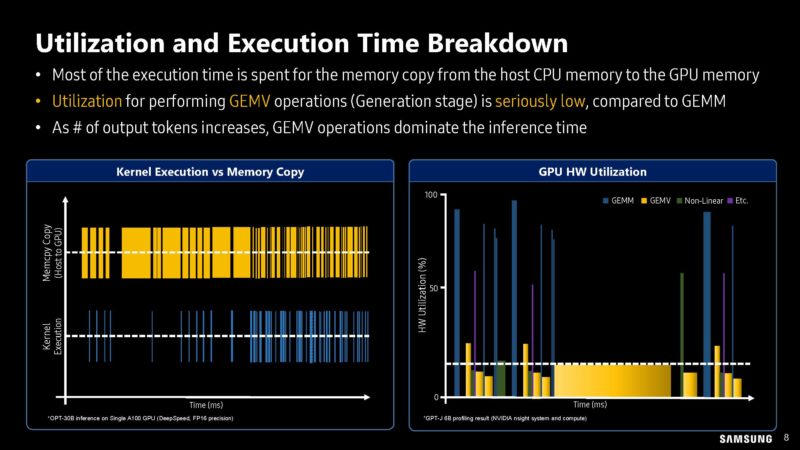

Voici un peu plus sur le travail de profilage en termes d’utilisation et de temps d’exécution.

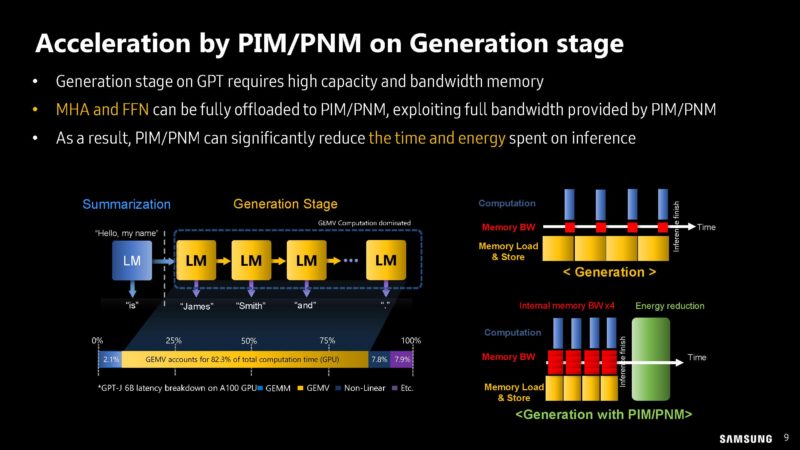

Samsung montre comment des parties du pipeline de calcul peuvent être déchargées vers des modules de traitement en mémoire (PIM).

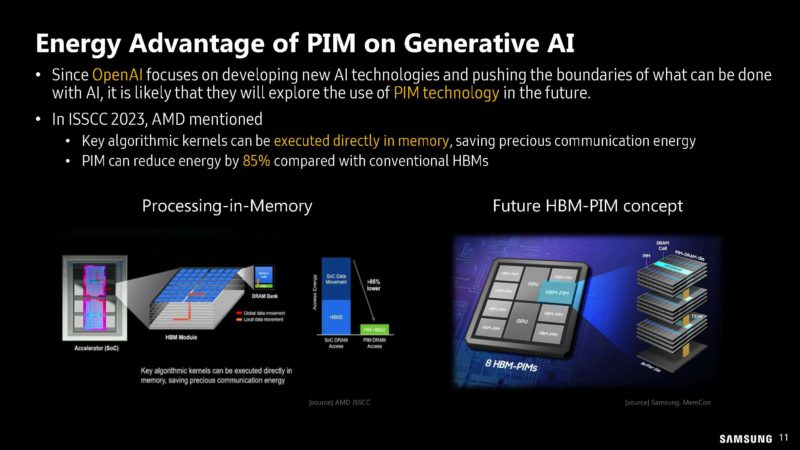

Effectuer le traitement au niveau du module de mémoire, au lieu de l’accélérateur, permet d’économiser le mouvement des données, réduisant ainsi la consommation d’énergie et les coûts d’interconnexion.

Alors que SK hynix parlait de GDDR6 pour sa solution, Samsung présente sa mémoire haut débit HBM-PIM. Nous allons montrer HBM sur les processeurs Intel Xeon MAX dans la semaine prochaine sur STH, mais cela n’utilise pas ce nouveau type de mémoire.

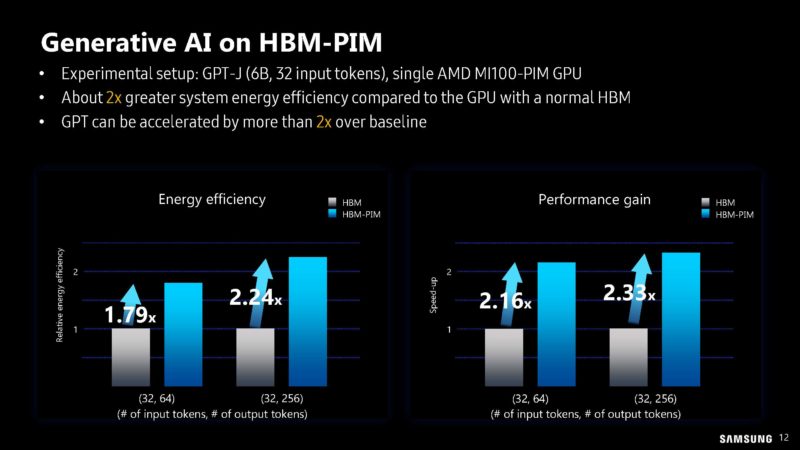

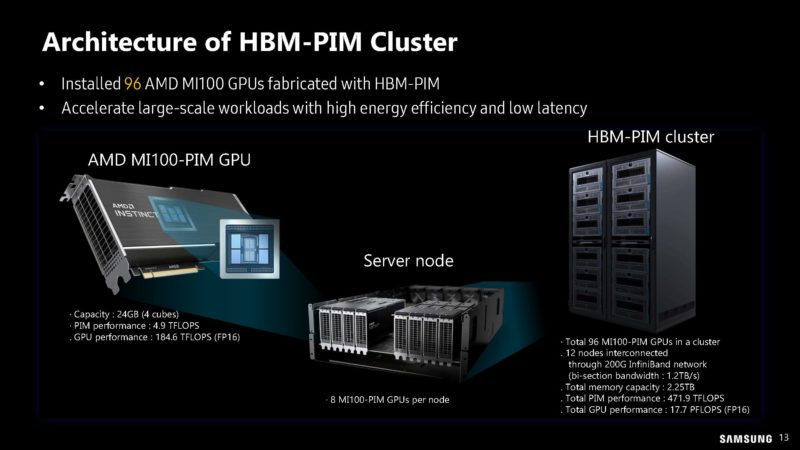

Apparemment, Samsung et AMD avaient des MI100 avec HBM-PIM au lieu d’un simple PIM standard afin de pouvoir créer un cluster afin d’avoir ce qui ressemble à un cluster à 12 nœuds et 8 accélérateurs pour essayer la nouvelle mémoire.

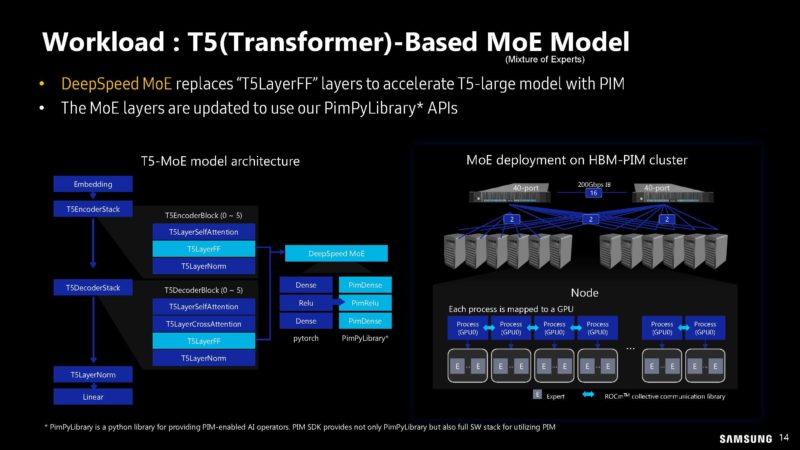

Voici comment le modèle T5-MoE utilise HBM-PIM dans le cluster.

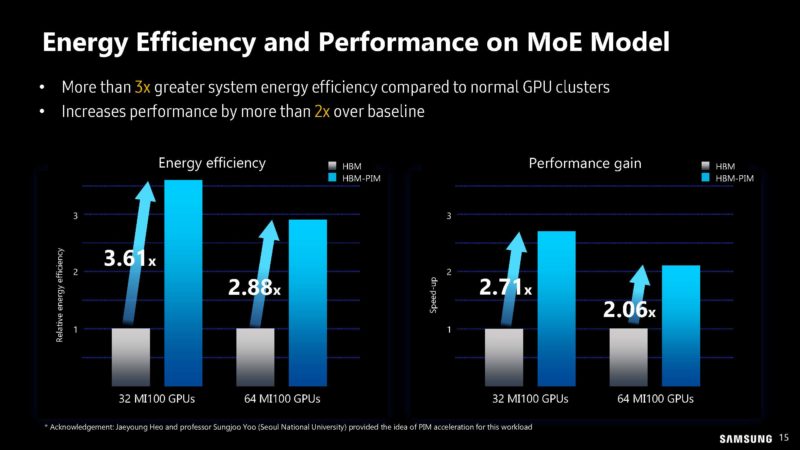

Voici les gains en performances et en efficacité énergétique.

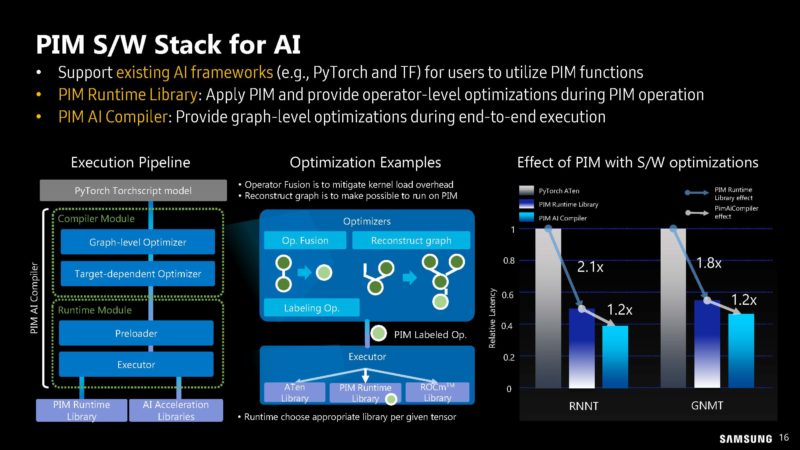

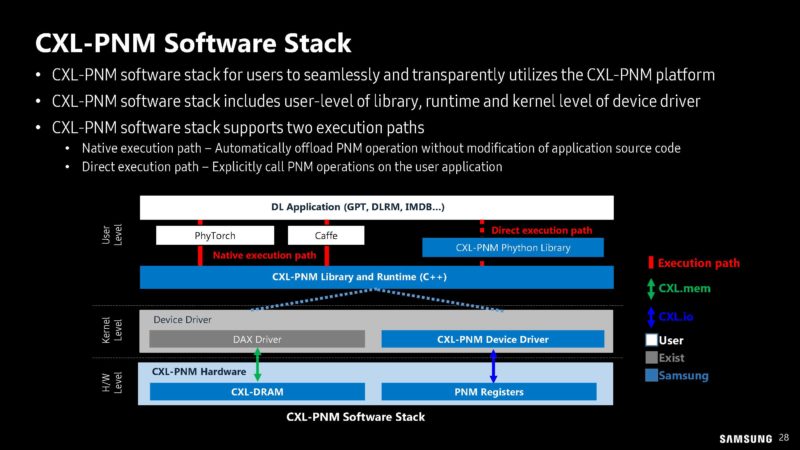

Une grande partie de cela consiste également à savoir comment faire en sorte que les modules PIM fassent un travail utile. Cela nécessite un travail logiciel pour programmer et utiliser les modules PIM.

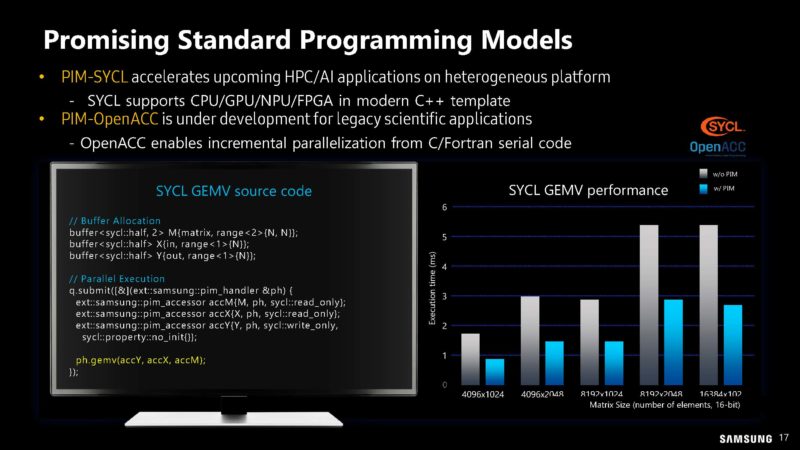

Samsung espère intégrer ces modules de programmation standard.

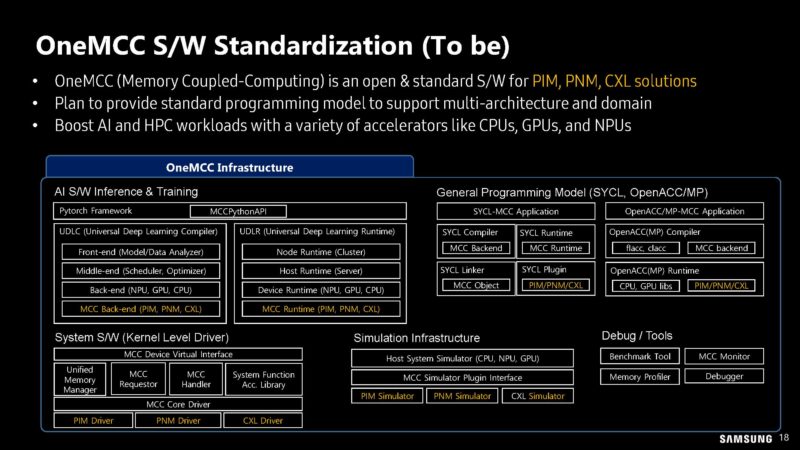

Voici le OneMCC pour l’état futur de l’informatique couplée à la mémoire, mais cela ressemble à un état futur plutôt qu’à un état actuel.

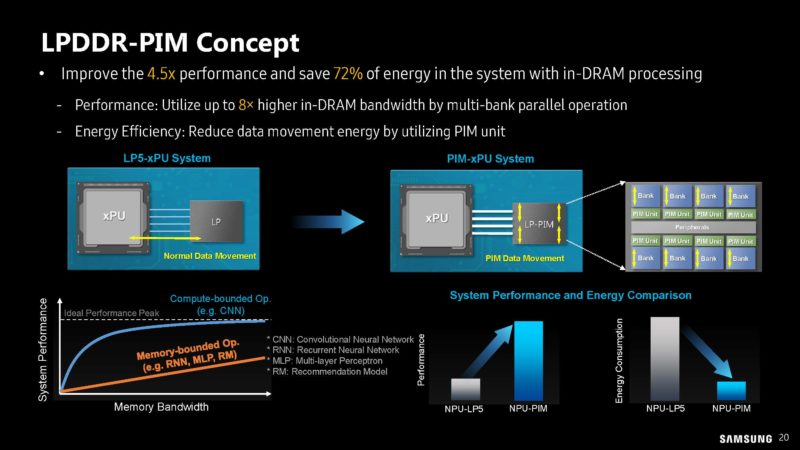

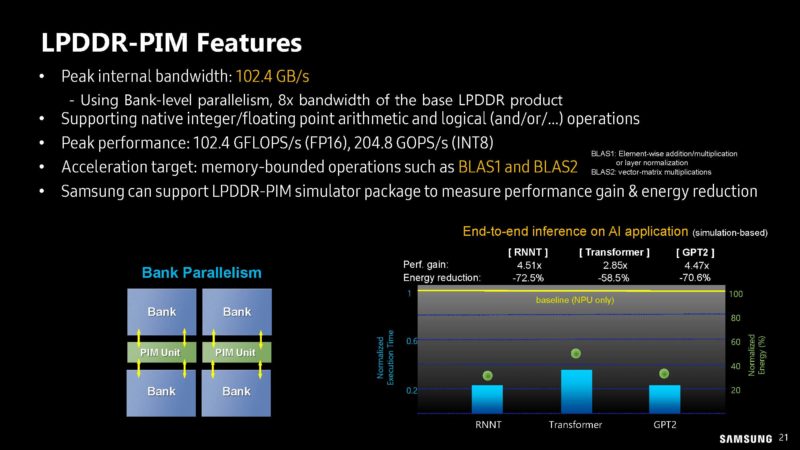

Il semble que Samsung présente non seulement le HBM-PIM, mais également le LPDDR-PIM. Comme pour tout aujourd’hui, il a besoin d’un label Generative AI.

Celui-ci semble être davantage un concept que le HBM-PIM utilisé sur les AMD MI100 dans un cluster.

Ce LPDDR-PIM n’a qu’une bande passante interne de 102,4 Go/s, mais l’idée est que garder le calcul sur le module de mémoire signifie une consommation réduite en n’ayant pas à retransmettre les données au CPU ou au xPU.

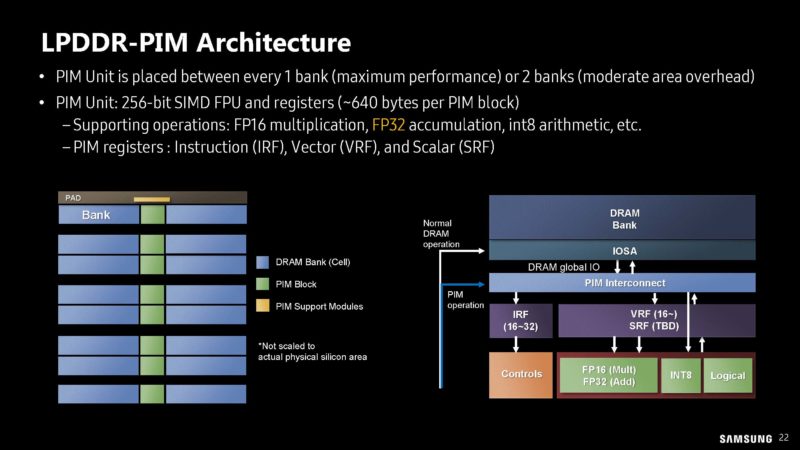

Voici l’architecture avec les banques PIM et les banques DRAM sur le module.

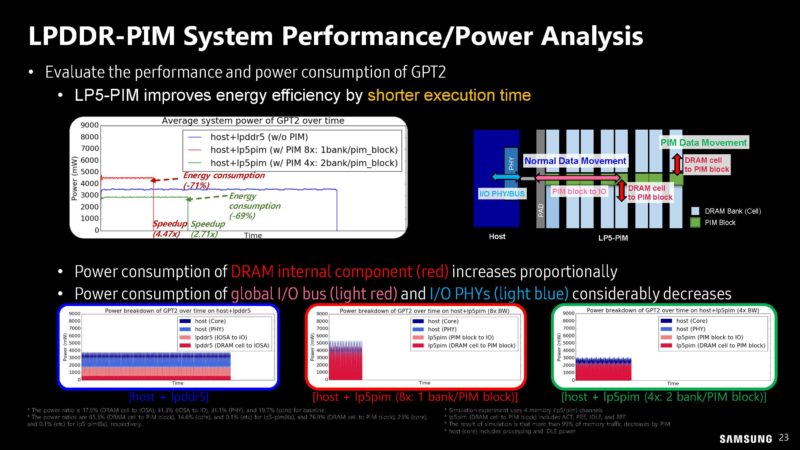

Voici à quoi ressemble l’analyse des performances et de la puissance sur les éventuels modules LP5-PIM.

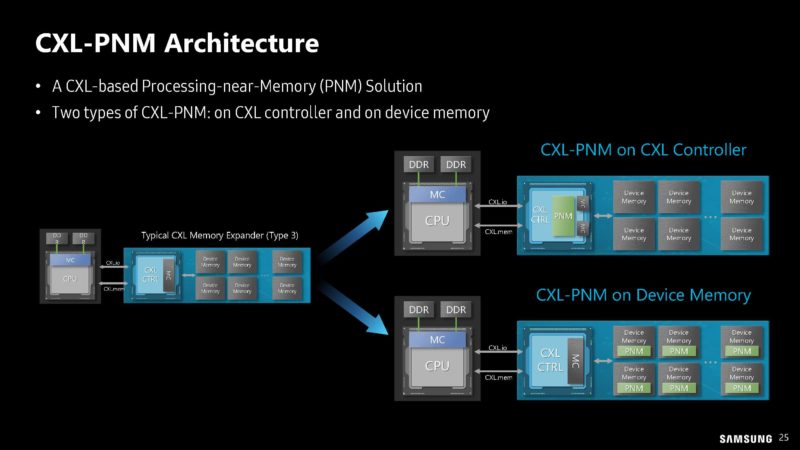

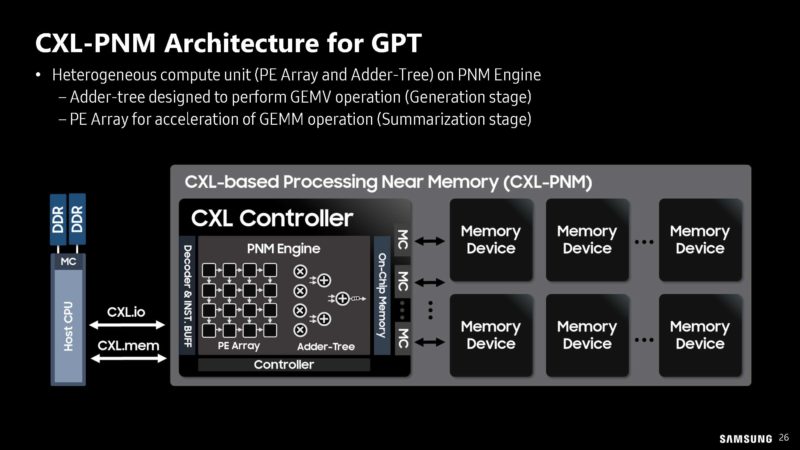

Si HBM-PIM et LPDDR-PIM ne suffisaient pas, Samsung envisage de mettre le calcul sur les modules CXL du PNM-CXL.

L’idée ici n’est pas seulement de mettre de la mémoire sur les modules CXL Type-3. Au lieu de cela, Samsung propose de mettre le calcul sur le module CXL. Cela peut être fait soit en ajoutant un élément de calcul au module CXL et en utilisant une mémoire standard, soit en utilisant PIM sur les modules et un contrôleur CXL plus standard.

Bien sûr, nous montrons comment cela aide l’IA générative du côté GPT.

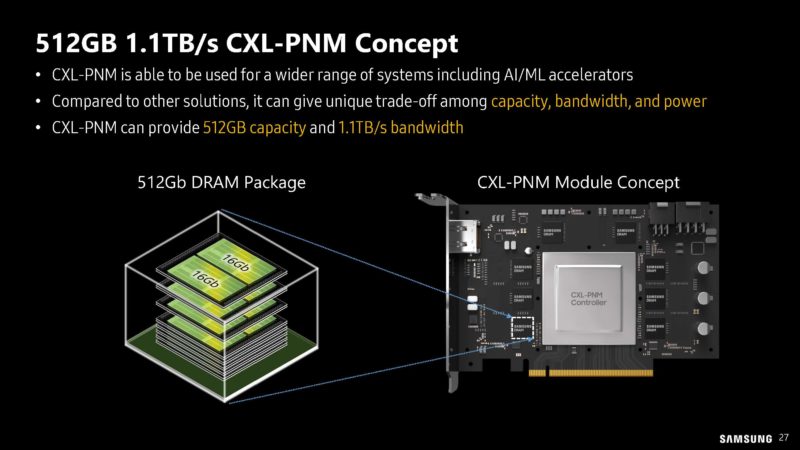

Samsung propose une carte concept CXL-PNM de 512 Go avec jusqu’à 1,1 To/s de bande passante.

Voici la pile logicielle CXL-PNM proposée par Samsung.

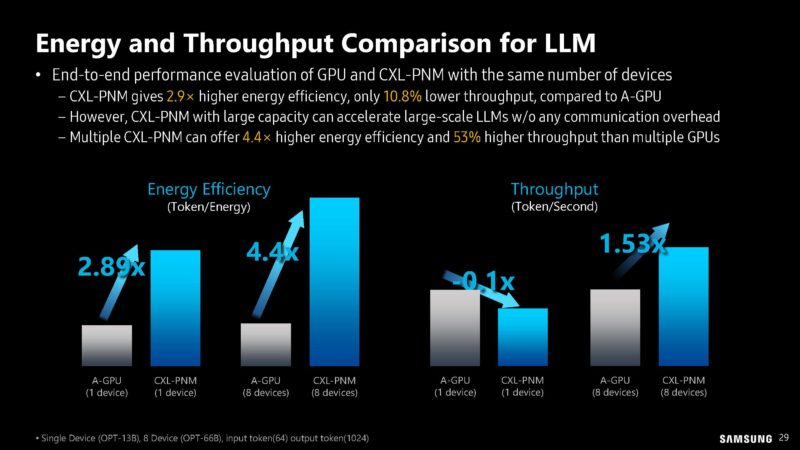

Voici les économies d’énergie et le débit attendus pour les charges de travail LLM à grande échelle. CXL utilise généralement des câbles également utilisés pour PCIe, de sorte que les coûts énergétiques pour la transmission des données sont très élevés. En conséquence, il y a des gains importants à pouvoir éviter ce transfert de données.

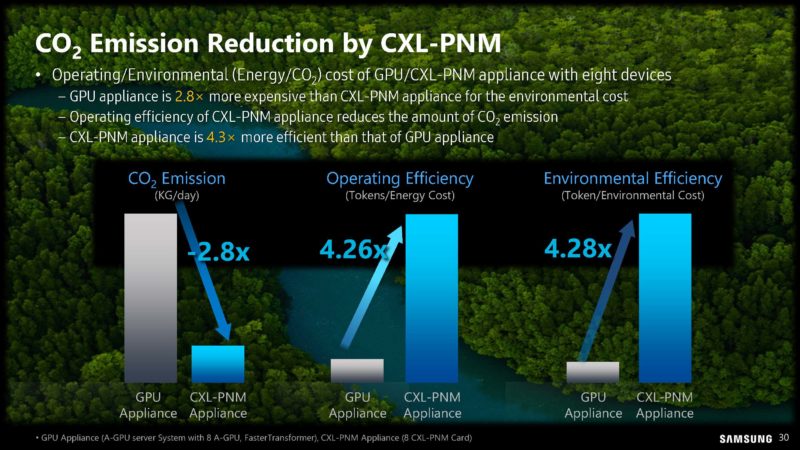

Samsung se concentre également sur les réductions d’émissions résultant de ce qui précède.

Plus tôt dans la journée, Google a fait un grand discours sur les émissions de CO2 dans l’informatique IA. Nous prévoyons d’en parler plus tard cette semaine sur STH.

Derniers mots

Samsung encourage le PIM depuis des années, mais le PIM/PNM semble passer d’un simple concept de recherche à une entreprise qui cherche réellement à le produire. Espérons que nous pourrons en voir davantage à l’avenir. Le CXL-PNM pourrait finir par être un domaine propice à ce type de calcul.

[ad_2] ->Google Actualités