Robert Triggs / Autorité Android

IA générative a explosé au cours des 18 derniers mois avec le lancement de divers services d’IA surpuissants pour créer du texte, des images, de la musique ou même servir d’assistant complet.

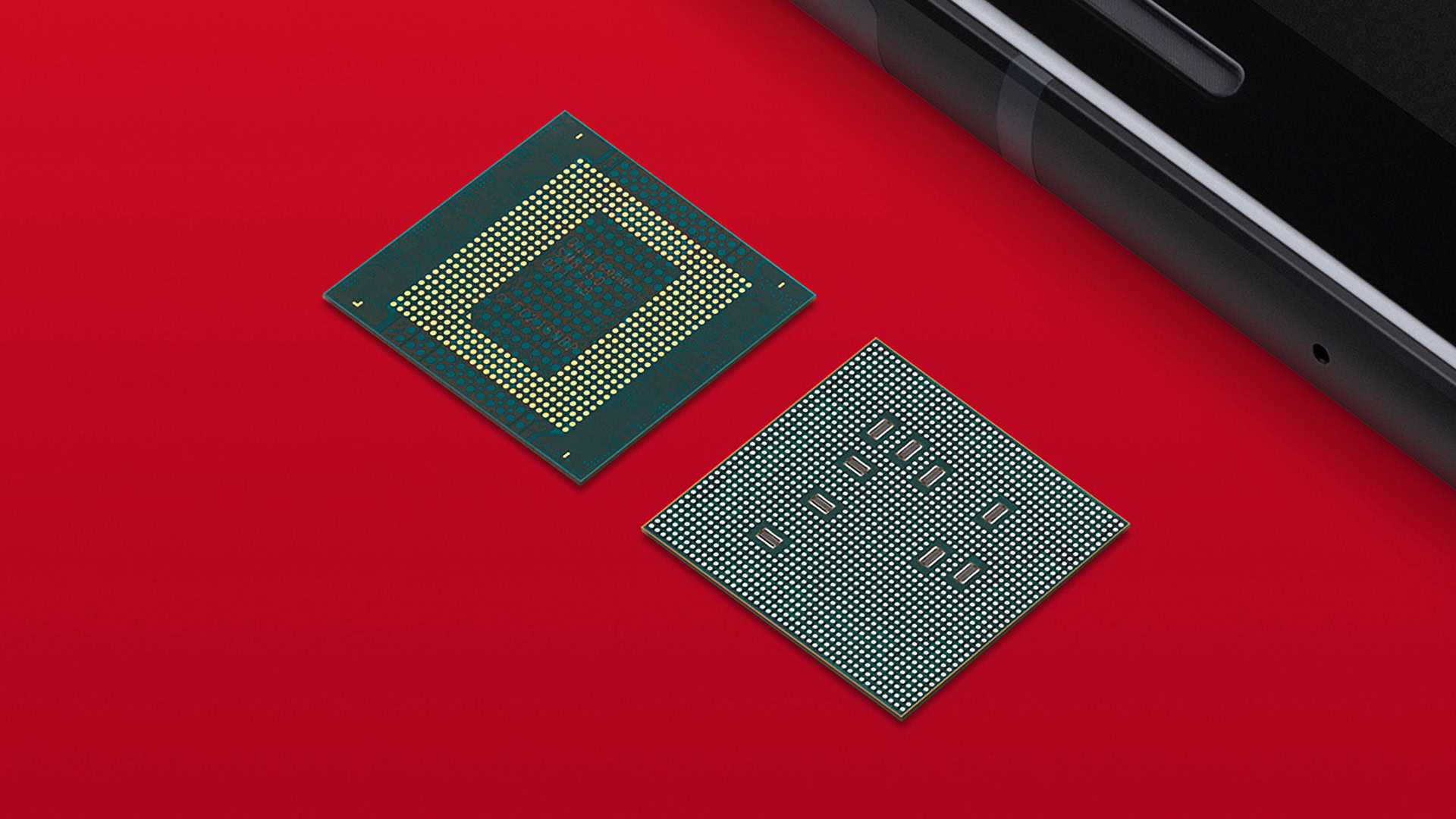

Les fabricants de smartphones et de puces mobiles ont également adopté cette tendance, en utilisant du nouveau matériel pour s’adapter rapidement à cette nouvelle tendance. Le nouveau de Google Série Pixel 8 ouvre déjà la voie, et avec Qualcomm Muflier 8 génération 3 processeur au coin de la rue, nous prévoyons des progrès encore plus importants au cours de l’année à venir. Voyons à quoi s’attendre.

Ce que nous avons vu jusqu’à présent

Robert Triggs / Autorité Android

La preuve la plus récente montrant que les fabricants de smartphones ont adopté l’IA générative de manière beaucoup plus large est Google. Les téléphones Pixel 8 de la société sont les premiers smartphones à exécuter des versions des modèles génératifs AI Foundation de Google sur l’appareil. Google affirme que les modèles vus sur les téléphones Pixel 8 sont des versions réduites de leurs modèles basés sur le cloud, mais que l’exécution sur l’appareil est plus sécurisée et plus fiable lorsque les données ne sont pas disponibles.

Ceci est rendu possible grâce au Tenseur G3, Google vantant une unité de traitement tensoriel (TPU) bien améliorée par rapport à l’année dernière. La société garde généralement le fonctionnement interne de son silicium d’IA un secret bien gardé, mais elle a divulgué quelques pépites d’informations. D’une part, Google affirme que le Pixel 8 exécute deux fois plus de modèles d’apprentissage automatique sur l’appareil que la série Pixel 6. Il a ajouté que les modèles d’IA générative de la série Pixel 8 exécutent jusqu’à 150 fois plus de calculs que le plus grand modèle du Pixel 7.

En anglais, cela signifie que vous disposez de fonctionnalités telles que la dictée vocale multilingue, la fonctionnalité Best Take, Audio Magic Eraser, un Magic Eraser amélioré, des résumés d’enregistreur et bien plus encore, sans avoir besoin de traitement cloud.

Google n’est pas la seule marque mobile récente à adopter l’IA générative au niveau matériel. Samsung a confirmé que le Exynos 2400 Le chipset était en préparation plus tôt ce mois-ci, ajoutant qu’il offrirait une augmentation de 14,7 fois des performances informatiques de l’IA par rapport à l’Exynos 2200. Mesurer les performances informatiques de l’IA est encore un domaine un peu trouble, mais Samsung a au moins une utilisation en tête.

La société a déclaré avoir développé un outil d’IA pour les « téléphones à venir » alimentés par l’Exynos 2400. Cet outil vous permettra d’exécuter la génération de texte en image sur l’appareil sans avoir besoin d’une connexion Internet.

Ce qu’attend Qualcomm

Les puces Snapdragon de Qualcomm alimentent la plupart des téléphones Android phares dans le monde. Nous sommes donc curieux de voir ce que le prochain Snapdragon 8 Gen 3 offrira en termes de capacités d’IA générative.

La société a déjà présenté une version du générateur de texte-image Stable Diffusion fonctionnant sur un Muflier 8 génération 2 appareil plus tôt cette année. Cela suggère que la prise en charge de la génération d’images pourrait être une fonctionnalité sur le nouveau chipset, en particulier à la lumière de l’Exynos 2400 offrant cette fonctionnalité.

Pourrions-nous cependant voir du silicium dédié à l’IA générative rejoindre le silicium dédié à l’IA ? Karl Whealton, directeur principal de Qualcomm, a déclaré Autorité Android dans une interview, il a déclaré que si le matériel existant était suffisamment puissant, efficace et flexible, il pourrait alors couvrir « la plupart des choses que vous souhaitez faire ».

Il semble que les smartphones ne disposeront pas de matériel dédié à l’IA générative en 2024.

Whealton a déclaré qu’il y avait une tendance à examiner des fonctions particulières liées à l’IA générative (citant l’exemple de softmax) et demandez-vous si un matériel spécifique était nécessaire pour y remédier.

Cependant, l’exécutif a estimé que le silicium existant de Qualcomm était effectivement suffisamment puissant et flexible pour ce type de besoins :

Il semble que, vous savez, nous ayons généralement des améliorations significatives du moteur, mais une refonte ou un NPU spécifique autour d’une certaine charge de travail… Cela continue d’être le cas jusqu’à présent via Snapdragon 8 Gen 2, que rien de tel n’est nécessaire.

En disant cela, Qualcomm était resté fidèle à ses positions lorsque les premiers chipsets mobiles dotés de silicium dédié à l’IA ont fait leurs débuts en 2017 et 2018. Mais la société a finalement cédé avec le Snapdragon 855, qui alimentait les téléphones phares de 2019, apportant l’accélérateur Hexagon Tensor à la table.

Nous avons également vu des téléphones avec un 24 Go de RAM fait ses débuts plus tôt cette année, certaines personnes suggérant que ce serait une bonne utilisation pour les modèles d’IA génératifs. De cette façon, vous pourriez théoriquement avoir un assistant IA de grande envergure occupant une partie de cette RAM. Il convient que la quantité de RAM sera importante pour les futures applications d’IA générative.

Les téléphones dotés d’une tonne de RAM semblent exagérés, mais l’un des avantages potentiels est que cela pourrait permettre des modèles d’IA sur appareil plus grands et plus performants.

« Je ne vais pas parler au nom des équipementiers. Mais il y a un gros avantage. Pour la RAM, en général, cela va augmenter les performances », a expliqué Wheatton. Il a ajouté que la richesse et « ce que nous percevons comme l’étendue des connaissances » des modèles d’IA est liée à la taille du modèle.

Il a noté qu’un modèle d’IA devrait rester dans la RAM, car l’utilisation du stockage flash entraînerait des temps de chargement lents.

Vous voulez pousser 10, 20, 40 jetons par seconde. Cela va lui permettre d’obtenir de bons résultats et presque une conversation, et des choses comme ça. Il faut donc vraiment que ce soit de la RAM, et c’est pourquoi la RAM est si importante.

Cela signifie-t-il que les téléphones qui manquent de RAM (par exemple avec 6 Go ou 8 Go de RAM) seraient dans une certaine mesure exclus de la boucle ?

Whealton ne prévoit pas d’exigence minimale de RAM pour l’IA générative sur l’appareil, notant plutôt que plus de RAM permettra « une forte augmentation » des fonctionnalités :

Je ne dirais donc pas qu’il existe une limite pour dire « vous êtes en quelque sorte hors du courant ». Je dirais que les résultats seront considérablement meilleurs à mesure que vous prendrez en charge davantage de RAM.

Sascha Segan, responsable des relations publiques chez Qualcomm, suggère également un avenir hybride pour les smartphones qui pourraient ne pas être en mesure de contenir un grand modèle d’IA sur l’appareil. Nous pourrions voir un téléphone offrir un modèle d’IA beaucoup plus petit sur l’appareil, permettant toujours un traitement local, mais l’appareil pourrait alors vérifier ces résultats par rapport à un modèle plus grand basé sur le cloud.

Une approche par force brute en offrant une tonne de RAM pour contenir des modèles d’IA génératifs est une solution. Mais nous avons également constaté une tendance à réduire ou à quantifier les modèles d’IA pour réduire leur empreinte. Ainsi, la prise en charge de la précision INT4 et INT8 continue d’être un moyen clé de réduire les modèles d’IA génératifs et de les exécuter sur des appareils dotés de moins de RAM, tels que les anciens produits phares et les téléphones de milieu de gamme. Heureusement, Qualcomm et son rival MediaTek prennent en charge cette fonctionnalité.

En mettant tout cela ensemble, il est clair que les modèles d’IA générative joueront un rôle de plus en plus important dans les prochains appareils mobiles. Alors que la plupart des téléphones actuels dépendent du cloud, le traitement sur l’appareil sera la clé pour améliorer la sécurité et les fonctionnalités. Cela nécessitera des puces plus puissantes, plus de mémoire et des techniques intelligentes de compression d’IA.

Nous sommes impatients de voir comment le matériel des smartphones de 2024 évoluera grâce à l’IA générative. Et il semble que les fournisseurs de chipsets aient déjà quelques idées en tête.

->Google Actualités