Intel, lors de son événement Innovation 2023, a annoncé la gamme de processeurs Meteor Lake de 14e génération, dotée d’une grande variété d’améliorations et de nouvelles fonctionnalités. Bien que le processus Intel 4, une architecture désagrégée et les graphiques intégrés Intel Arc soient des mises à niveau intéressantes, les utilisateurs apprécieront les fonctionnalités d’IA auxquelles les puces Meteor Lake sont intégrées. Intel a annoncé qu’il apporterait l’intelligence artificielle aux PC modernes grâce à une toute nouvelle unité de traitement neuronal (NPU) dans les processeurs Meteor Lake de 14e génération. Mais qu’est-ce que le NPU et en quoi va-t-il aider ? Parlons-en ci-dessous.

Intel apporte pour la première fois le NPU aux puces client

Alors que l’intelligence artificielle est largement utilisée en ligne, être sur le cloud a des limites. Les plus importants d’entre eux incluent les problèmes de latence et de connectivité élevés. UN Unité de traitement neuronal (ou NPU) est une unité dédiée au CPU pour le traitement des tâches d’IA. Ainsi, au lieu de s’appuyer sur le cloud, tous les traitements liés à l’IA sont effectués sur l’appareil lui-même. Le nouveau NPU d’Intel sera capable de faire exactement cela.

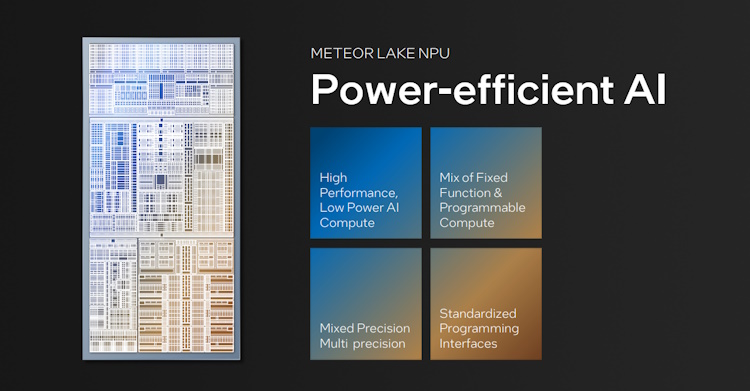

Bien qu’Intel expérimente l’IA depuis un certain temps, ce sera la première fois que la société intégrera un NPU au silicium côté client. Le NPU sur les puces Meteor Lake est un moteur d’IA dédié à faible consommation qui peut gérer des charges de travail d’IA soutenues à la fois hors ligne et en ligne.

Cela signifie qu’au lieu de compter sur des programmes d’IA pour faire le gros du travail depuis Internet ; vous pourrez utiliser le NPU Intel pour effectuer le même travail tel que l’édition d’images AI, la séparation audio, etc. Disposer d’un NPU sur l’appareil pour le traitement et l’inférence de l’IA présentera sans aucun doute de nombreux avantages.

Puisqu’il n’y aura pas de latence, les utilisateurs peuvent s’attendre à un traitement et à une sortie ultra-rapides. De plus, le NPU d’Intel aidera améliorer la confidentialité et la sécurité avec les protocoles de sécurité de la puce. On peut affirmer sans se tromper que vous pourrez utiliser l’IA de manière plus interchangeable, et cela aussi quotidiennement.

Intel NPU peut échanger durablement les charges de travail

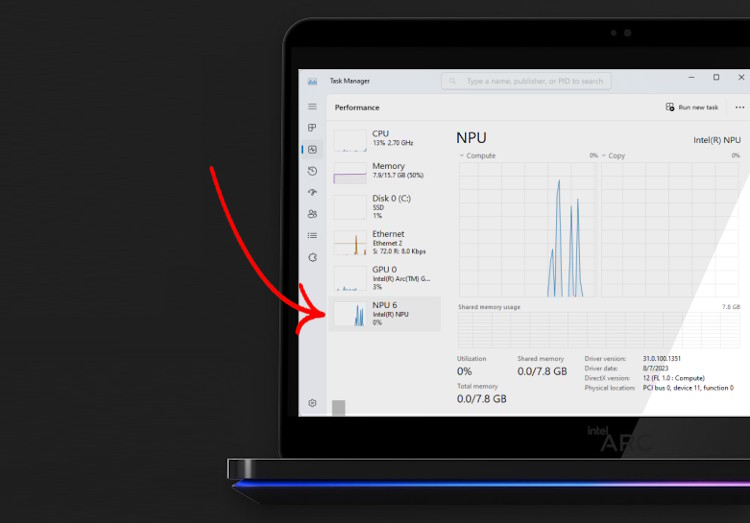

Le NPU Intel a été divisé en deux parties principales qui font chacune leur travail. Il s’agit de la gestion des appareils et de la gestion du calcul. Le premier prend en charge un nouveau modèle de pilote pour Microsoft appelé le Modèle de pilote de calcul Microsoft (MCDM). Ceci est essentiel pour faciliter le traitement de l’IA sur l’appareil. De plus, en raison de ce modèle de pilote, les utilisateurs pourront voir le NPU Intel dans le Gestionnaire des tâches de Windows avec le CPU et le GPU.

Intel travaille sur le modèle de pilote susmentionné avec Microsoft depuis six ans. Cela a permis à l’entreprise de garantir que le NPU exécute efficacement les tâches tout en gérant l’énergie de manière dynamique. Cela signifie que le NPU peut rapidement passer à un état de faible consommation pour supporter ces charges de travail et inversement.

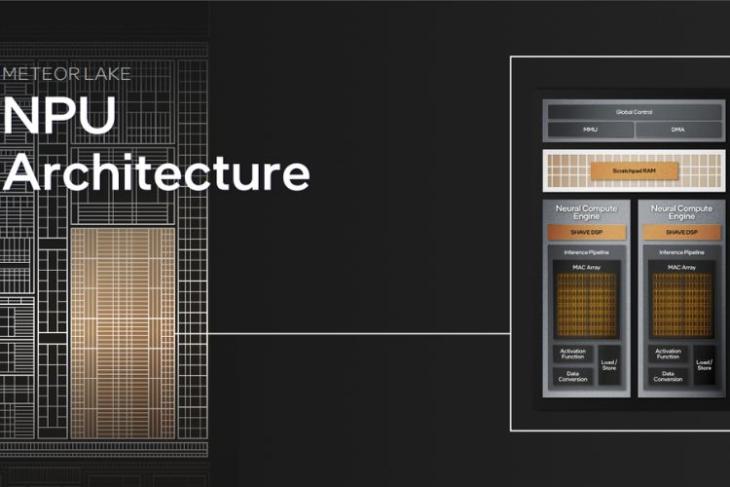

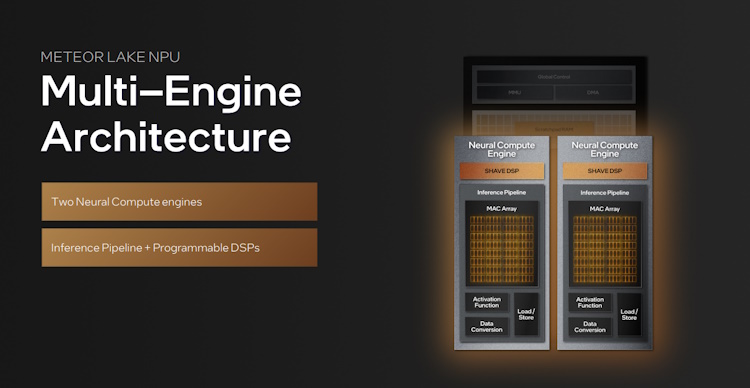

Le NPU Intel Meteor Lake utilise une architecture multimoteur. À l’intérieur se trouvent deux moteurs de calcul neuronaux. Ceux-ci peuvent fonctionner sur deux charges de travail différentes ou ensemble sur la même. Au sein du moteur neuronal se trouve le pipeline d’inférence, qui agit comme un composant essentiel et aidera le fonctionnement du NPU.

Le NPU d’Intel rend possible l’IA sur appareil

Bien que le fonctionnement réel du NPU soit bien plus profond, les utilisateurs peuvent s’attendre à de nombreuses premières avec la nouvelle architecture Meteor Lake. Avec l’arrivée du traitement de l’IA sur l’appareil sur les puces grand public d’Intel, il sera passionnant de voir leur gamme d’applications. De plus, la présence du NPU Intel Meteor Lake de 14e génération dans le gestionnaire de tâches, bien que cela semble simple, indique que les consommateurs pourront en tirer profit. Il faudra cependant attendre le déploiement pour voir jusqu’où nous pouvons le pousser.

Image en vedette avec l’aimable autorisation : Intel