Apple a publié un tas de nouvelles fonctionnalités d’accessibilité pour iOS et iPadOS. Le géant de Cupertino redouble d’efforts pour faire « la technologie accessible à tous” avec cette mise à jour. Les nouvelles améliorations en matière d’accessibilité, notamment l’accessibilité cognitive, Live Speech, etc., tireront parti du matériel embarqué et des capacités d’apprentissage automatique des appareils. Continuez à lire ci-dessous pour en savoir plus.

Nouvelles fonctionnalités d’accessibilité pour iPhone et iPad

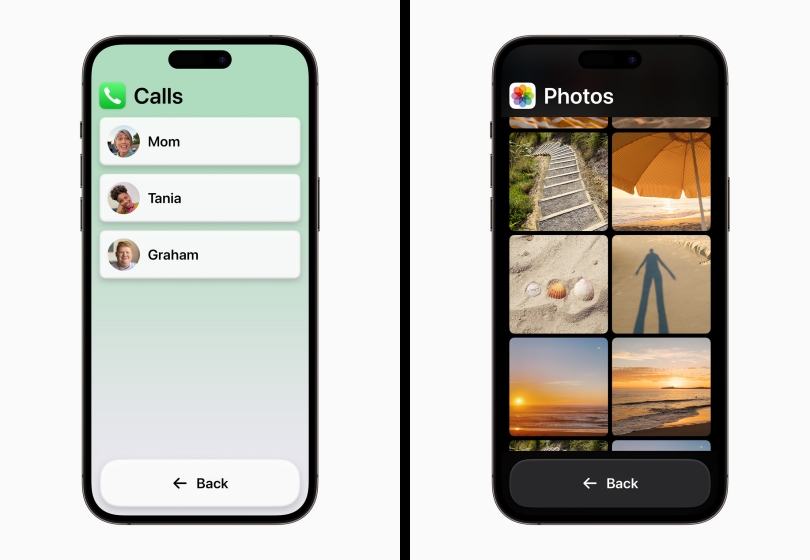

L’une des fonctionnalités récemment annoncées est Accès assisté pour les troubles cognitifs. Comme son nom l’indique, les utilisateurs souffrant de complications telles que l’autisme, la maladie d’Alzheimer, etc. ont généralement du mal à naviguer dans les éléments de leur smartphone. Cette fonctionnalité désencombrera les applications et les éléments du système d’exploitation pour ne conserver que les fonctionnalités de base intactes.

Cette fonctionnalité fonctionnera avec le téléphone, FaceTime, l’appareil photo et d’autres applications de conduite quotidiennes. Lorsque cette fonctionnalité est activée, les utilisateurs pourront interagir avec texte agrandi et boutons à contraste élevé et uniquement les fonctionnalités qui comptent. Ceci s’appuie sur les données et les commentaires recueillis auprès de supporters de confiance et de personnes atteintes de troubles cognitifs.

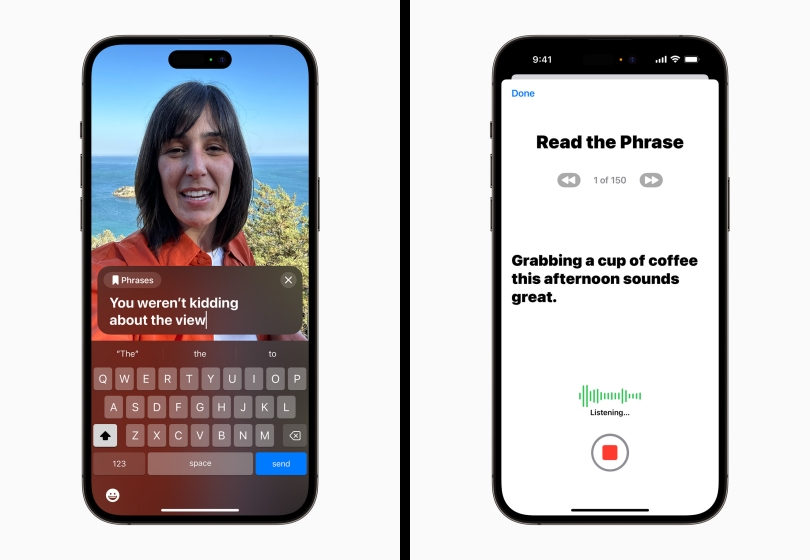

Une autre nouvelle fonctionnalité est Discours en direct et voix personnelle, qui vise à rendre la technologie accessible aux personnes souffrant de troubles de la voix comme la SLA. La fonction Live Speech permettra aux utilisateurs de taper leurs mots, puis de laisser leur iPhone ou iPad les exprimer à haute voix. Cette fonctionnalité sera utile lors des conversations en personne et des conversations virtuelles.

D’autre part, le Voix personnelle est un cran au-dessus de la fonction Live Speech. Il permet aux utilisateurs présentant des troubles vocaux précoces d’enregistrer une empreinte audio de leur propre voix. Cela signifie que chaque fois que vous voulez communiquer avec quelqu’un et que vous tapez votre réponse, elle jouera dans votre propre voix plutôt qu’une voix robotique générique. La fonctionnalité utilise l’apprentissage automatique sur l’appareil et un ensemble d’invites prédéfinies pour créer votre empreinte vocale de manière sûre et sécurisée.

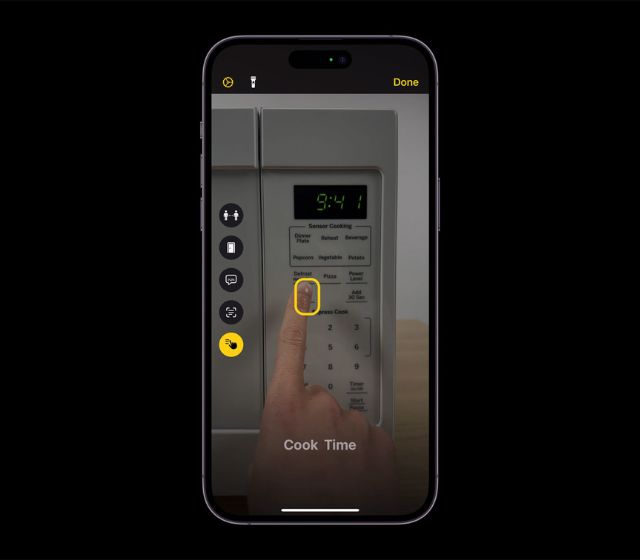

Pour les utilisateurs malvoyants ou qui perdent leur capacité à voir, Apple a introduit une fonctionnalité d’accessibilité appelée Pointer et parler pour le mode de détection dans la loupe. Cette fonctionnalité permettra aux utilisateurs de recevoir des invites audio pour les éléments contenant du texte. Par exemple, si vous tapez sur votre clavier, chaque frappe sera associée à une invite vocale. Apple est capable de réaliser cet exploit en combinant le capteur LiDAR intégré à l’appareil, l’application appareil photo et les capacités d’apprentissage automatique. À l’aide de la fonction de loupe, les utilisateurs peuvent obtenir des invites vocales pour tous les éléments de texte sélectionnés par l’application de l’appareil photo.

Certaines des autres annonces incluent des appareils auditifs Made for iPhone pour les utilisateurs souffrant de déficiences auditives, des guides de contrôle vocal pour les utilisateurs afin d’apprendre des trucs et astuces sur les fonctionnalités de contrôle vocal, et bien plus encore. Apple commencera à déployer ces fonctionnalités d’accessibilité pour les utilisateurs d’iPhone et d’iPad d’ici la fin de cette année. Alors, que pensez-vous de ces nouvelles améliorations d’accessibilité ? Pensez-vous que ces fonctionnalités vous seront bénéfiques d’une manière ou d’une autre ? Commentez vos pensées ci-dessous.

![[2023] 6 façons de copier / coller du texte brut sans formatage](https://media.techtribune.net/uploads/2021/03/5-Ways-to-Copy-Paste-Plain-Text-Without-Formatting-on-Your-Computer-shutterstock-website-238x178.jpg)